作为一个经常在 GitHub 上晃悠的 Python 选手,看到这个必须来回答一下!

推荐 6 个 Python 爬虫项目!废话不多说,直接开整!

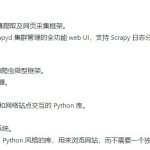

1、awesom-spider(16.9 k+ star)

收集各种爬虫的爬虫合集,按照首字母 A~Z 分类。

不多说,给你们截点内容看看:

2、proxy_pool(14.3k+ star)

爬虫代理IP池项目,主要功能为定时采集网上发布的免费代理验证入库,定时验证入库的代理保证代理的可用性,提供API和CLI两种使用方式。

同时也可以扩展代理源以增加代理池IP的质量和数量。

该项目设计文档详细、模块结构简明易懂,同时适合爬虫新手更好的学习爬虫技术。

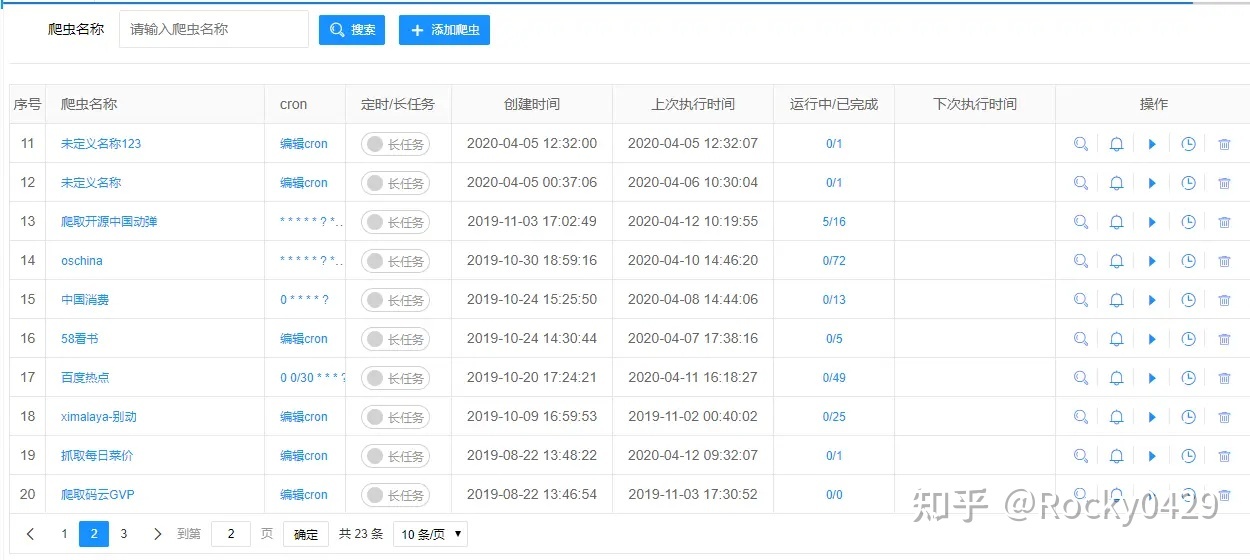

3、spider-flow(6k+ star)

智能高效的在线爬虫。

平台以流程图的方式定义爬虫,是一个高度灵活可配置的爬虫平台。

最强的是,无需写代码就可以快速完成一个简单的爬虫。

4、weiboSpider(5k+ star)

Python 写的微博爬虫,命令行直接启动。

可以连续爬取一个或多个新浪微博用户的数据,并将结果信息写入文件或数据库。写入信息几乎包括用户微博的所有数据,包括用户信息和微博信息两大类。

支持获取微博用户、内容字段丰富。

# 安装

$ git clone https://github.com/dataabc/weiboSpider.git

$ cd weiboSpider

$ pip install -r requirements.txt

# 启动

$ python3 -m weibo_spider5、PSpider(1.6k+ star)

简单易用的Python爬虫框架。

代码量极少,功能却很完备,包含:

- 抓取

- 解析

- 存储等

- …

代码量少,方便阅读源码,动手修改及二次开发。

6、awesome-python-login-model(14.1k+ star)、

该项目收集了各大网站登陆方式和部分网站的爬虫程序。

登陆方式实现包含 selenium 登录、通过抓包直接模拟登录等。有助于新手研究、编写爬虫。

既然说到了爬虫,其实不只是 GitHub 上有,这里我再推荐 3 个练手的爬虫项目吧。

Python 爬虫破解抢票和秒杀程序

学会了,抢票不是梦。

学会了,秒杀算什么!

轻松获取疫情数据

疫情数据哪里来?

整天在网上看疫情数据,哪有自己整个疫情可视化来的强。

采集一下世界各国疫情数据,整整全国各省疫情数据,美的不行。