前几天,一个视频换人视频从 X 上火到微博。

就是这个视频,右下角边是原始的主播,一个男的;左边是 AI 换脸+换人之后的视频,变成了一个个楚楚动人的美女,但口型、动作、甚至光影都和右边的男的一模一样。

怎么样?是不是感觉非常真实,甚至有点毛骨悚然?

视频原作者@深夜聊AI 这两天发了篇复盘文章介绍,这个曝光量全网超过了千万流量。

其实,老粉们可能知道,这种视频换脸、动作捕捉的玩法,并不是什么新鲜事了。

但为什么,偏偏是这一次,它又火出圈了呢?

火爆的背后原因?

我仔细想了下,这波热潮的引爆点,不仅仅是技术效果好,当然,效果确实好,更重要的是这个视频呈现和传播的方式。

首先,最具杀伤力的,就是同屏对比的呈现方式。

以前我们看 AI 换脸,你只看到一个结果。比如一段马斯克说中文的视频,你觉得很牛,但你不知道原料是什么样的。

而这次刷屏的视频,它非常聪明地把换人前和换人后放在了同一个画面里。这种强烈的、实时的对比,带来的视觉冲击力是指数级增长的。

你的大脑会不自觉地去比较两边的每一个细节:哎,你看,左边大汉抬手了,右边美女也抬手了;左边光线暗下来了,右边也暗下来了!

这种所见即所得的对比,是最好的技术说明书。

其次,它找到了一个刚需的应用场景。

视频里换的是谁?是一个坐在镜头前讲话的人,这恰恰是很多自媒体人的常用姿势。

这一下就点燃了无数内容创作者的想象力,有多少人想做视频、想做直播,但又不愿意真人出镜?或者觉得自己的形象不够上镜?

现在,这个问题解决了。你可以让 AI 生成一个完美的数字替身,而你只需要在幕后提供动作和声音。这个应用场景太明确,太有钱景了。

最后,是性别反差带来的病毒式传播点。

美女 VS 大汉。这种强烈的反差,本身就是流量密码。它直接把这个技术的魔力拉满了。

如果只是把一个帅哥换成另一个帅哥,传播度绝对没有现在这么广。

这种反差带来的戏剧性,让普通人也乐于转发和讨论。所以你看,技术很重要,但如何「讲好一个技术的故事」同样重要。

动作模仿

这么火的玩法,我肯定要亲手去玩一遍。引爆这次热潮的主角,是通义万相 2.2-Animate 模型。

我必须说,玩过之后,我更震惊了:这个玩法的门槛,几乎约等于 0!

不需要复杂的部署,不需要昂贵的显卡,不需要敲一行代码。你只需要点点鼠标,上传图片和视频,AI 就能帮你搞定一切。

大家跟着我一步一步来就行。

1.首先需要在准备替换人物的视频中截一张图,建议最好截图视频的全部,不能只截部分,不然会影响效果。

这个就是我在自己 B 站视频中截的一张图。

再准备一张替换我自己的角色图,我随机找了一张美女图片。

把这两张图放在即梦中,生成和替换视频中背景一样的图。

参考提示词:将图片 1 的主体人物替换为图 2 中的主体人物,脸型保留图 2 的长相样貌,动作参考图片 1 中的人物姿势,保持背景不变

记得生成的图片比例一定选择一致。

生成的图片如下:

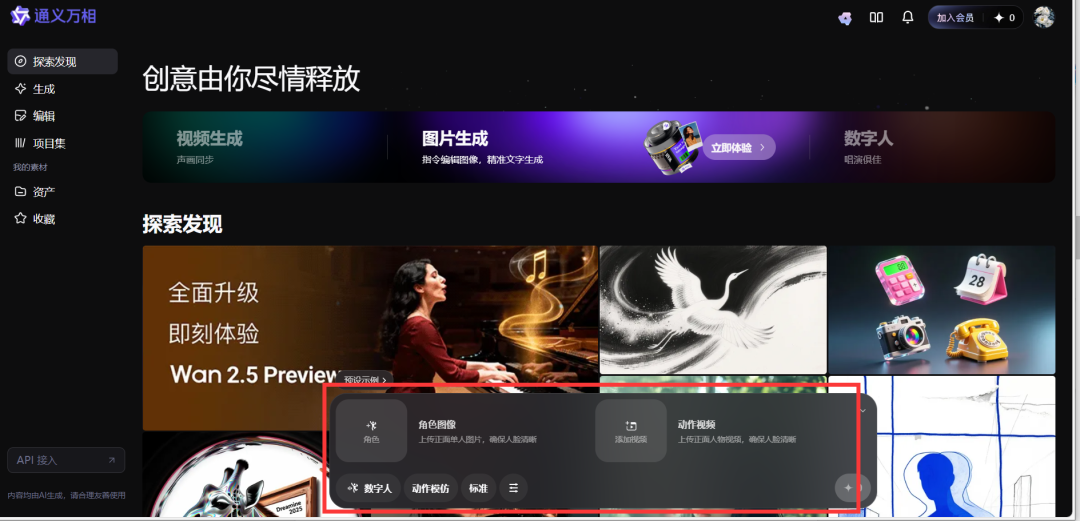

2.用通义万相 2.2 制作替换视频。

进入官网:

https://tongyi.aliyun.com/wan/explore

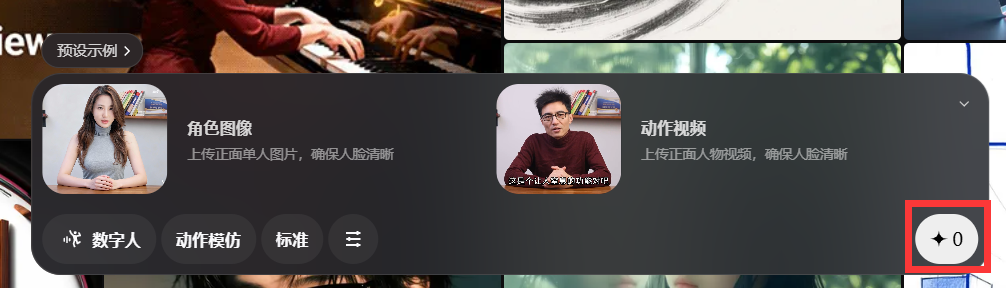

在底部找到数字人——动作模仿。

上传即梦生成的图片,再上传需要替换人物的视频,再点击右下角红框中的选项就可以开始了。

不需要会员,也不需要耗费积分,大概等五六分钟就完成了。

虽然也可以本地部署,但在官网上直接生成是目前最简单的体验方法,可惜的是替换的视频目前只支持最长 15 秒。

就这么简单,视频中的我都被美女们给替换掉了,虽然来回替换了好几个美女,但是美女们的动作、表情,以及视频里的光线,都和原始视频保持一致。

就连 AI 视频中经常出问题的手指,不仔细看的话破绽也不是特别明显。

为了验证效果,我又找了美女来替换其他博主的视频。

这个博主的动作相比于我来说,更加复杂,手势又多,头还摇来摇去,但是替换后的视频却基本都完美的模仿了下来。

尤其是美女说 MAX 时的口型,即使不听声音观看口型都知道她说的是 MAX ,可见动作模仿时的精确度。

这个老师开讲座的视频,原视频光线稍微暗一点,再来看替换主角后的视频,女生全身的光线同样也比较暗,很好的融入了环境。

女生的头发也随身体的摆动而摆动,肉眼可见的细节,绝对让你以为这就是原始视频。

还有斯嘉丽替换男生跳舞的视频,我就不多说了吧,动作百分百一致,不过脸型稍微有点崩。

这个制作流程是不是简单到令人发指?而效果更是让人难辨真假。

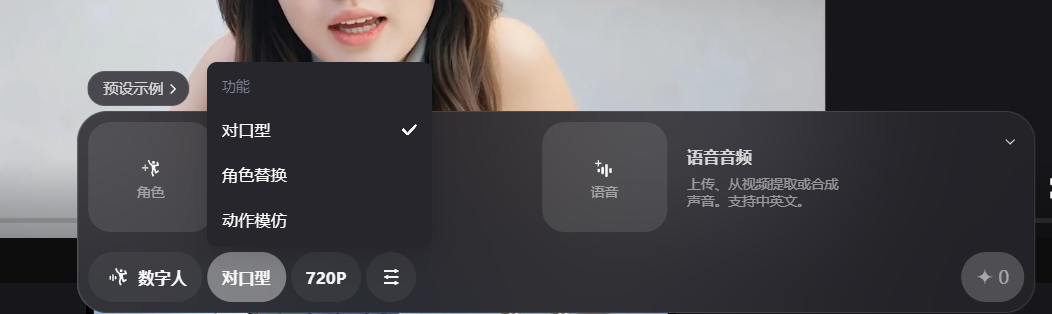

对口型

我在玩动作模仿功能的时候,发现它还有一个对口型的功能。

有这个功能,那根本不用自己录了口播视频再替换,直接上传一张美女图,再上传一段语音就可以了。

如此一来,找人替自己做主播这件事更简单了。

这就是用通义千问生成的对口型视频,说实话,动作稍显生硬。

我想起来,其实即梦也有以上这些类似的功能,用的人还不少。

就顺便用即梦也生成了一段对口型的视频,一对比,即梦生成的视频就自然多了,虽然那个捋头发的动作,稍显刻意,不过整体要比通义的更像真人。

即梦对口型效果这么好,那正好把上次生成的潘金莲声音配上画面,让大家感受一下,尤其是没看上那篇被删文章小伙伴们。

怎么样,这口型,多自然?这眼神,这姿态,有没有魅惑到你呢?

结语

最后,我想聊一点技术之外的,更严肃的话题。

这技术,是不是一把双刃剑?因为门槛约等于 0 ,意味着人人可用。

那个刷屏视频里,美女换大汉,大家哈哈一笑。但如果换的不是大汉,而是你的脸呢?

如果有人拿到了你的照片,去合成一段你的视频,用来诈骗、造谣,或者做更糟糕的事情……这个后果谁来承担?

技术的发展速度,永远快于法规的制定速度。

我们眼下,正处在一个 AI 技术发展如火如荼,但管控尺度相对比较宽松的草莽时期。

随着 AIGC 技术(尤其是视频生成)的门槛无限降低,它带来的社会伦理风险也会被无限放大。当眼见不再为实,社会的信任基石都会被动摇。

对此类内容的管控,势必会收紧。

我在想,有没有可能会在未来,所有的 AI 视频生成文件中,都被强制加入可以溯源的数字水印?

比如,我用通义万相生成的这些视频,虽然看起来和普通视频没区别,但在它的数据帧里,隐藏着一串加密信息,标记着:「此视频由通义万相在 2025 年 10 月 30 日生成,生成者账号 ID 为 XXXXX」。

这并非不可能。

当技术的潘多拉魔盒被打开时,我们作为超级个体,在享受技术红利、体验科技乐趣的同时,或许也该多一分敬畏,守住自己的底线。

本文已在公众号网罗灯下黑(ID:wldxh8)首发。

公众号简介:一个非技术出身的AIGC日记,写给正在和硅基共舞的你