作者:曹操

链接:https://www.zhihu.com/question/648879790/answer/32312857057

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

Ollama

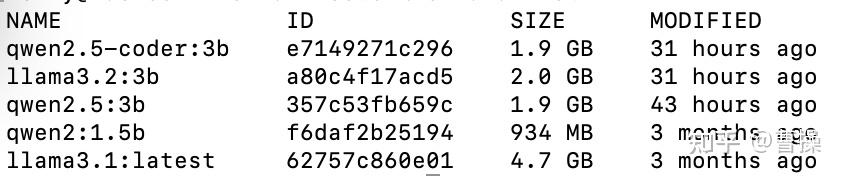

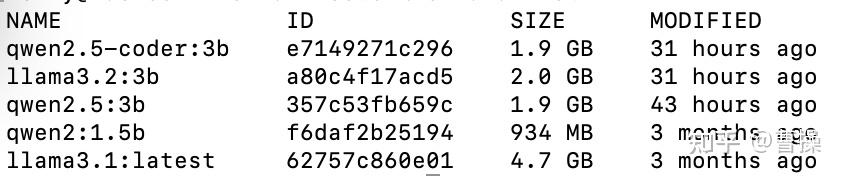

ollama list 显示结果

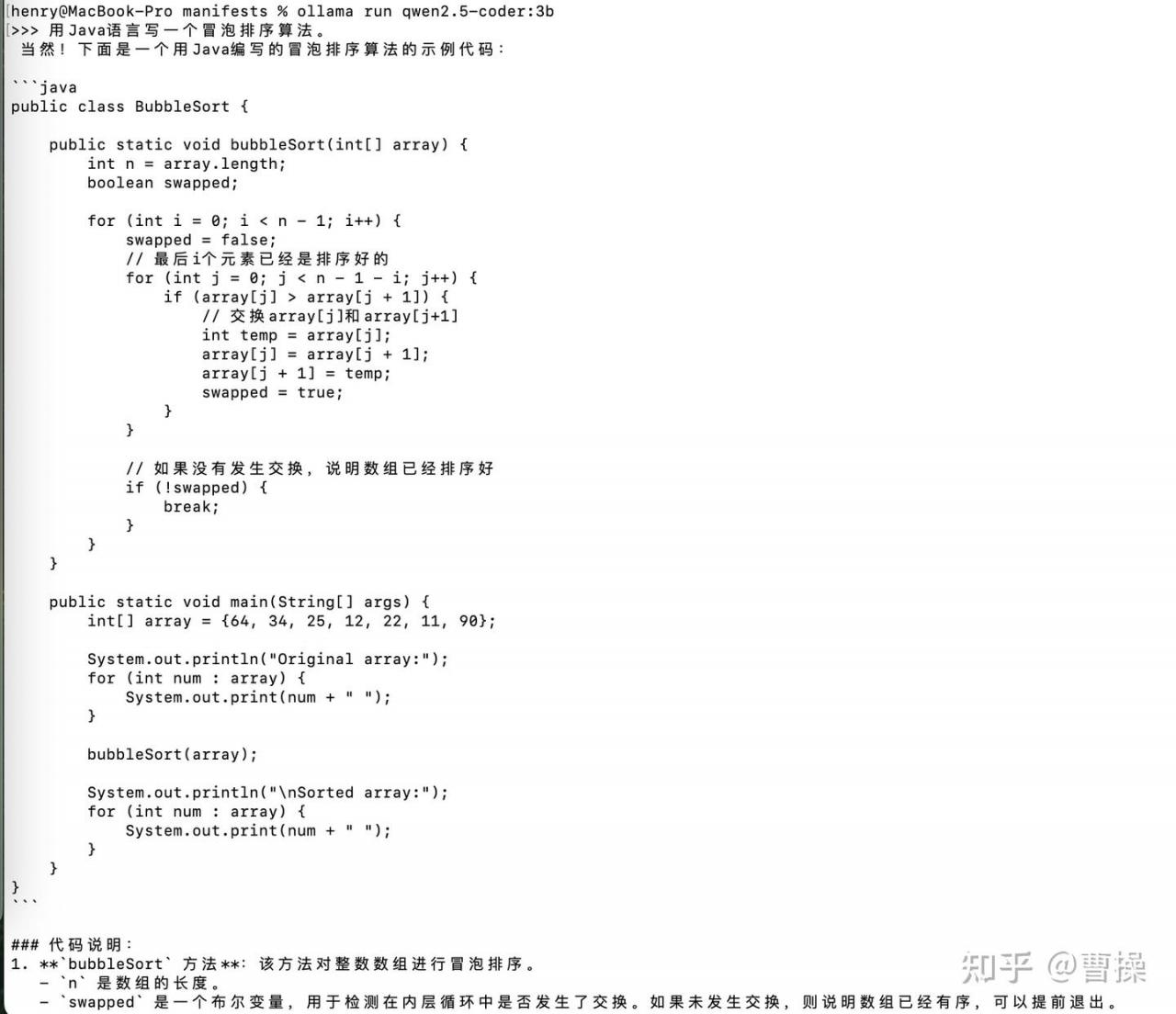

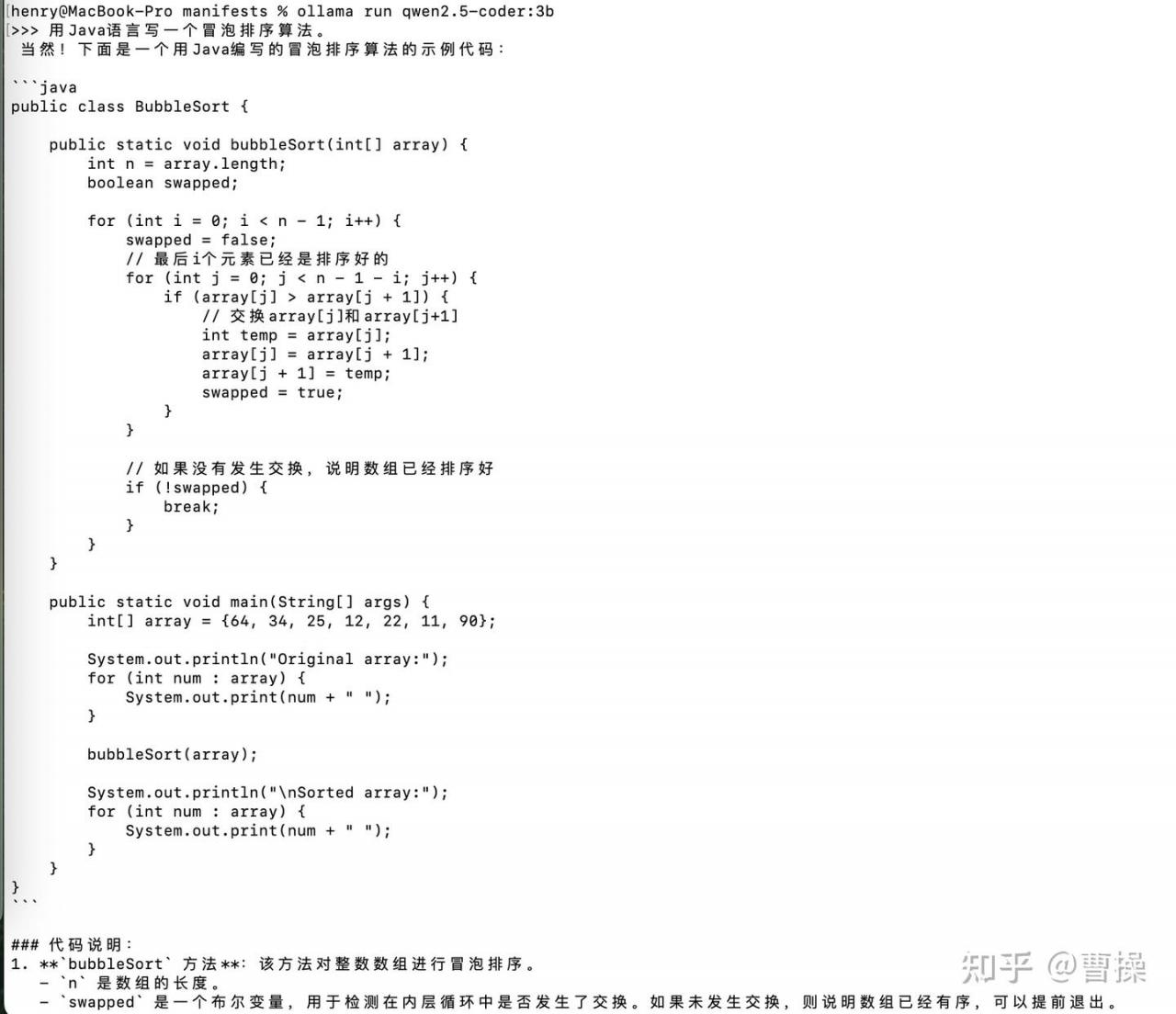

与模型对话

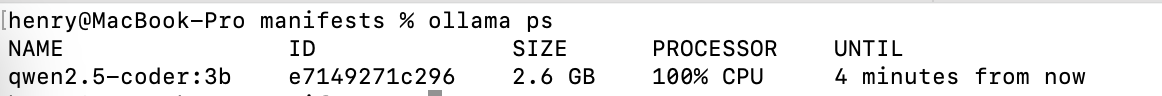

ollama ps运行结果

链接:https://www.zhihu.com/question/648879790/answer/32312857057

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

说明

Ollama是一个本地部署大语言模型的工具。

官方网站为 ollama.com

标志为一只小羊驼。

支持平台:Windows,macOS,Linux

安装

安装方式:

Windows,macOS下载安装包打开安装即可。

Linux提供了安装脚本

curl -fsSL https://ollama.com/install.sh | sh安装完成后打开会在状态栏出现一个小羊驼的标志。点击之后一个退出选项(以macOS为例)。

所以目前Ollama官方只提供了一系列基于命令行的操作。

使用

Ollama提供了一系列操作命令。

在终端输入 ollama -h 即可显示:

ollama -h

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information常用命令

启动ollama服务

ollama server模型会以服务的模式启动。默认运行端口为11434。默认绑定地址为127.0.0.1,即只可本机访问。

部署模型到本地

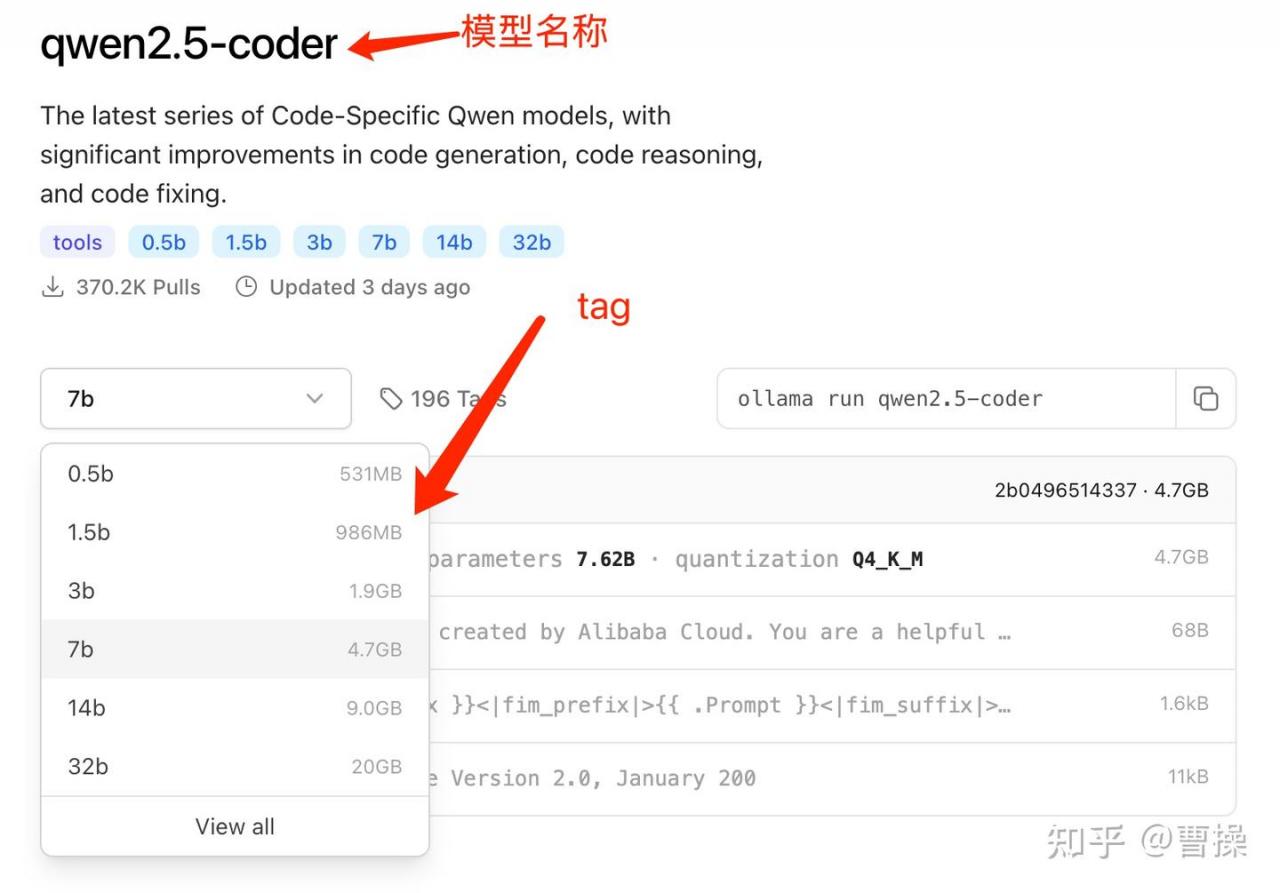

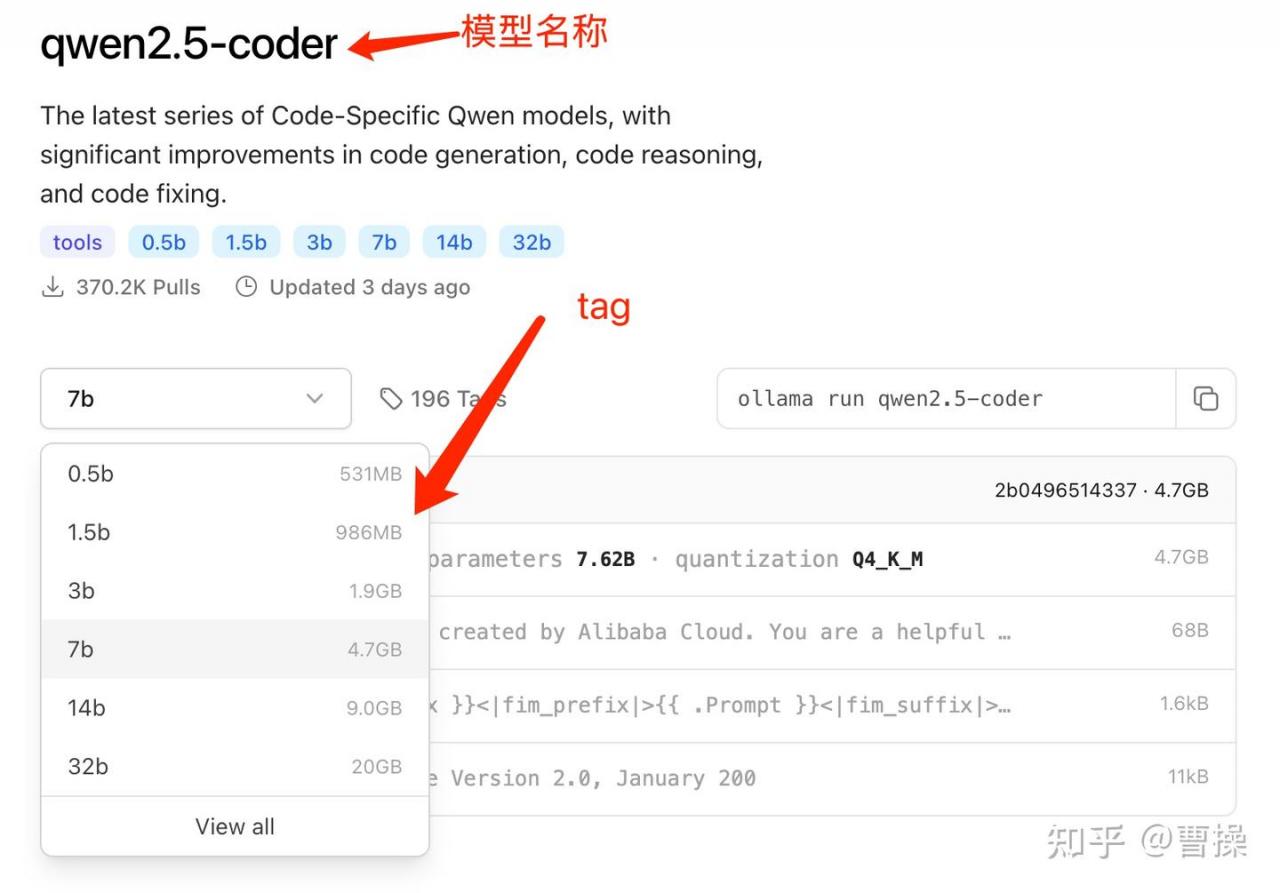

ollama维护了一个模型库中心。地址为 Models

ollama pull 模型名称:tag注意:每个模型可能包含多个tag,一般对应不同的参数规模。如果不指定tag,则默认部署latest版本。一般建议加上tag,即便使用latest版本,便于维护。如下图:

查看本地已部署的模型

ollama list

删除本地模型

ollama rm 模型name模型 name 以前面 list 显示的name。

运行模型

ollama run 模型name如果模型在本地不存在,则会先执行pull,再run。运行成功后即可开启与模型的对话。

若要退出对话,输入 /bye 即可。

查看当前正在运行的模型及状态

ollama ps

停止模型运行

ollama stop 模型name或者在对话界面输入 /bye