链接:https://zhuanlan.zhihu.com/p/20884665776

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

用Rag技术搭建一个本地的个人助手,使用的是AnythingLLM+DeepSeek的组合。体验下来,这个只能作为POC或体验之类的,很难真正实现一个工程性需求。

第一步,下载开源的AI应用程序AnythingLLM

去官网Download AnythingLLM for Desktop下载并安装即可。

第二步,下载Ollama并获取DeepSeek LLM

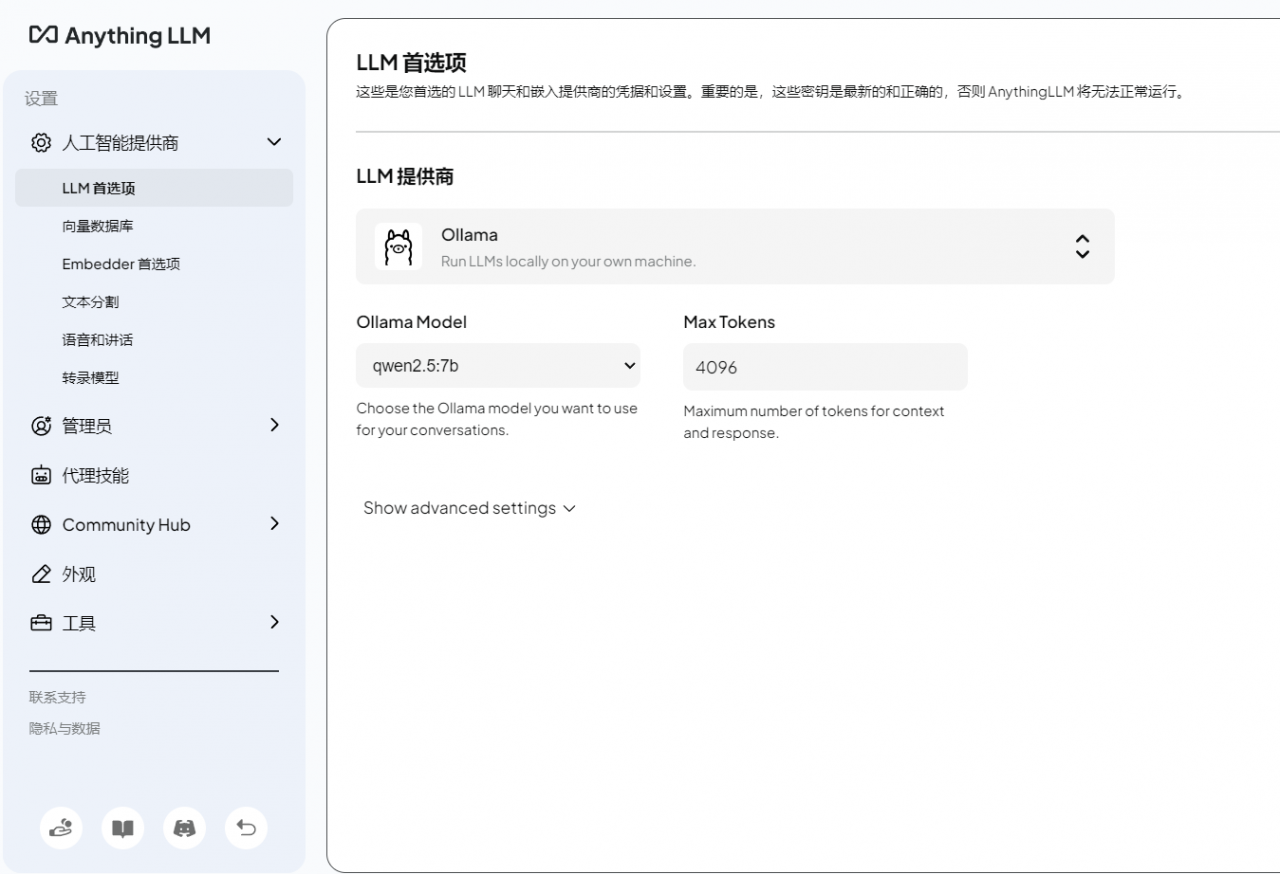

因为AnythingLLM自带的只有qwen2.5 7b这个模型,为了使用DeepSeek我们需要先下载Ollama并获取DeepSeek。

1、打开 Ollama 的官网http://ollama.com,在官网找到 “Download”,点击下载并安装。

2、安装完成后cmd运行下面的命令看是否安装正确。

ollama list3、cmd命令行输入如下命令下载DeepSeek大模型并运行。

ollama run deepseek-r1:7b需要等待一些时间(耗时长短和你机器的配置有关)。

第三步,配置新工作区

1、接下来就可以创建新工作区,我这里想搭建一个自己的数字化助手。

创建完之后,将LLM提供者改为刚下载的deepseek-r1:7b。

2、上传各种知识。

3、选中需要的文档,然后点击Move to Workspace,在右边区域点击Save and Embed进行向量化处理。

4、点击New Thread开始对话。

实际体验下来,对于本地文档的解析和检索确实有点差强人意,参考官网的说明调整了下参数,好像也不太见成效。

Why does the LLM not use my documents ~ AnythingLLM

不管怎么样,通过AnythingLLM体验一下RAG的搭建和使用过程还是不错的,真要企业级应用,看来还是得基于LlamaIndex或Langchain手搓一个。

参考:

1、崛起太难了,DeepSeek API大年初二仍未恢复!也别担心:小白3步调用国产强大模型DeepSeek R1 本地版