链接:https://www.zhihu.com/question/10630134422/answer/90907825608

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

如今,越来越多的公司在关注数据安全和AI的应用,尤其是在企业内部需要用到AI的场景下,如何避免数据泄露,同时充分利用AI模型,成为了亟待解决的问题。尤其是对于资源不充裕的小公司或个人开发者,如何让老旧笔记本也能跑出企业级AI,并且确保数据安全,是个非常实际的难题。

好消息来了!DeepSeek R1不仅支持本地化部署,而且能够通过web端访问,打造专属于自己的AI个人知识库,而且这种方式非常适合低配的电脑。今天,我就给大家带来一个详细的操作教程,即便是没有AI背景的你,也能跟着步骤轻松完成配置,马上进入AI应用的新时代!

一、DeepSeek R1本地化部署

1.1 下载Ollama+PC本地部署

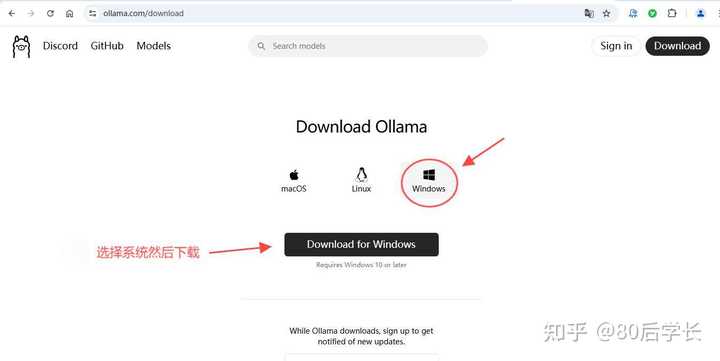

首先,访问Ollama官网:https://ollama.com/下载并安装:根据您的操作系统(Windows、macOS等)选择合适的版本进行下载和安装。。Ollama目前支持Windows、Linux和macOS三个操作系统。根据你的操作系统,选择合适的版本进行下载。

Windows用户可以直接下载并安装。

Linux用户需要执行以下命令来安装:

curl fsSL https://ollama.com/install.sh | sh安装完成后,就可以开始下一步了。

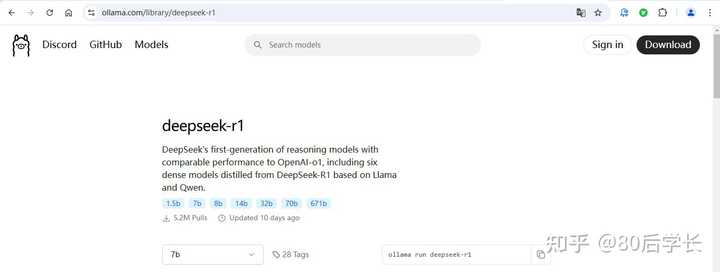

1.2 选择deepseek-r1模型

在安装好Ollama后,返回Ollama官网,点击上方导航栏右侧的Models,可以看到deepseek-r1模型,这是我们接下来要使用的模型。如果你找不到,可以通过搜索框输入“deepseekr1”来快速定位。

DeepSeek R1提供了多个模型,参数量越大,模型的能力越强,但对硬件的要求也会更高。如果你的设备性能不算顶尖,可以选择参数量较小的模型。(下图为DeepSeek R1各模型版本对应的电脑配置,供参考)

以家用电脑Windows11操作系统为例,模型:DeepSeek-R1 1.5B为例:

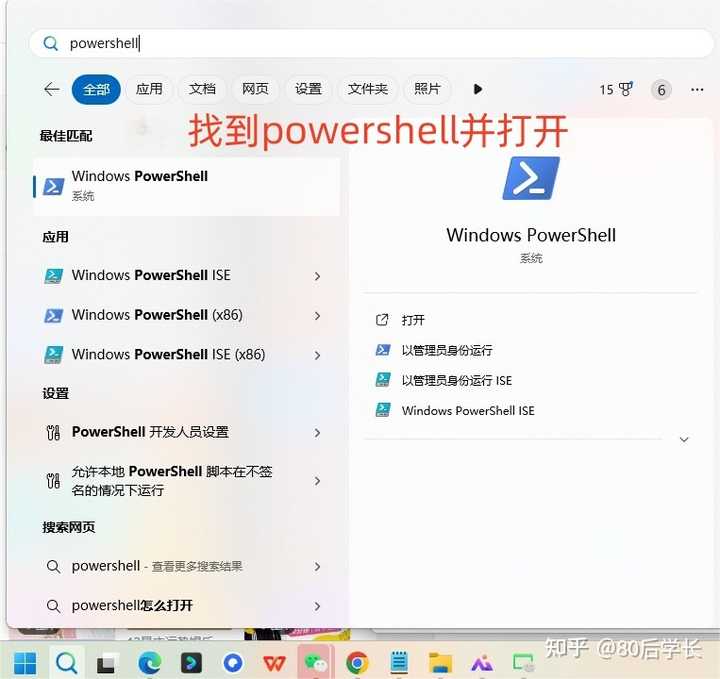

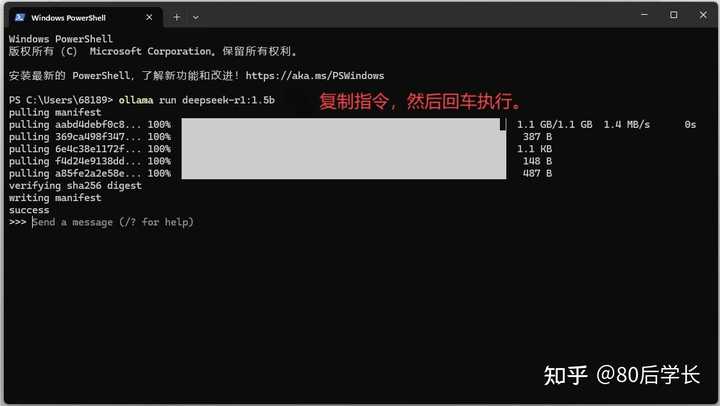

点击开始,搜索PowerShell开始使用

deepseek-r1 模型版本 1.5B” 中的“1.5B”代表的是模型中参数的数量单位为百万(百万),即1,500万参数。这指的是模型中有 1500 万个参数,决定了其推理速度和模型的复杂程度。适合大多数普通配置的电脑。如果你的电脑配置较高,也可以选择7b命令,体验更强大的性能。7B 表示模型中有 7,000 万个参数,7B vs 1.5B:虽然“7B”和“1.5B”参数数量相近,但前者在性能上更优。

1.3 运行命令

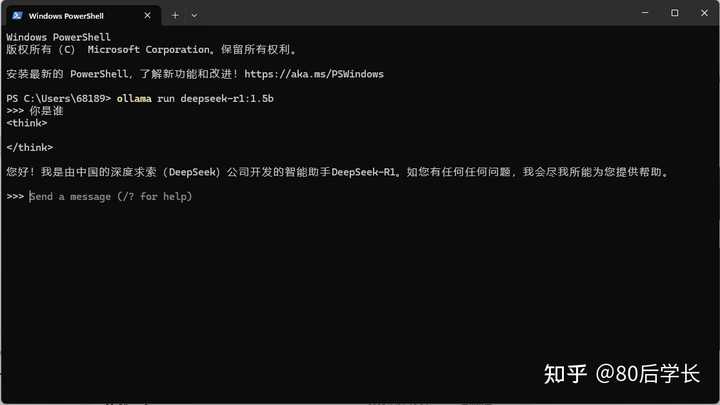

选择好模型后,点击运行命令,等待程序启动。几秒钟后,如果看到success,说明部署成功。你可以输入简单的提问,如“你是谁”,看看模型的回答。如果一切顺利,恭喜你,本地化部署已经完成!

1.4 测试效果

为了确保一切正常运行,你可以测试一下模型的回答,像是提问“请用知乎的文章写作风格夸一夸最近爆火的 DeepSeek-R1模型”等问题,看看模型是否能够给出准确的回答。

1.5常见问题

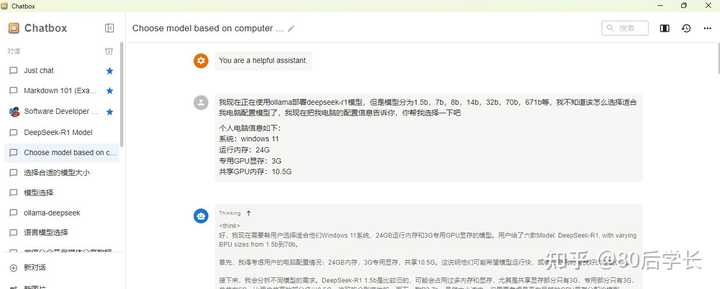

如果不知道自己的电脑配置能运行DeepSeek-R1怎样的版本,可以这样提问:

提示词:

我现在正在使用ollama部署deepseek-r1模型,但是模型分为1.5b,7b,8b,14b,32b,70b,671b等,我不知道该怎么选择适合我电脑配置模型了,我现在把我电脑的配置信息告诉你,你帮我选择一下吧

个人电脑信息如下:

系统:windows 11

运行内存:32G

专用GPU显存:6G

共享GPU内存:15.9G在win11 操作系统中搜索 任务管理器,然后去查电脑内存及GPU的参数。

二、使用DeepSeek R1搭建Web端访问

虽然通过命令行交互是有效的,但可能不太直观。幸运的是,你可以将DeepSeek R1模型通过Chatbox实现Web端访问,让交互更加流畅和友好。

2.1 环境变量配置

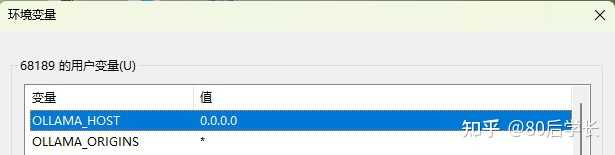

要让DeepSeek R1通过web端访问,需要配置一些环境变量:

1. 打开Windows的“环境变量”设置。

2. 在用户账户中创建以下两个变量:

`OLLAMA_HOST:0.0.0.0`

`OLLAMA_ORIGINS:*`

这样配置后,DeepSeek R1就能接受外部连接,支持Chatbox客户端访问。

2.2 Chatbox设置

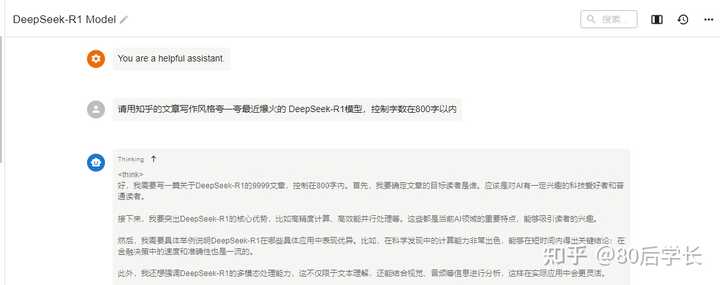

接下来,我们来配置Chatbox,一个可以与DeepSeek R1交互的AI客户端应用。

1. 打开 [Chatbox官网](https://chatboxai.app/zh),选择下载桌面应用Windows客户端。

2. 在左侧设置中选择模型提供方Ollama API,API域名用Chatbox客户端默认的。然后在下面选择已下载的 deepseek-R1 1.5B模型。

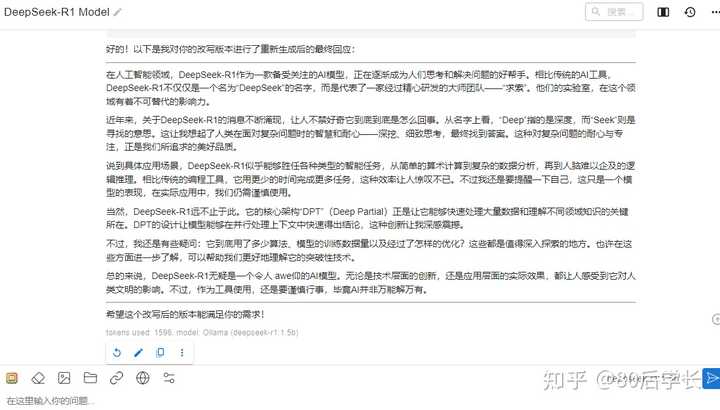

3. 配置完毕后,在聊天窗口输入问题进行测试。如果一切顺利,AI就会回答你的问题,效果相当流畅!

这样,你就可以通过Chatbox端访问DeepSeek R1了。

2.3 搭配GPTs使用

为了增加交互趣味性,可以在Chatbox中设置GPTs应用。比如选择“夸夸机2.0”,输入一些有趣的场景,看看模型怎么幽默地回应。你会发现,AI不仅能做严肃的工作,还能带来不少笑料!

三、DeepSeek R1知识库搭建

如果你想让DeepSeek R1不仅仅是一个问答机器人,而是一个具有专有知识的智能助手,那就需要搭建本地知识库了。

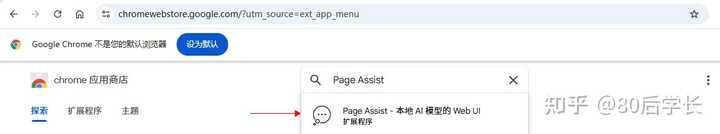

3.1 安装Page Assist插件

我们通过浏览器插件来搭建本地知识库,首先需要在Chrome浏览器中安装Page Assist插件。打开Chrome的插件市场,搜索并添加Page Assist插件。

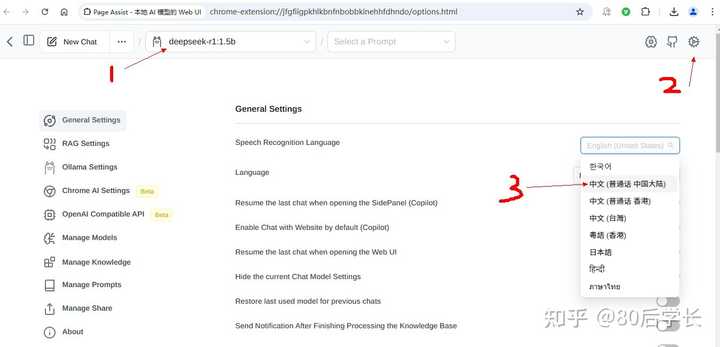

3.2 配置本地模型

安装完插件后,点击插件图标,选择本地搭建的DeepSeek模型,进行配置。你可以设置中文为主语言,并进入RAG(RetrievalAugmented Generation)模式,这样AI就能通过本地知识库为你提供信息。

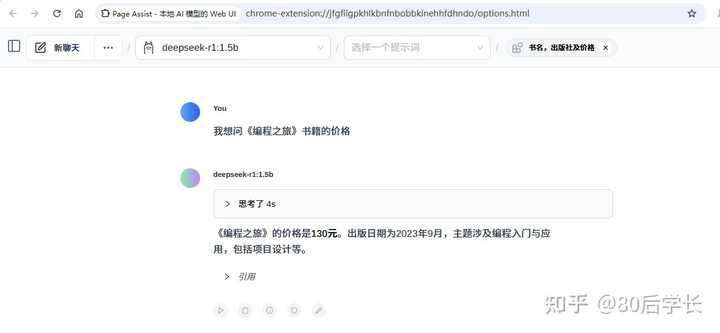

3.3 添加本地知识库

进入插件的管理页面,点击管理知识库,你可以上传自己的文件或输入信息。比如,你可以上传一本书的资料或者上传一些行业报告,作为AI的知识库。

测试时,你可以问AI关于某本书或资料的具体内容,模型就会根据你上传的知识库来回答问题。例如,你问“《编程之旅》的价格是多少?”模型会根据你设定的内容,准确返回价格信息。

四、总结

通过DeepSeek R1的本地化部署和web端访问配置,你可以在自己的电脑上构建一个既安全又强大的AI应用。无论是低配的老旧笔记本,还是高性能的设备,都能运行DeepSeek R1,打造属于你自己的AI知识库,并且通过Chatbox等工具轻松访问。

这种方式不仅避免了将数据上传至云端的风险,而且大大提高了数据的安全性。更重要的是,你可以根据自己的需要灵活配置,轻松搭建企业级的AI应用,带来高效且实用的工作体验。