我在B站看到一篇很好的内容,想给大家分享下

分享两个可接入DeepSeek的AI知识库,分别适用于个人及企业团队。

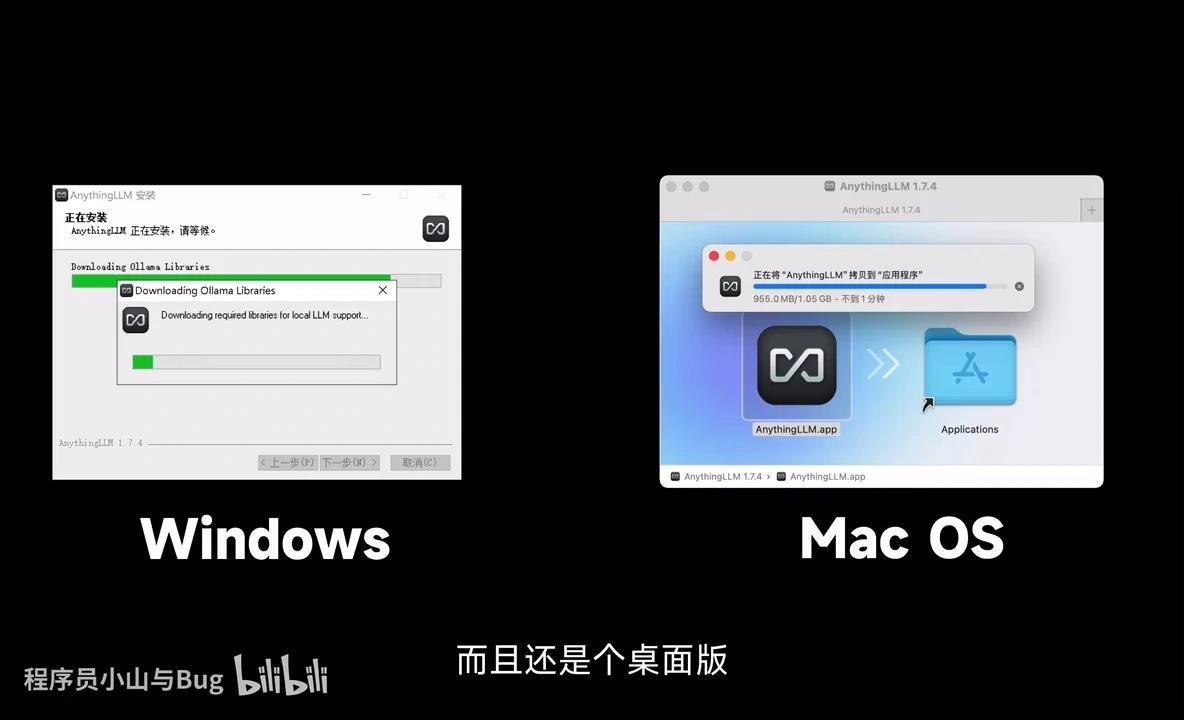

首先介绍个人版的AnythingLLM,其优势不仅在于率先接入了DeepSeek模型,更因其安装简便、操作友好,且提供桌面版应用。

首先展示一下支持的模型列表,包括 OpenAI、Ollama 以及 DeepSeek。其中比较特殊的是第一个 AnythingLLM,它支持在本地直接离线安装大模型,包括 DeepSeek 的各个版本。此外,它还支持从 Hugging Face 拉取大模型。

与 MaxKB 相似的是,它可以管理本地知识库,例如将文档导入后学习,并基于这些内容进行提问。

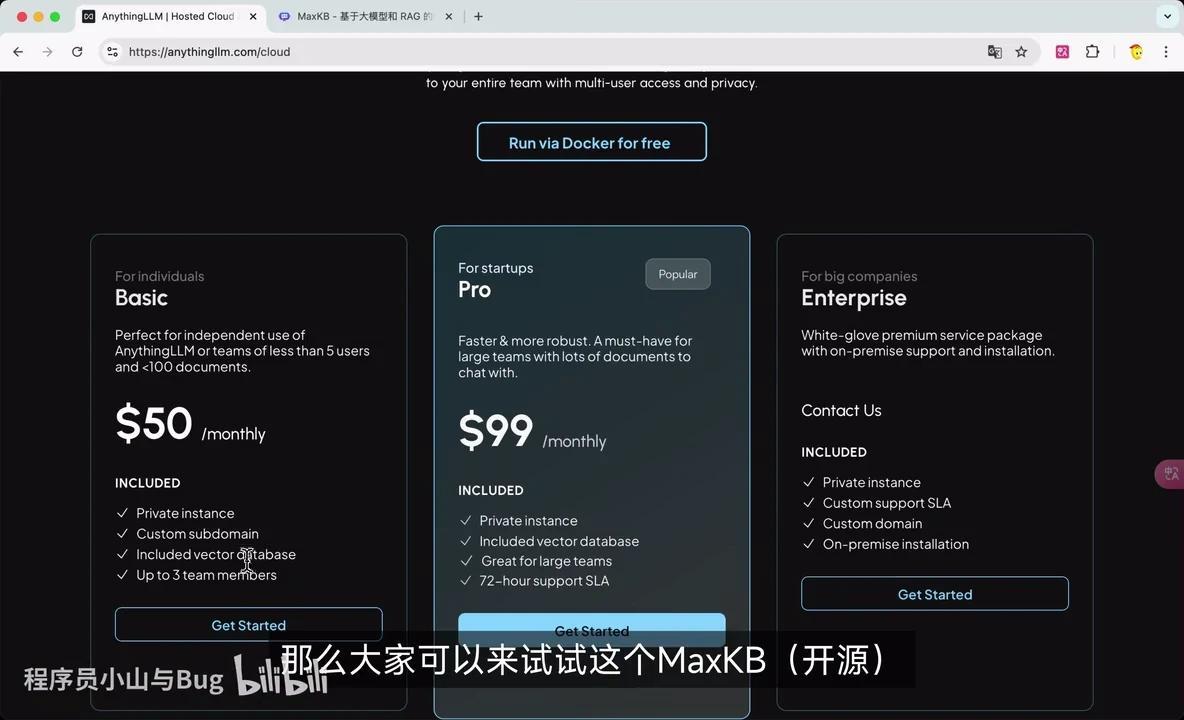

由此可见,AnythingLLM仅适用于个人场景,因其为单机版本,无法支持多用户共享,甚至无法开放给客户使用。然而,其官网提供的云服务版本中,最基础的个人版定价为每月50美元,但其功能与开放性仍无法满足我们的需求。

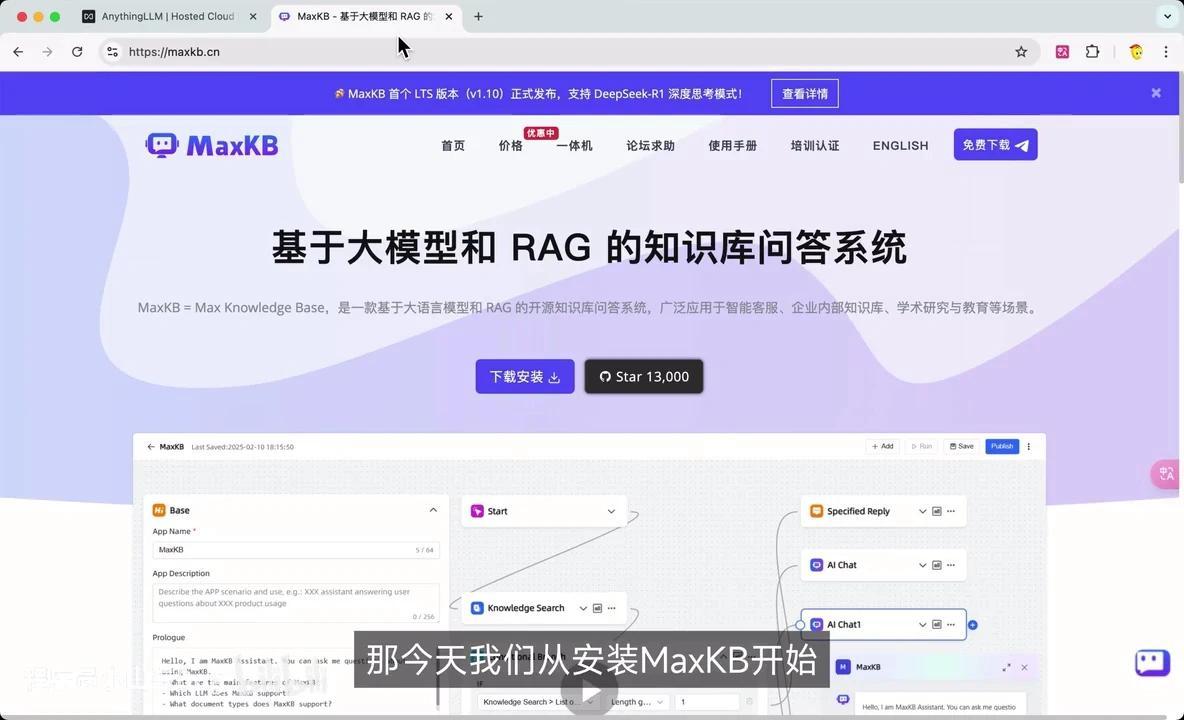

如果团队需要构建AI知识库或对外提供AI客服服务,可以尝试使用MaxKB。

本次演示将从安装MaxKB开始,展示三种接入DeepSeek模型的方式,并呈现其知识库的实际效果。

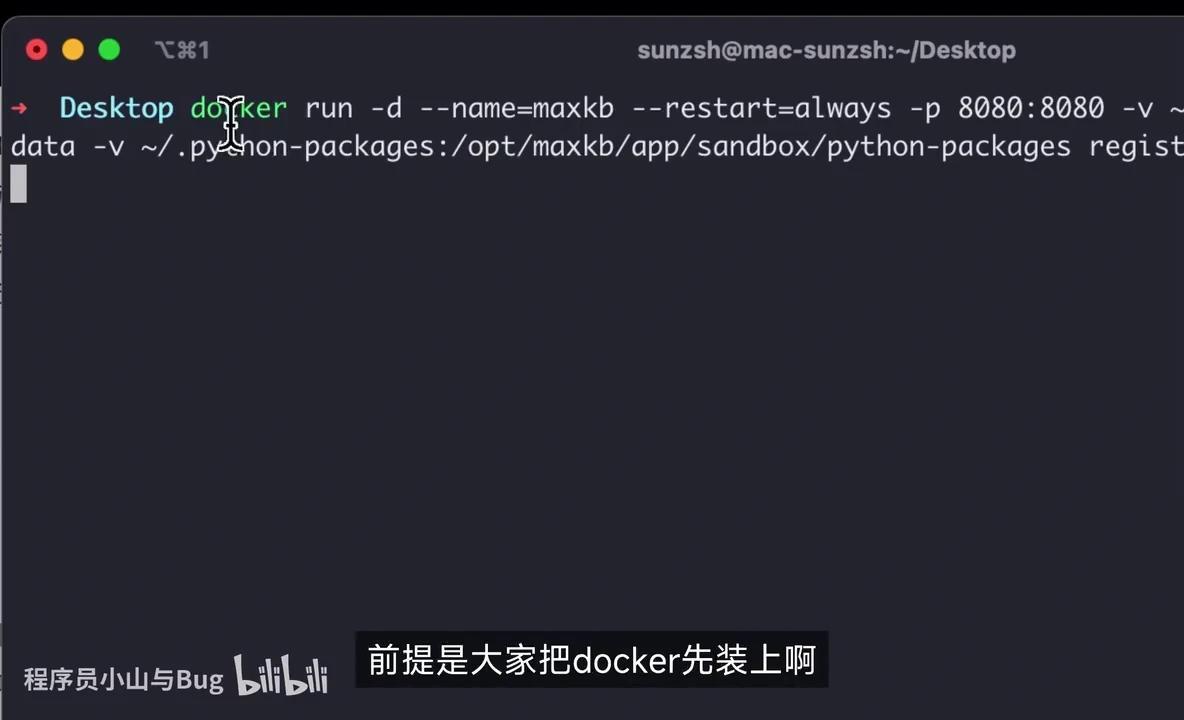

为了演示,我将在自己的电脑上重新安装。操作非常简单,只需执行以下命令。由于我使用的是Mac系统,因此适用Linux命令。

复制该命令后,通过Docker方式运行即可,前提是已安装Docker。执行命令后等待完成。

我已预先拉取过镜像,首次执行可能需要一些时间拉取镜像,这属于正常现象。

可以访问了。默认的登录账户密码显示在这里。

为了演示离线 DeepSeek模型,我准备了一台已安装 MaxKB 的服务器。安装完成后,首先需要配置模型。考虑到不同用户的需求,我将演示三种接入 DeepSeek 的方式。

首先介绍 离线部署方案:

1. 先在本地安装 Ollama;

2. 然后在 Ollama 中拉取 DeepSeek模型;

3. 最后在 MaxKB 中进行配置。

我们来看一下 Ollama 的安装过程,其实非常简单。

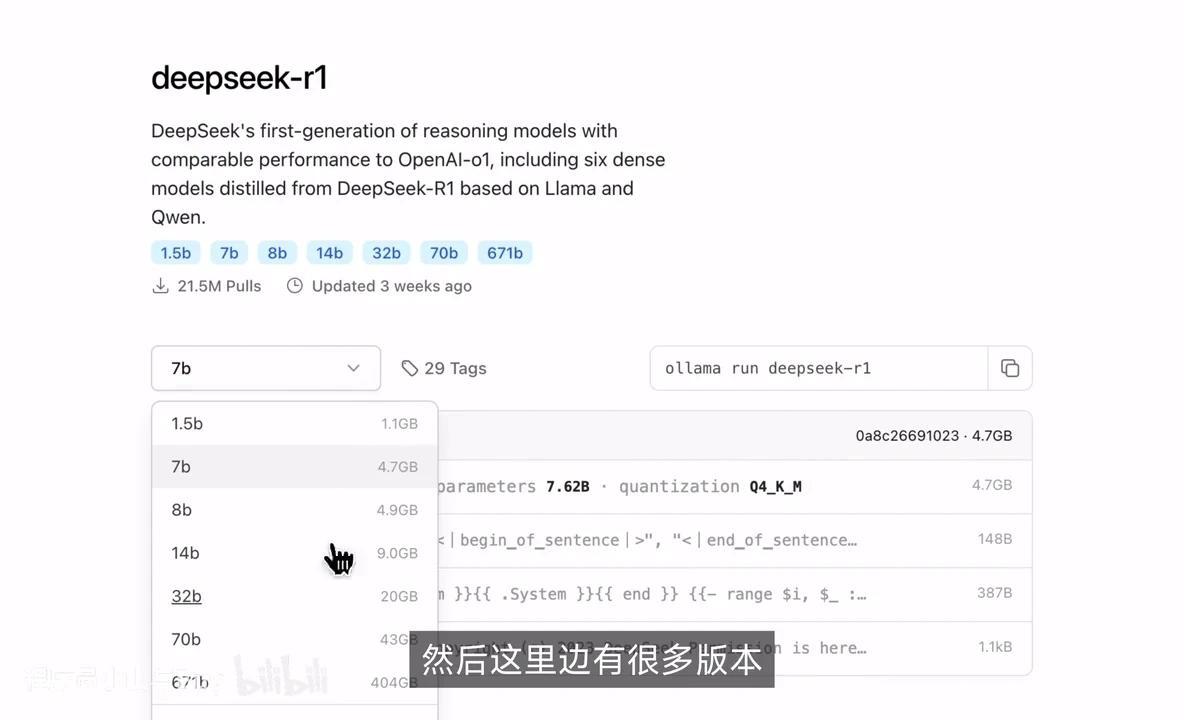

首先选择 Linux 系统,执行相应的命令即可完成安装。安装完成后,进入模型选择界面,点击 “Models” 选项,即可搜索 DeepSeek 模型。

R1版本包含多个子版本,其中671B为学术版。若用于客服场景,7B或8B版本已足够。

选定版本后,复制右侧命令并在服务器上执行即可。执行完成后,可在MaxKB中查看结果。

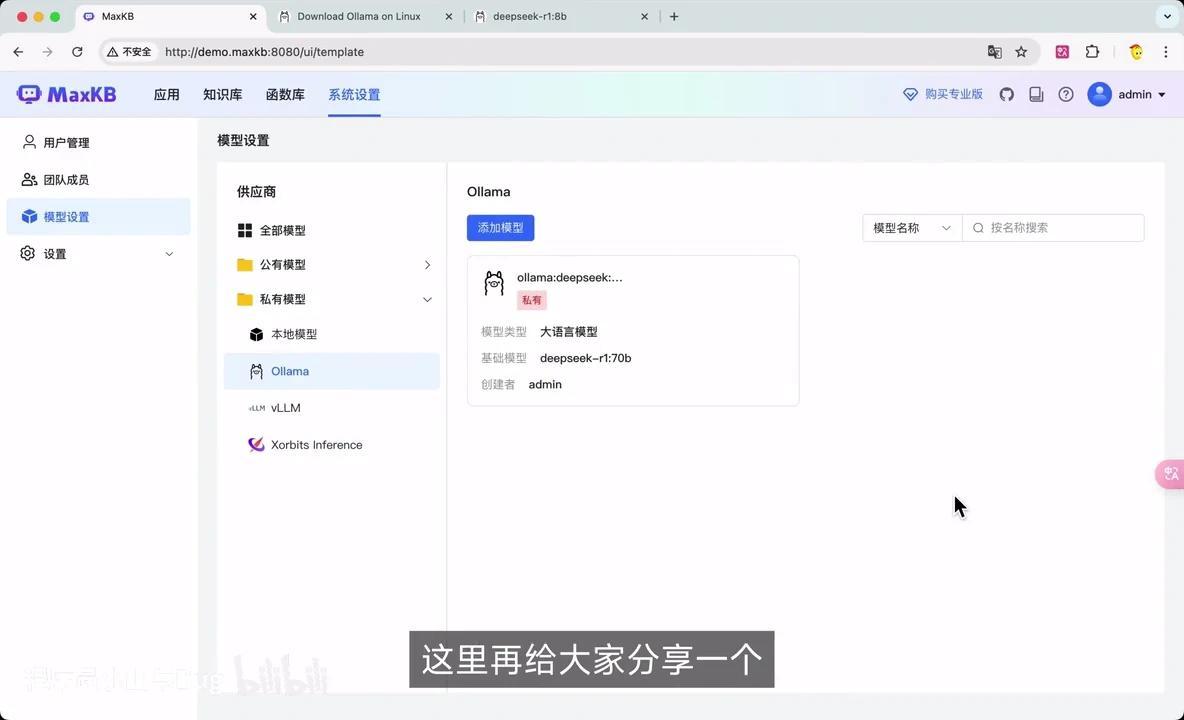

在界面中找到 Ollama,点击“添加模型”。由于我已添加过该模型,此处选择修改操作。

- 模型名称可自定义填写。

- 基础模型需填写拉取时的名称。若下拉列表中未显示相应选项,可直接手动输入。

- URL需填写服务器IP地址及Ollama默认端口11434。

- API Key可随意填写,因Ollama无需此验证。

最后点击提交即可完成模型添加。

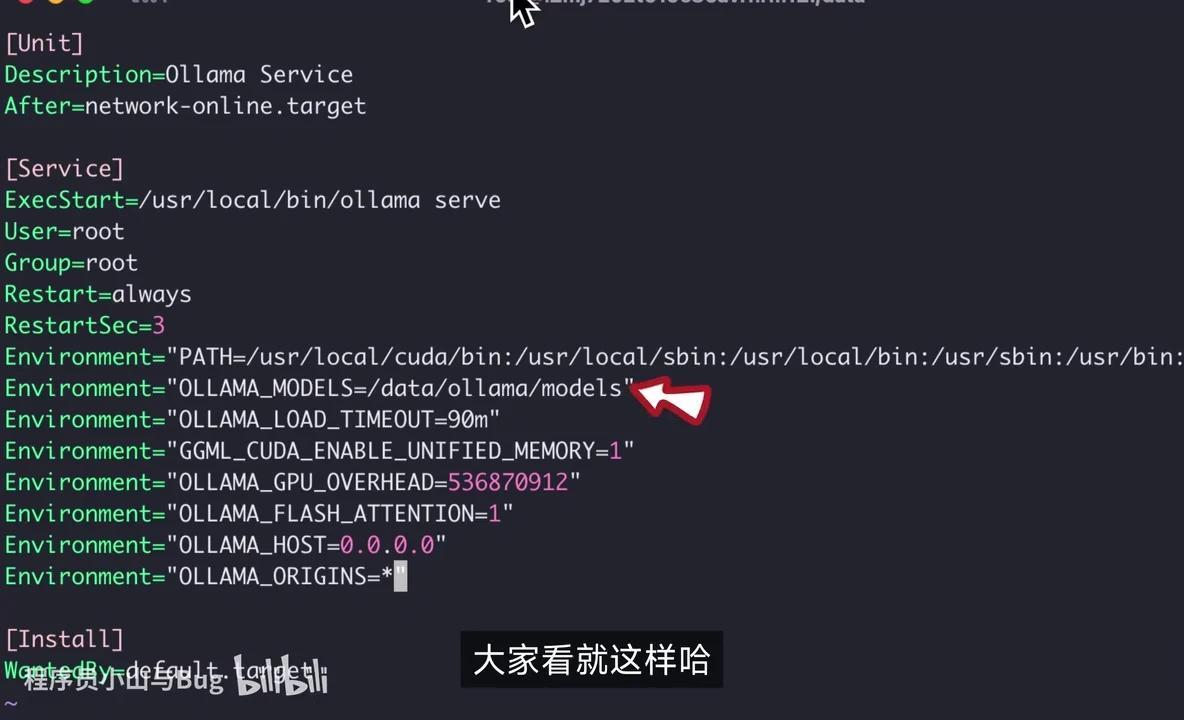

在此分享一个曾遇到的问题:若磁盘空间有限,安装 Ollama 后需配置模型存储路径至其他磁盘,因为模型文件通常较大。

以 CentOS 8 为例,修改路径位于系统服务配置文件中,具体操作为调整 Ollama Service 的 EnvironmentOLLAMA_MODELS 参数值。

我们已在本地离线部署了 DeepSeek 模型,同时也可以使用官网提供的 API。

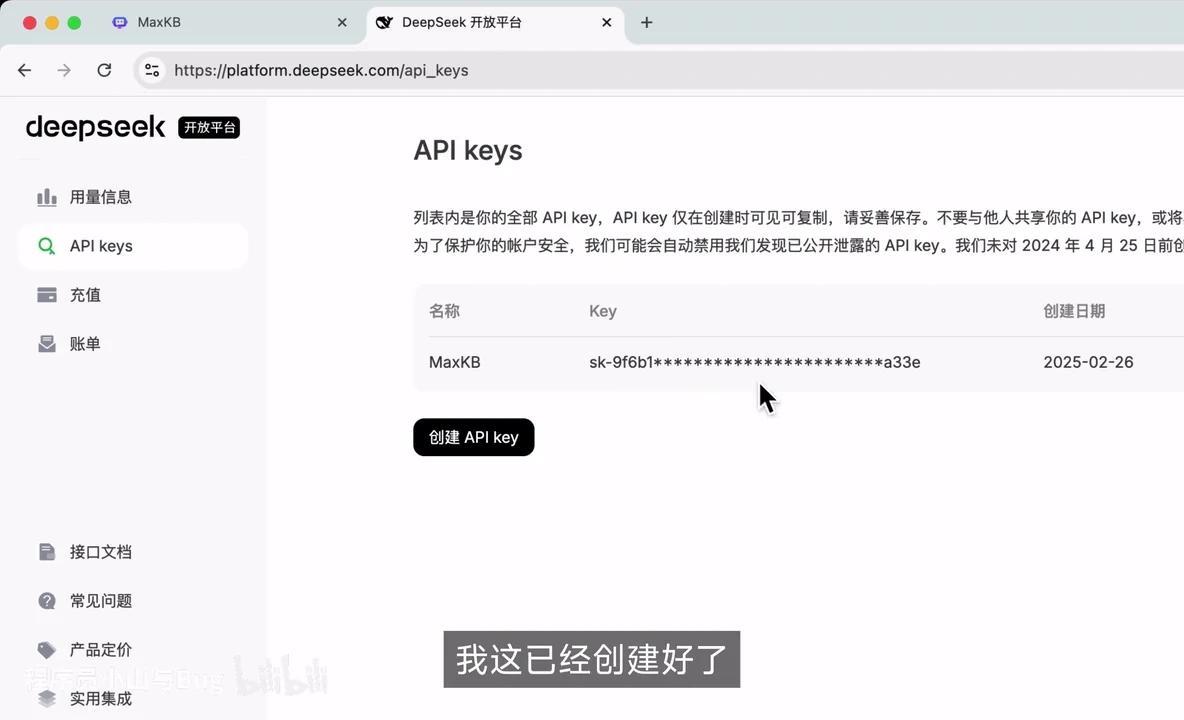

在公共模型中选择 DeepSeek 并添加,随后前往 DeepSeek 开放平台。目前充值功能已重新开放,建议尽快尝试以免再次关闭。

创建 API 后,将生成的 API key 复制使用。

首先,我们暂时命名为DeepSeek。接下来,在大语言模型选项中,我们选择第一个RE模型,并获取其API Key。

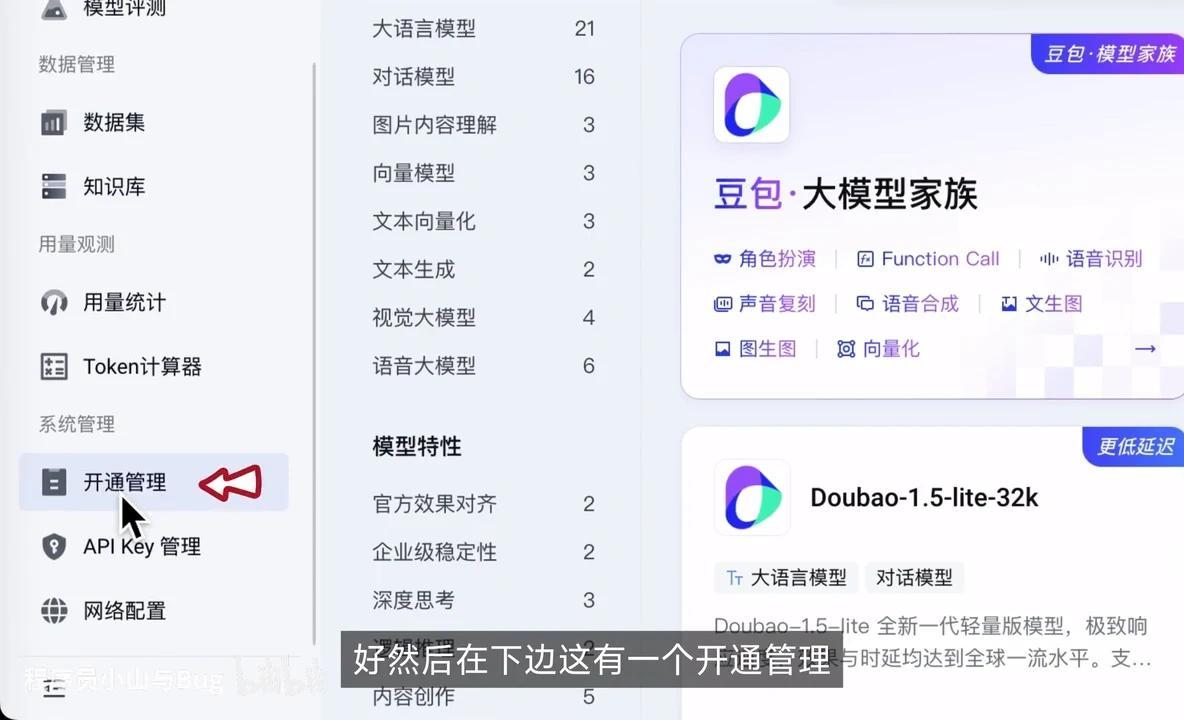

如果DeepSeek官方API尚不稳定,可以选择阿里云百链或火山引擎作为替代方案。以下以火山引擎为例进行演示:

- 注册登录后,进入控制台。

- 选择火山方舟服务。

- 在开通管理页面进行操作。

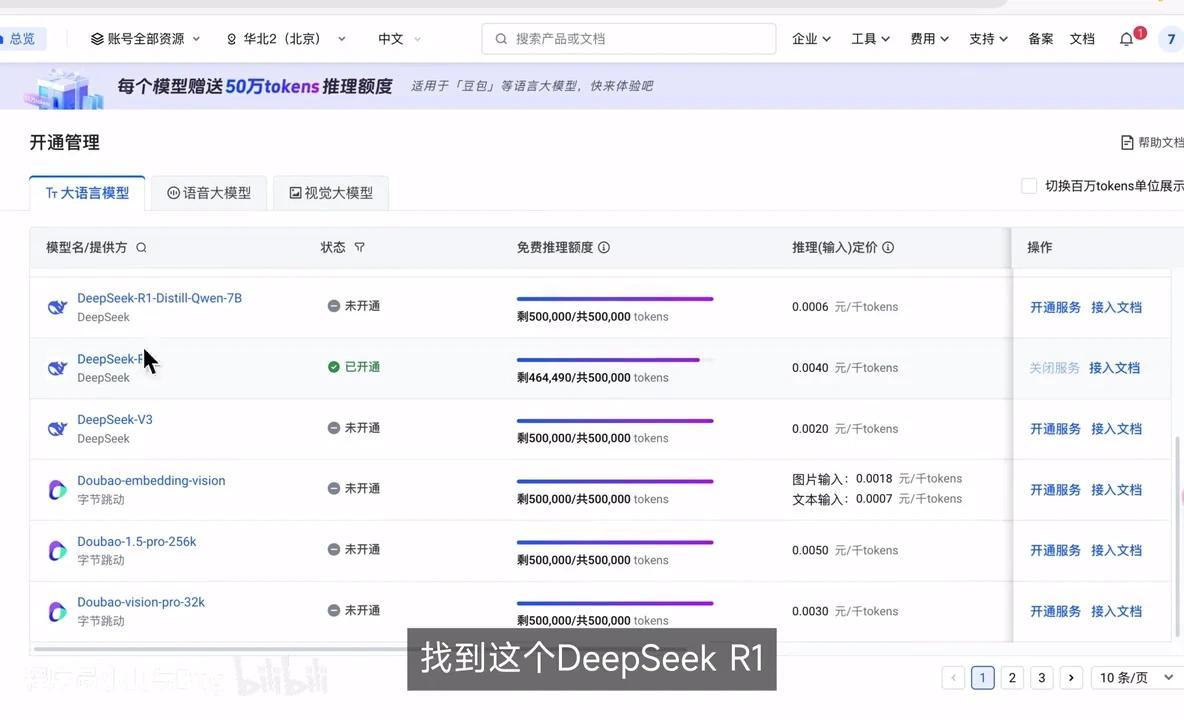

在这里,他开通了 DeepSeek模型 后,我们创建了一个 API Key。接着,我们回到 MaxKB火山引擎 添加模型DeepSeek火山,并选择基础模型。基础模型可在原位置找到。

找到这个DeepSeek-R1-Distill-Qwen-7B,后面有相应的接入文档。

注意,我们将此处的Key复制过来,之前已进行过复制操作。

我们首先将Key放置到URL中。URL可以在下方找到,这里有一个demo示例,具体地址为http://demomaxkb:8080/uil/application。我们只需截取到V3部分即可,保存好后进行下一步操作。

接下来是MaxKB的第二步:构建知识库。我准备了几个模拟文档,包括系统流程说明、会议记录、接口文档和数据库设计文档等。现在,我们创建一个名为“仓储项目”的知识库,用于存储与仓储项目相关的资料。

相关文档。

然后选择此项,知识库类型保持不变,创建完成后上传文件并拖入相应内容。

下一步。

智能分段功能通常不会出现问题。等待索引完成后即可使用。

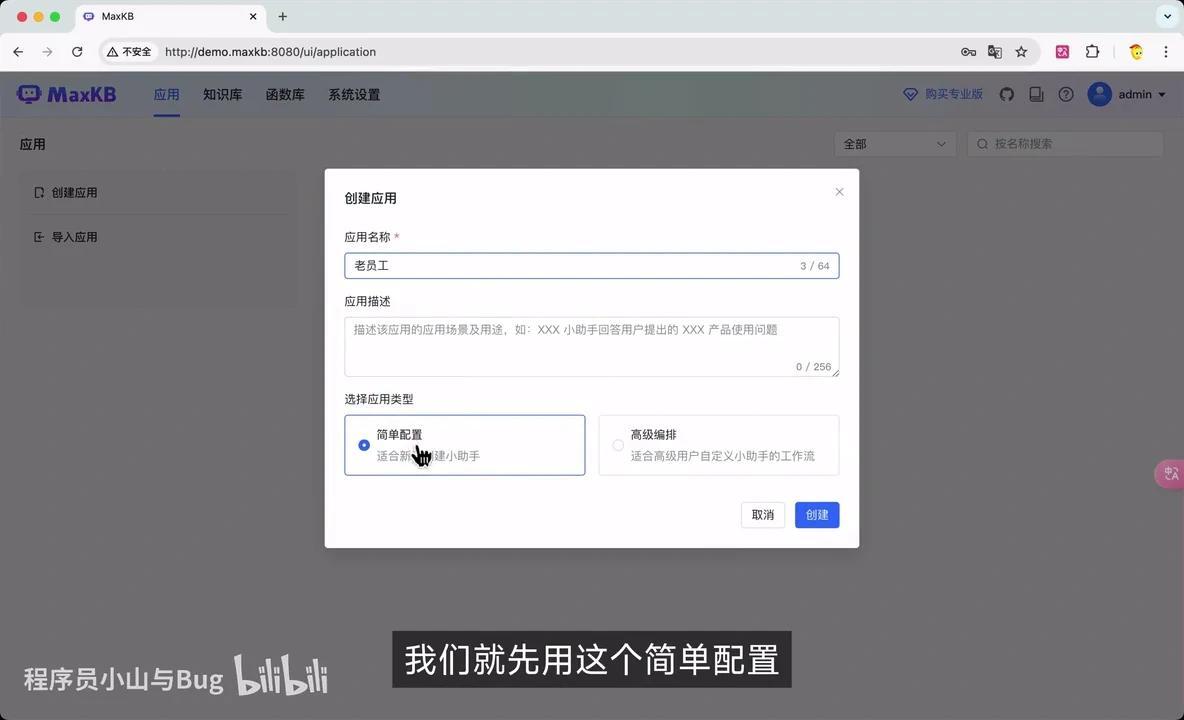

现在可以创建应用,该应用可视为一个机器人。例如,创建”导演工”应用时,我们选择简单配置模式。目前主要关注模型设置,其他描述信息暂时保持不变。

例如,我们使用火扇工具时,下方关联知识库中需要勾选仓储项目。

请注意,DeepSeek模型具有思考过程,若不展示这一过程,响应会显得较慢。保存并发布后,我们进行测试。

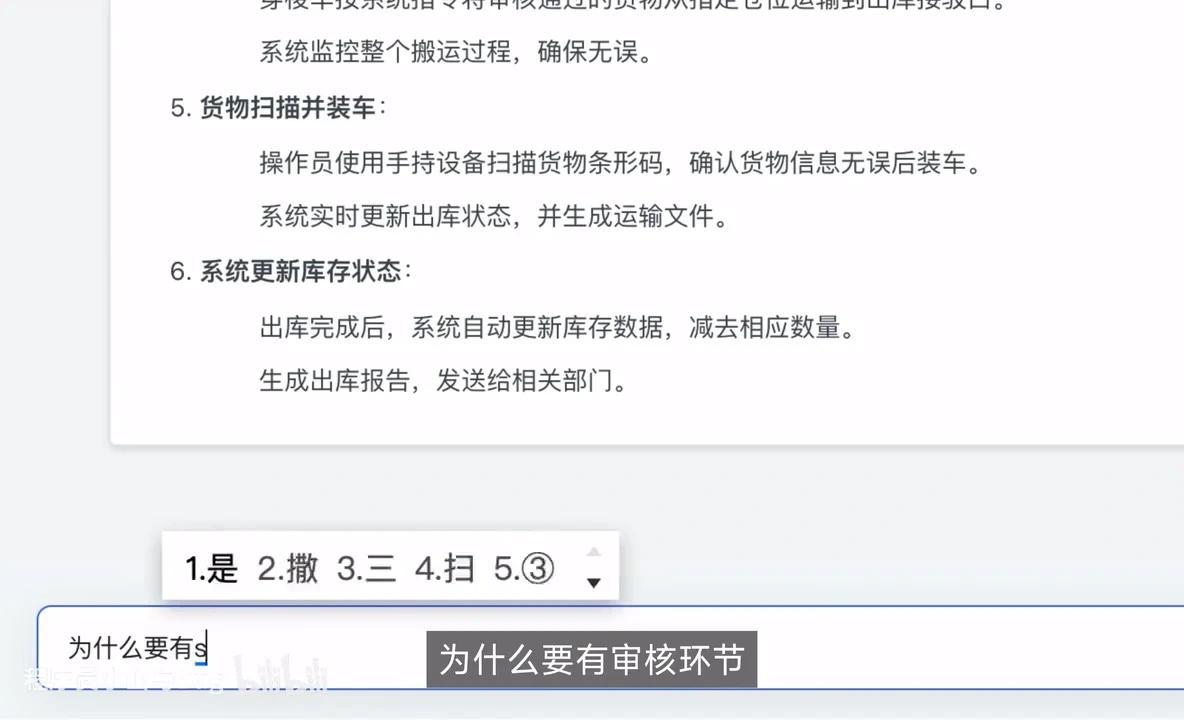

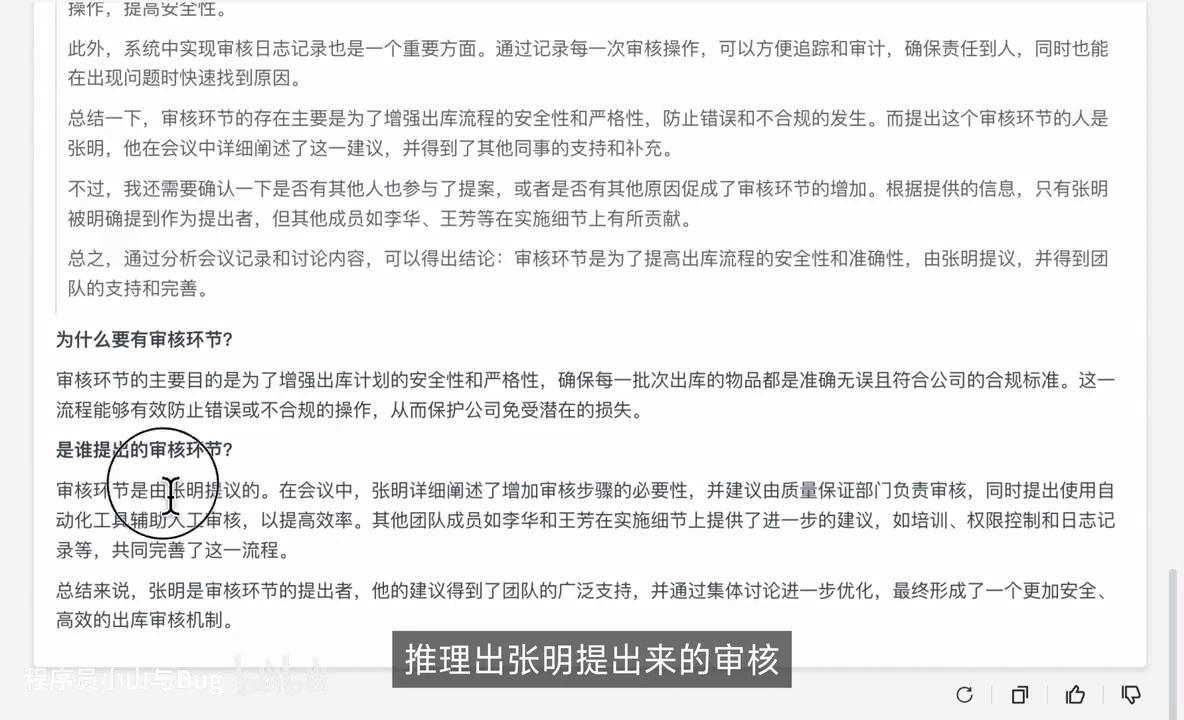

首先使用本地DeepSeek模型演示出库流程。结果显示完整思考过程。若对出库审核环节存在疑问,可进一步询问审核环节的设置原因及提出者。

审核的必要性在于确保流程的规范性。根据会议记录,系统可自动识别张明提出的审核需求。此外,该功能还具备一项重要特性,我们将在后续详细说明。

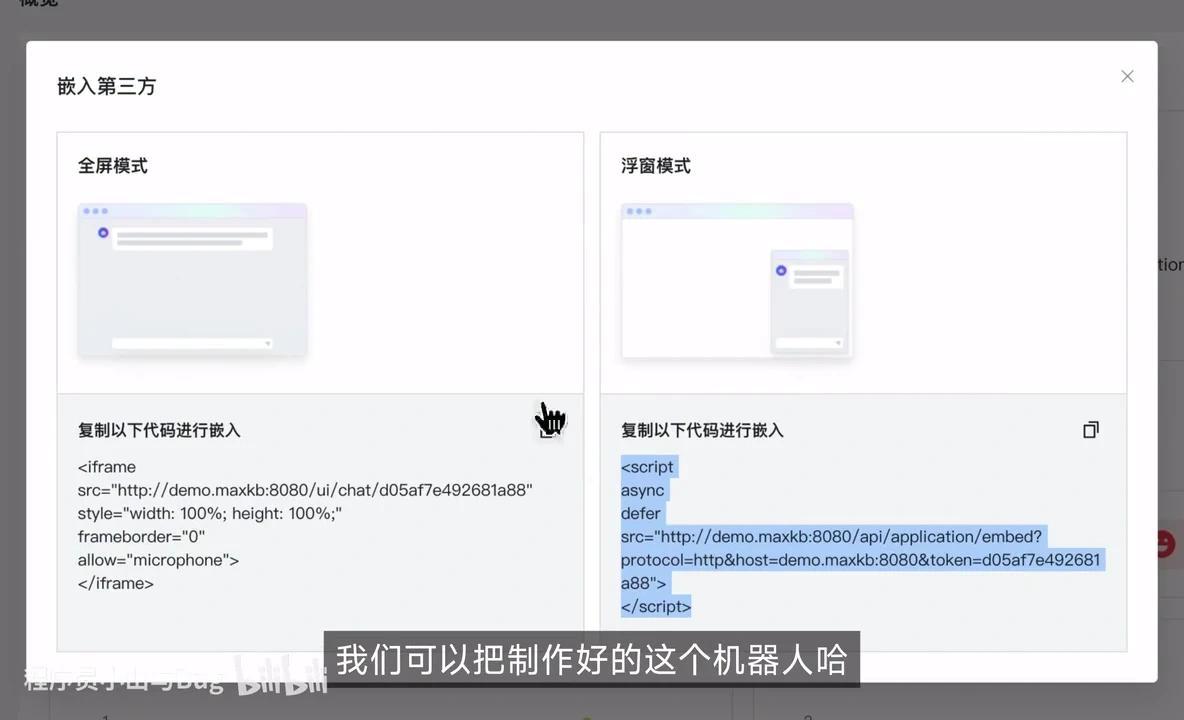

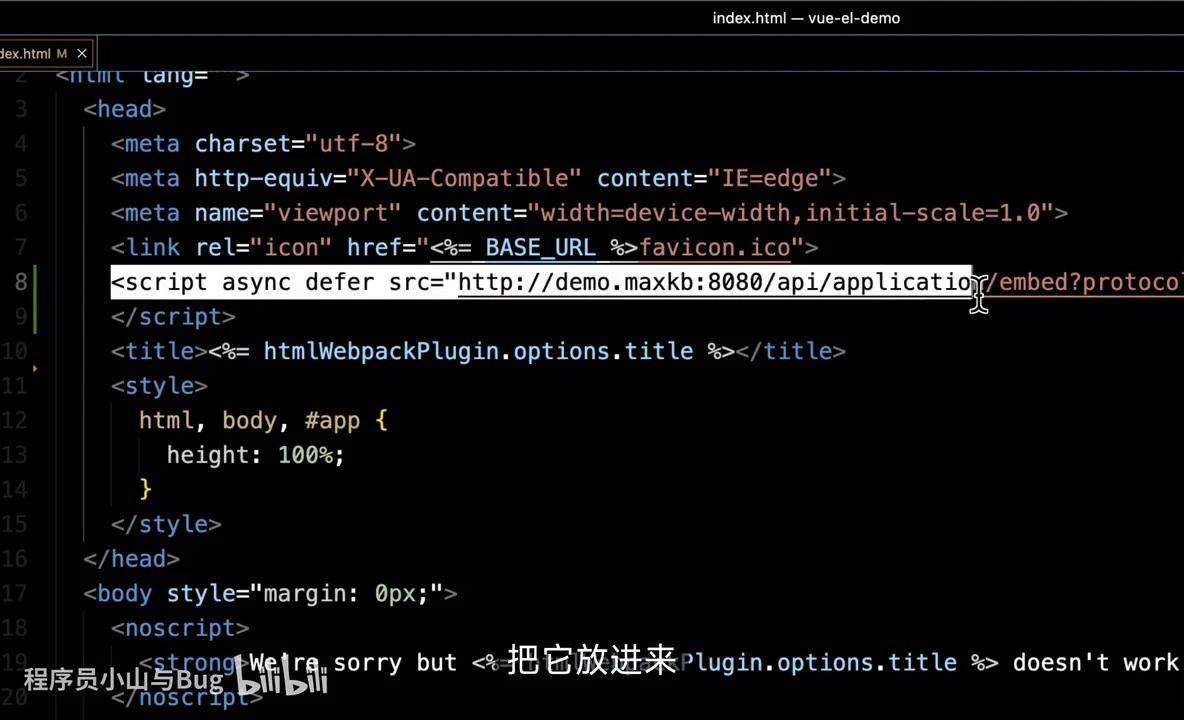

该链接可直接访问,主要用于嵌入第三方功能。我们可以将已创建的AI问答机器人嵌入到其他项目中。例如,以下是一个随机选取的示例。

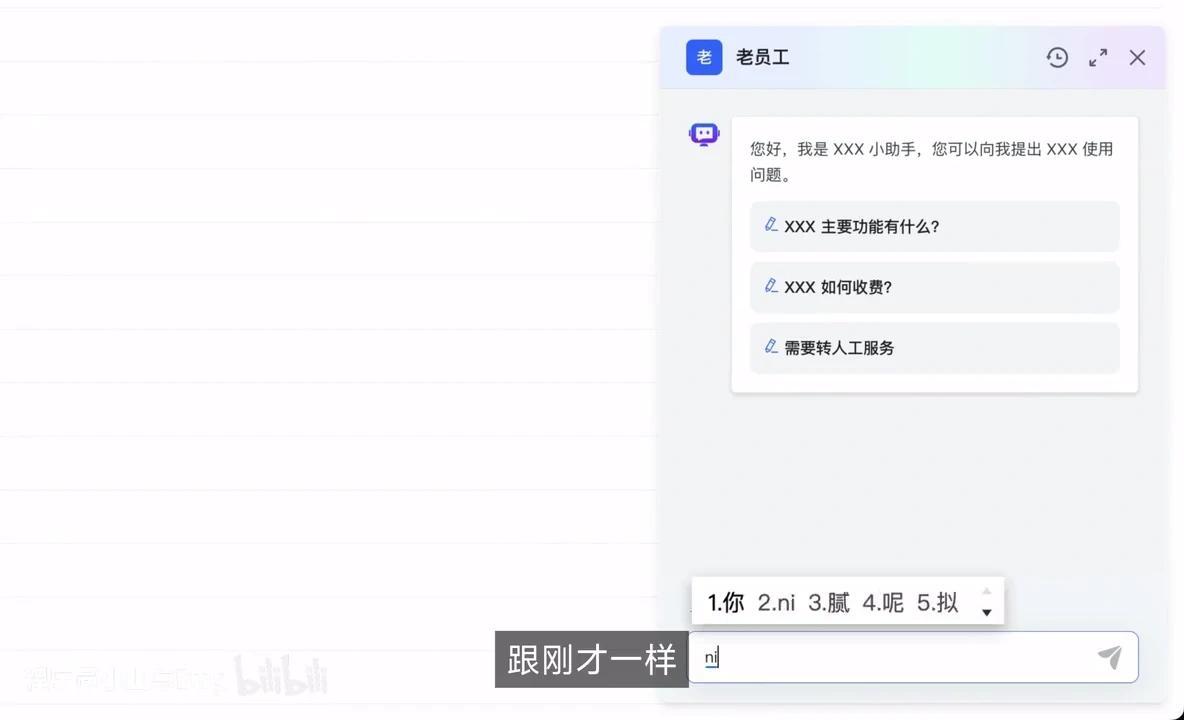

我之前演示的Demo项目已整合在此处。

右下角有一个浮动机器人图标,点击即可开始聊天,操作方式与之前相同。

你好。

操作完成后,点击此处可进一步放大。最后进行总结。

如果是个人使用,AnythingLLM就足够了。但如果是团队需求或需要开放给客户使用,那么选择MaxKB更为合适。

这是它的官网地址。

建议大家收藏备用。