前言:你是否在跟ai对话时有过以下场景:使用deepseek的时候遭遇网络繁忙的情况?上传文件担心泄露隐私?对话时换个ai就不懂你?

那别错过本地搭建知识库,本文以一种幽默易懂的方式为你讲解windows系统进行配置教程,采用ollama+anythingLLM(现在看不懂?没关系,你就把它当做本地运行的两个软件)

跳过废话不看版:直接点击跳转 三、开始搭建你的“私人智慧厨房” (配置步骤)

本人亲手搭建,不定期更新。有遗漏的步骤欢迎在评论区留言。

一、为什么要搭建本地知识库?—— 拥有自己的“永不打烊智能厨房”

想象一下:

- 场景1: 你想做一道复杂的“红酒炖牛肉”,但每次都要跑到不同的“公共菜谱图书馆”(搜索引擎)翻找,还可能遇到“图书馆闭馆”(断网)、“菜谱被借走”(链接失效)或“菜谱版本不对”(信息过时)。

- 场景2: 你珍藏了许多独家秘方、家族食谱、美食笔记(你的文档、笔记、PDF、网页收藏),但它们散落在抽屉、笔记本、手机里(不同设备、不同格式),想用的时候找得焦头烂额。

- 场景3: 你对某些“食材”(特定领域知识,如法律、医学、内部流程)有疑问,问“公共美食顾问”(通用AI)时,它可能给你一个大众化的、不够精准甚至错误的建议。

本地知识库,就是你解决以上所有痛点的终极方案!它就像在你的家里(本地电脑)搭建了一个:

- 24小时营业的私人厨房: 永不闭馆,随时可用,不受网络限制。

- 专属的智能中央料理台: 把你所有珍贵的“独家食谱”(个人/工作文档)集中收纳。

- 配备米其林AI主厨的智囊团: 这位主厨不仅精通世界美食(通用知识),更对你厨房里每一份独家食谱、每一种特殊香料(你的专有知识)了如指掌。你可以随时用自然语言(对话)向它提问,它能基于你私人珍藏的知识,给出最贴合你需求、最精准、最私密的答案!

核心价值总结:

- 隐私安全: 你的“独家食谱”不出家门,不经过他人服务器。

- 高效利用: 瞬间找到并理解你海量的私人知识。

- 精准智能: 获得基于你专属知识库的定制化AI回答。

- 离线可用: 没有网络?照样开火做饭!

- 专属定制: 打造完全属于你个人或团队的智慧大脑。

二、认识你的“厨房核心设备”:Ollama 与 AnythingLLM

要打造这个梦幻厨房,你需要两件核心“智能厨电”:

- Ollama:你的“万能食材处理中心” (大模型引擎)

- 比喻: 想象 Ollama 是一个功能强大的中央料理机。它的核心能力是“理解”和“生成”语言。你可以把它看作一位基本功极其扎实的“基础主厨”。但它本身不擅长管理你的私人食谱库。

- 作用: Ollama 负责在本地运行各种强大的“语言模型”(LLM, 可以理解为不同风格、不同专长的主厨大脑),比如

llama3,mistral,qwen等。它把这些“主厨大脑”下载到你的电脑里(就像为料理机安装不同的“料理程序包”),并提供标准化的接口让其他工具(比如 AnythingLLM)能轻松调用这些“主厨”的能力。 - 关键点: Ollama 不管理你的知识文档,它只提供强大的“语言处理”引擎(主厨的烹饪基本功)。

- AnythingLLM:你的“智能厨房管家 + 食谱档案馆” (知识库管理 & 交互界面)

- 比喻: AnythingLLM 就是你的智能厨房总管 + 自动化档案馆。它做两件核心事情:

- 管理“私人食谱库”: 它会把你上传的各种格式的“食谱”(PDF, Word, TXT, 网页,甚至图片里的文字)自动切碎、理解、分类、归档,建立一个结构化的“数字食谱档案馆”(向量数据库)。想象它把一本厚厚的菜谱书,自动拆解成一道道菜、一个个步骤、一个个食材要点,并贴上智能标签,方便瞬间查找。

- 指挥“主厨”为你服务: 当你向 AnythingLLM 提问(“冰箱里还有牛肉吗?怎么做最快?”),这位管家会:

- 立刻在它的“数字食谱档案馆”里精准找出最相关的信息片段(比如你的库存清单、快速牛肉食谱)。

- 把找到的这些“信息食材”和你的问题一起,交给 Ollama 驱动的“基础主厨”。

- “基础主厨”利用自己的语言能力,把这些“信息食材”加工融合,生成一个自然流畅、直接回答你问题的完整答案(“冰箱里还有300克牛腩。试试这个10分钟黑椒牛柳:1. 牛腩切条… 2. … ”)。

- 管家(AnythingLLM)把主厨做好的“答案菜肴”端给你。

- 关键点: AnythingLLM 负责知识管理和用户交互,是连接你的知识(食谱)、你的问题(点餐) 和 Ollama 的能力(主厨烹饪) 的智能中枢。

三、开始搭建你的“私人智慧厨房” (步骤概览)

准备工作概览

- 硬件: 一台性能尚可的电脑(建议16GB内存以上,最好有独立显卡/NVIDIA GPU,运行速度更快)。

- 软件下载地址:

- Ollama: 去 Ollama 官网下载安装包(Ollama)

- AnythingLLM :官网下载安装包(https://anythingllm.com/desktop)

以下分为ollama下载与配置、anything下载与配置(待更新)进行步骤详细介绍。

四、Ollama下载与配置

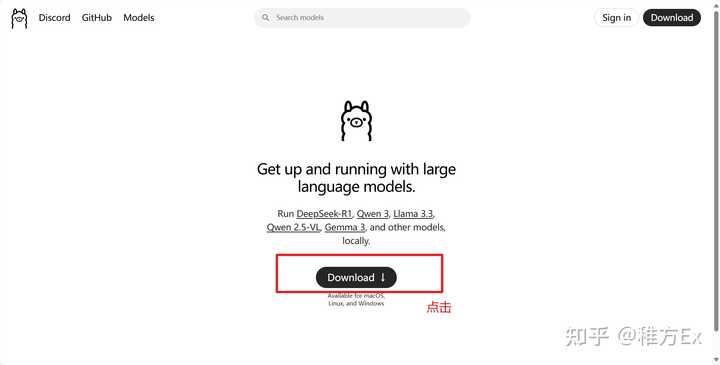

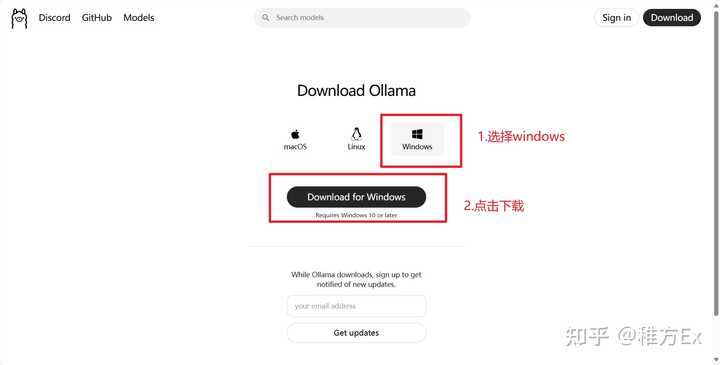

1. 软件下载,点击官网(Ollama)

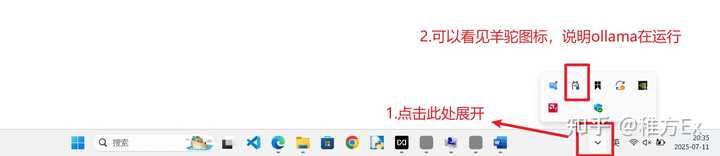

下载完成后,可以看到ollama运行

2. 修改环境变量

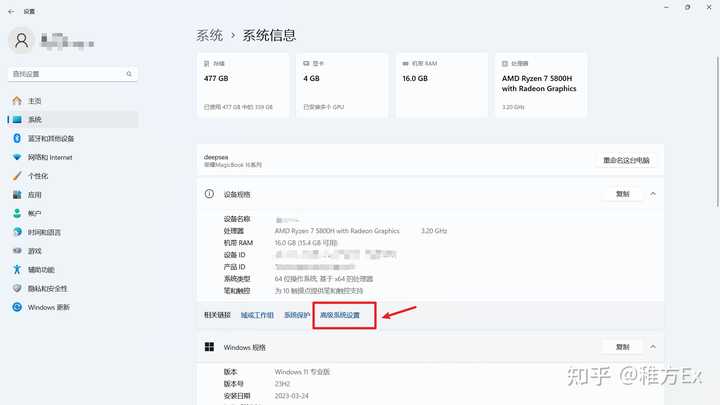

我是win11的电脑,修改环境变量的位置在:设置-》系统-》系统信息-》高级系统设置-》高级-》环境变量

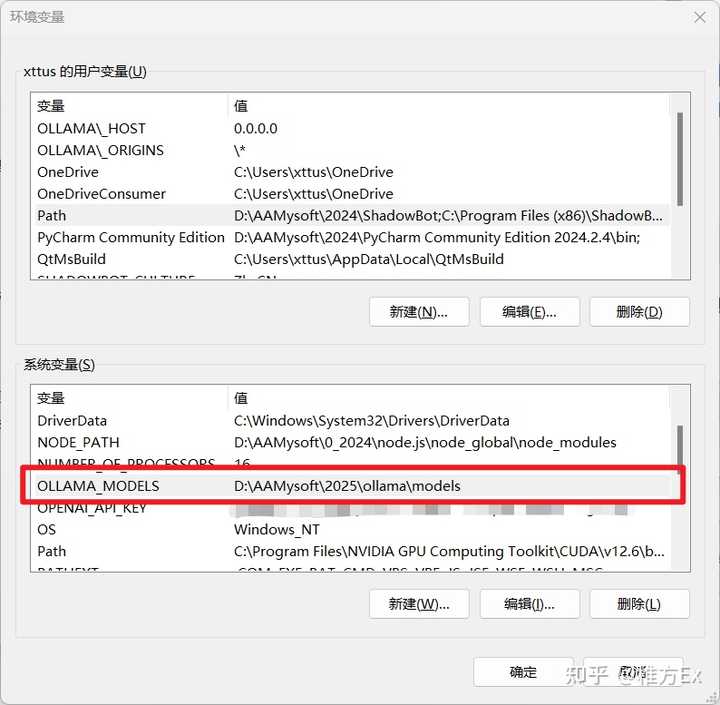

新建系统变量

| OLLAMA_MODELS | D:\AAMysoft\2025\ollama\models |

|---|

右边D:\AAMysoft\2025\ollama\models是后续你想存放模型的文件夹位置,不必和我一样。

完成后,可以看到系统变量被添加,然后再点一次确定

为保证系统变量成功添加并且生效,可以重启电脑。

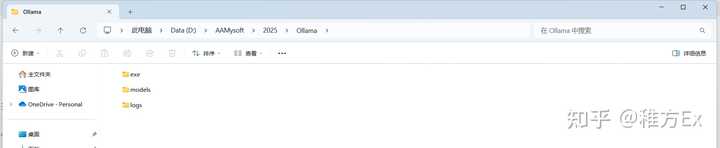

3.新建文件夹

why-》在想要ollama存放的地方新建文件夹,将默认安装的位置软链接到此处。防止c盘爆满

(1)ollama默认安装在C盘,我们可以在其它磁盘(例如D盘)新建文件夹“Ollama”,再建3个子文件夹“exe”、“models”、”logs”

- exe:存放可执行文件(即程序的运行文件)

- models:子文件夹通常用于存放模型文件

- logs:用于存放日志文件。

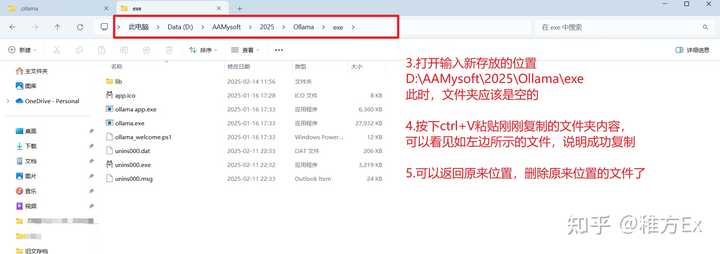

(2)将ollama默认安装文件夹里面的内容,复制到刚刚创建的文件夹里。复制完后记得《删除》默认安装文件夹的内容

| 默认安装文件位置示例 | (我的)默认安装文件位置 | (我的)新创建文件位置示例 | 功能 |

|---|---|---|---|

| C:\Users\用户名\AppData\Local\Programs\Ollama | C:\Users\xttus\AppData\Local\Programs\Ollama | D:\AAMysoft\2025\Ollama\exe | 存放程序运行文件 |

| C:\Users\用户名\.ollama | C:\Users\xttus\.ollama | D:\AAMysoft\2025\Ollama\models | 存放模型文件 |

| C:\Users\用户名\AppData\Local\Ollama | C:\Users\xttus\AppData\Local\Ollama | D:\AAMysoft\2025\Ollama\logs | 存放日志的文件夹 |

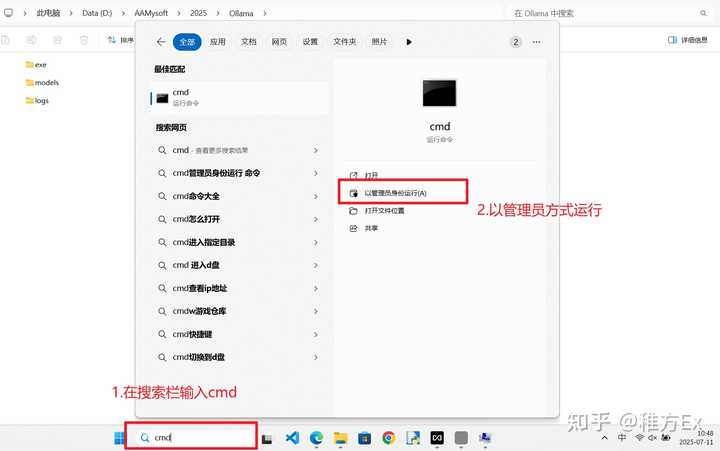

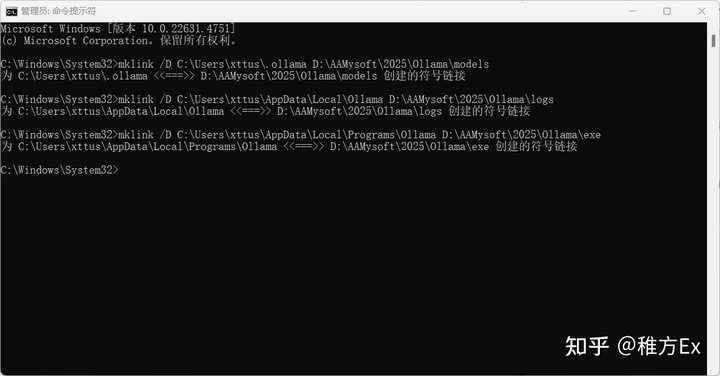

4.建立软链接,以管理员身份运行“windows命令处理程序”

建立软连接

mklink /所存储的磁盘 原路径 新路径这条命令的作用是:

把 Ollama 默认会写入的三个文件夹(模型、日志、程序)“改道”到你刚才自己建立的 D:\Ollama\… 目录里,但 Ollama 仍然以为自己在原来的默认路径下工作,这就是「软连接」(symbolic link)的效果。

软连接是什么?

- 相当于给 Windows 一个“假”的文件夹,任何程序访问原路径时,都会被自动重定向到你指定的新路径。

- 好处:

- 省 C 盘空间(模型通常几个 GB 甚至几十 GB)。

- 迁移方便,重装系统或换盘时只要把新目录拷走即可,重新建软连接即可恢复。

建议复制文件管理器的路径,避免手打错误,本人电脑示例:

mklink /D C:\Users\xttus\.ollama D:\AAMysoft\2025\Ollama\models

mklink /D C:\Users\xttus\AppData\Local\Ollama D:\AAMysoft\2025\Ollama\logs

mklink /D C:\Users\xttus\AppData\Local\Programs\Ollama D:\AAMysoft\2025\Ollama\exe

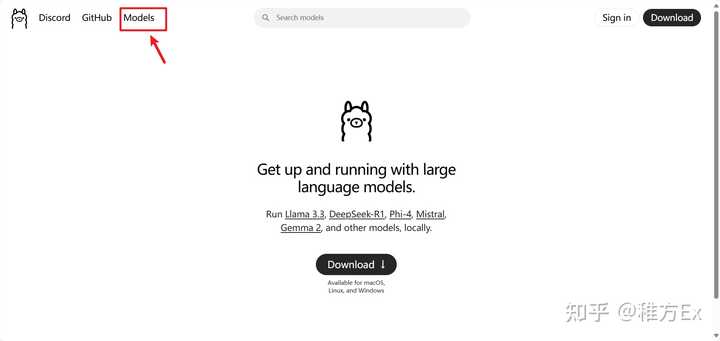

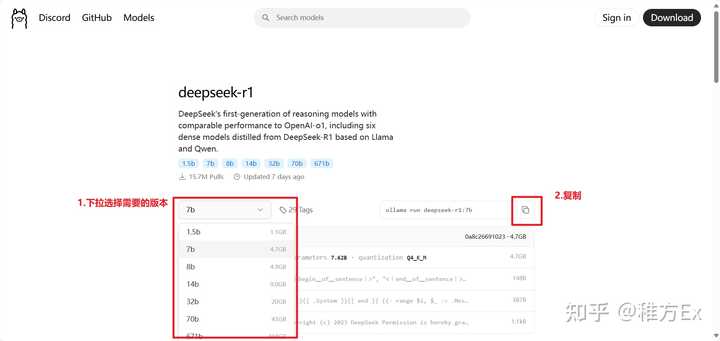

5.模型下载

选择deepseek_R1

在命令提示行粘贴

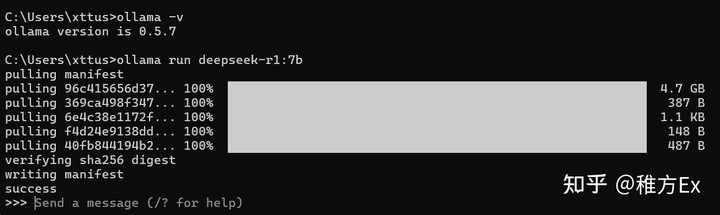

下载完成界面

本地使用,再输入该命令就可以了

ollama run deepseek-r1:7b也可以切换不同模型进行使用,等待模型打开结束后,即可对话

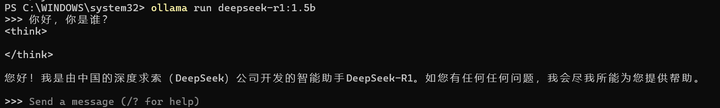

ollama run deepseek-r1:1.5b

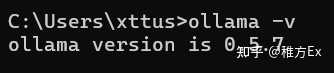

至此,ollama基本配置完成,恭喜你!!!

你可以在黑框框里与大模型对话,可是这样对话不方便,关闭窗口重新打开,不能查看历史对话记录,而且界面不美观,复制粘贴也不方便。这时候anythingLLM就派上用场了。等待第二篇文章anythingLLM配置更新。

五、Ollama使用指南

这部分是常用功能介绍,没有先后顺序,可参考。

启动服务

ollama serve查看模型

打开 命令提示符(CMD) 或 PowerShell,输入:

ollama list即可列出当前已下载的所有模型,例如:

NAME SIZE MODIFIED

llama3.1:8b 4.7 GB 2 hours ago

qwen2.5:7b 4.5 GB 1 day ago下载/使用模型

ollama run deepseek-r1:7b查看模型详细信息

如果你想查看某个模型的详细信息(如参数、标签、大小等),使用:

ollama show <模型名称>例如

ollama show qwen2.5:7b删除模型

ollama rm <模型名称>Q: 模型下载一半想删除咋办?

- 直接删除:

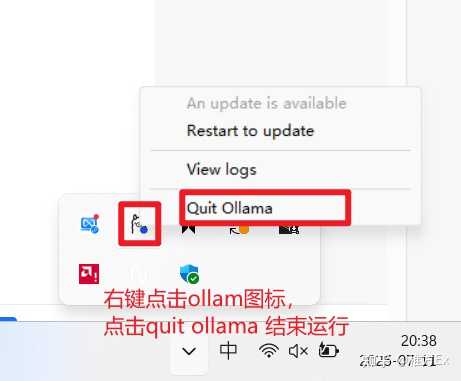

- 关闭所有正在运行的 Ollama 进程(任务栏图标右键 → Quit Ollama)

- 进入模型存放目录,在本例中是“D:\AAMysoft\2025\Ollama\models”,再进入子文件夹blobs