我看到一篇有趣的文章分享给大家

今天向大家介绍一个基于大语言模型构建本地知识库的开源项目——MaxKB。与其他知识库系统不同,它实现了真正的开箱即用,无需代码集成,支持GPT-4、百度千番、Llama 3、通译千问等多种大语言模型。

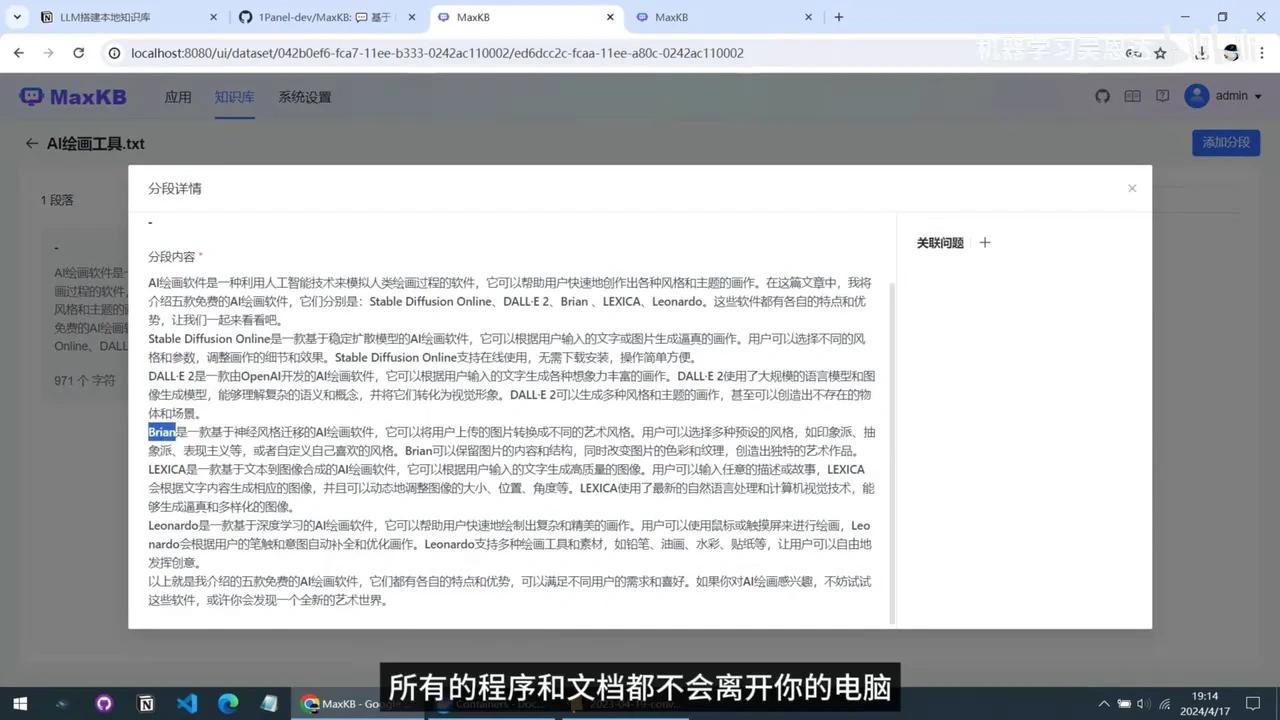

其操作界面简洁直观,仅需三步配置即可完成本地知识库的搭建。用户可将个人笔记、工作文档及在线网页内容添加到知识库中,通过建立索引并结合大语言模型对文档的理解能力,实现对文档内容的实时搜索与智能问答。

所有程序和文档均在本地运行,不会离开您的电脑。

下面将详细介绍如何在Windows系统上部署该人工智能模型。

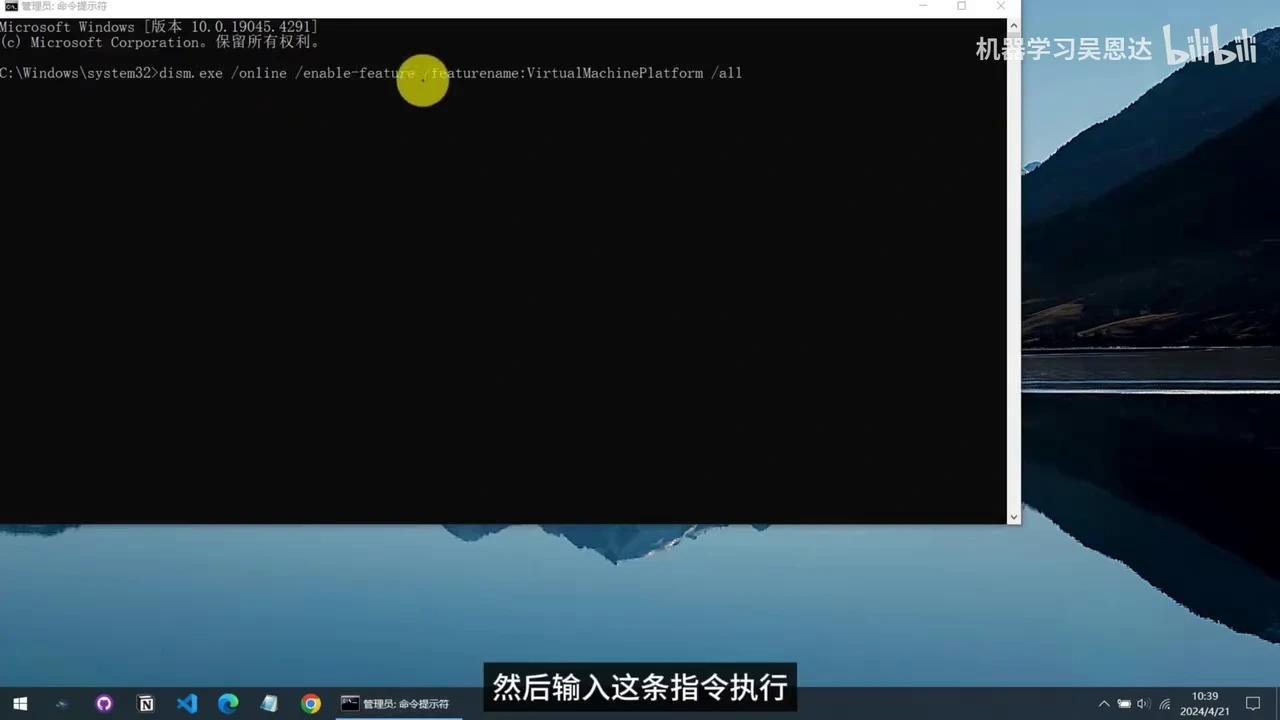

首先需确认系统是否已开启虚拟化功能。

按下Ctrl+Shift+ESC组合键打开任务管理器,切换到性能选项卡,点击CPU,查看虚拟化功能是否已启用。

若您的电脑尚未启用该功能,请以管理员身份打开命令提示符窗口,并输入相应指令执行。

执行完毕后需重新启动计算机。

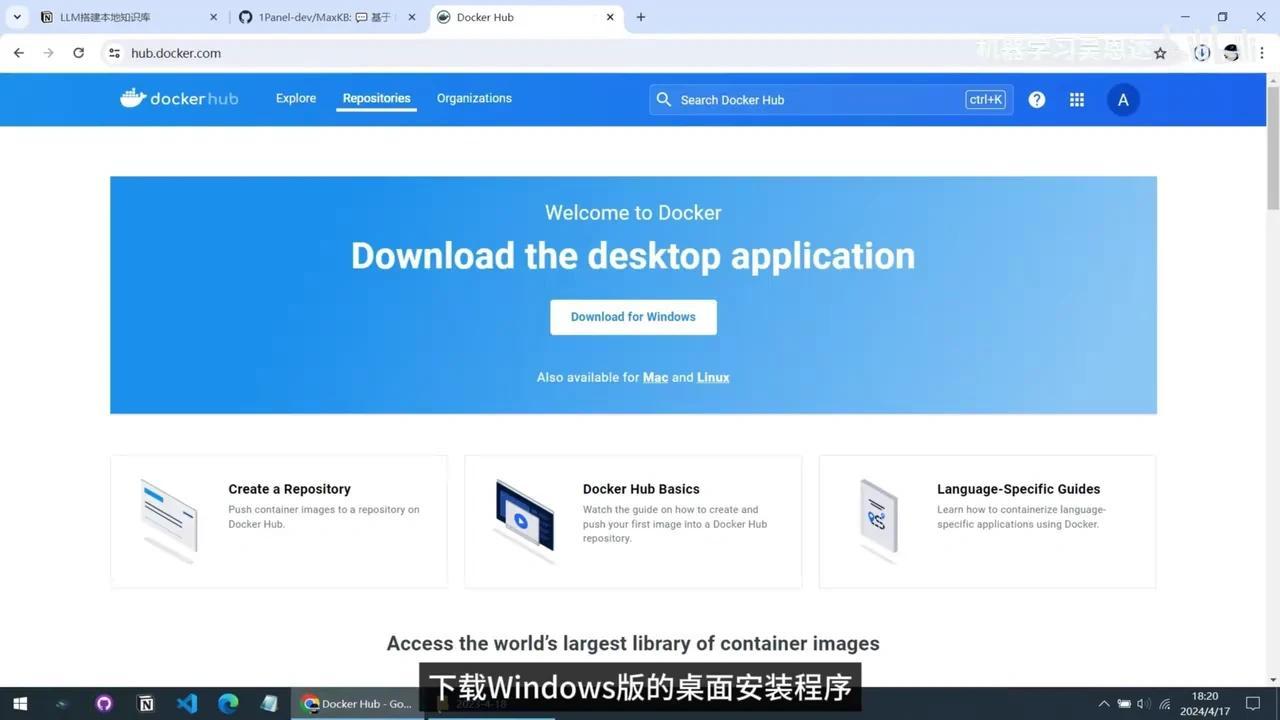

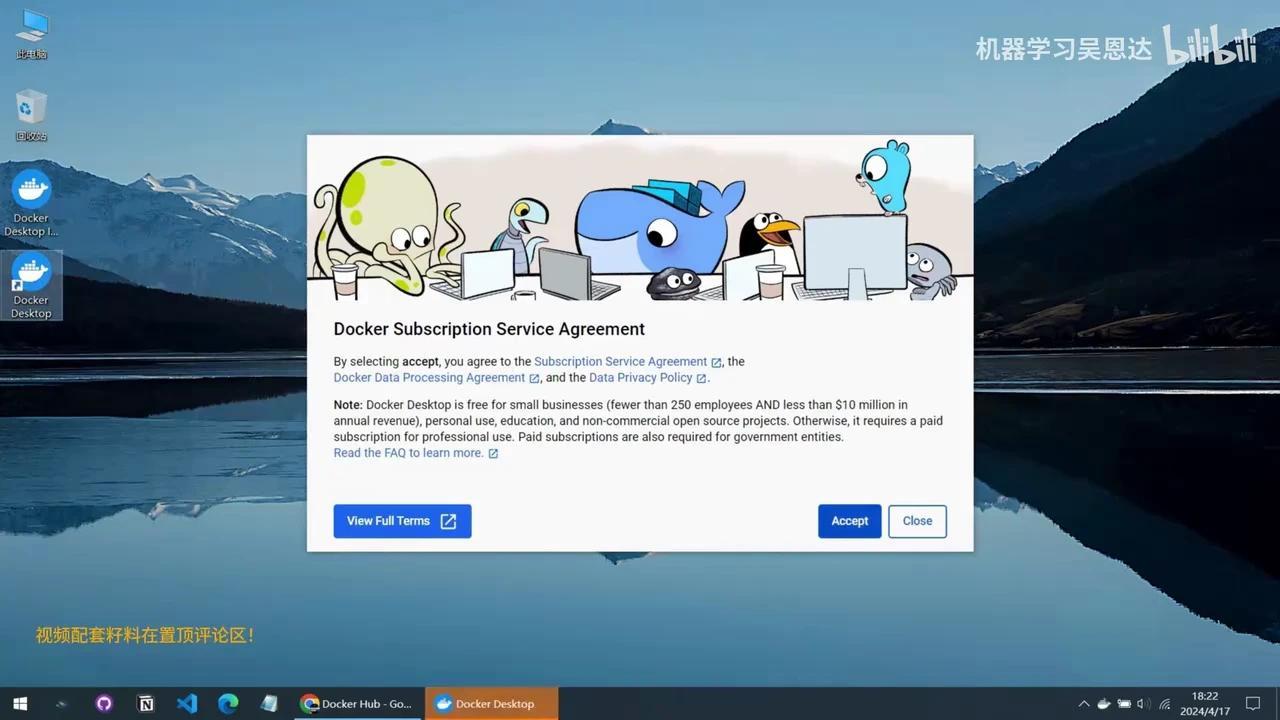

MaxKB目前官方仅提供Windows系统下的Docker安装方式。请访问Docker官网下载Windows版桌面安装程序。

下载完成后,我们开始安装。安装选项保持默认勾选状态,点击右下角的”OK”按钮即可开始安装。安装完毕后,双击桌面快捷方式启动程序,在弹出的协议界面点击”同意”。

欢迎界面底部提供跳过链接。等待数秒后,系统完成初始化即可开始部署MaxKB。

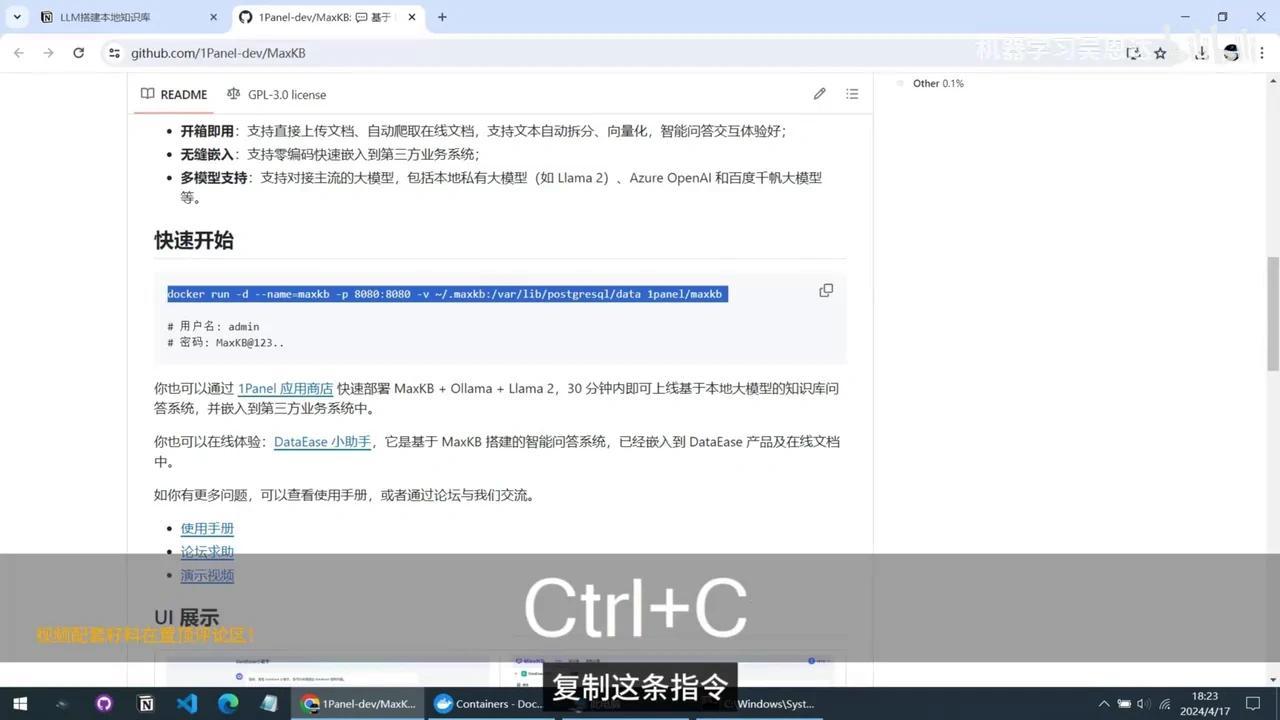

请将Docker窗口最小化,打开文件资源管理器,在地址栏输入CMD启动命令窗口。返回MaxKB主页,复制指定命令并粘贴至命令窗口执行。

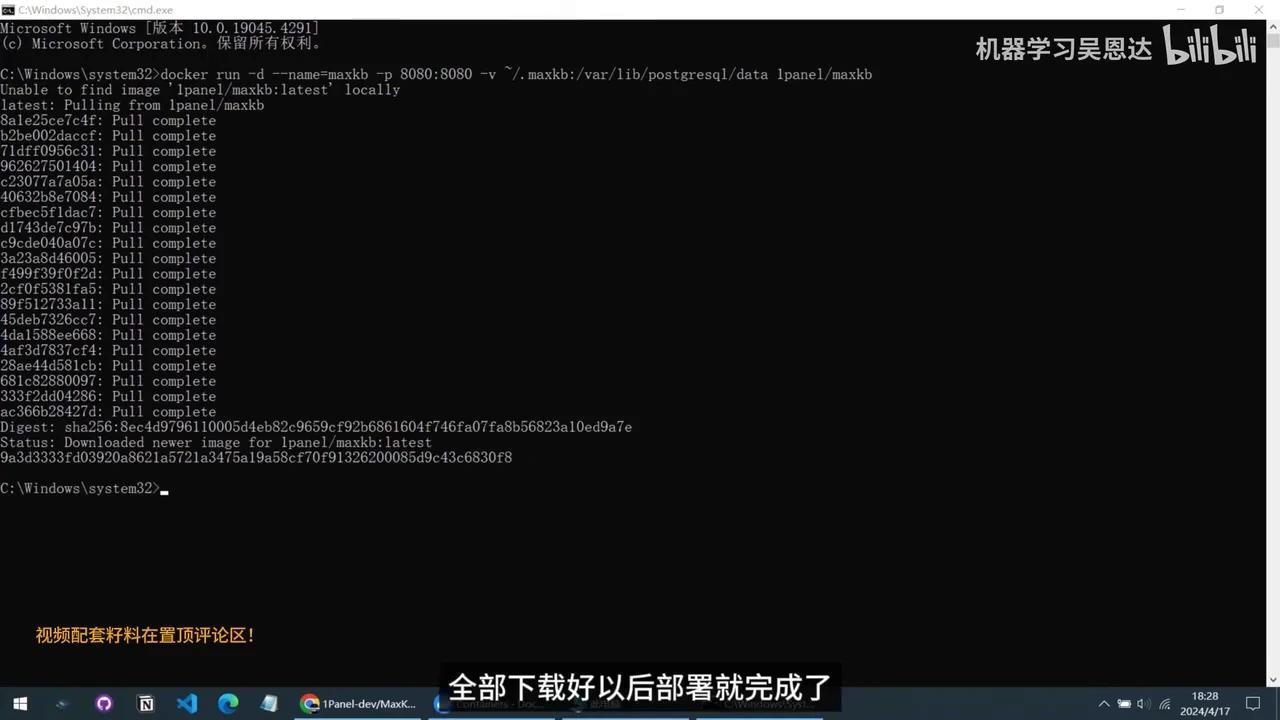

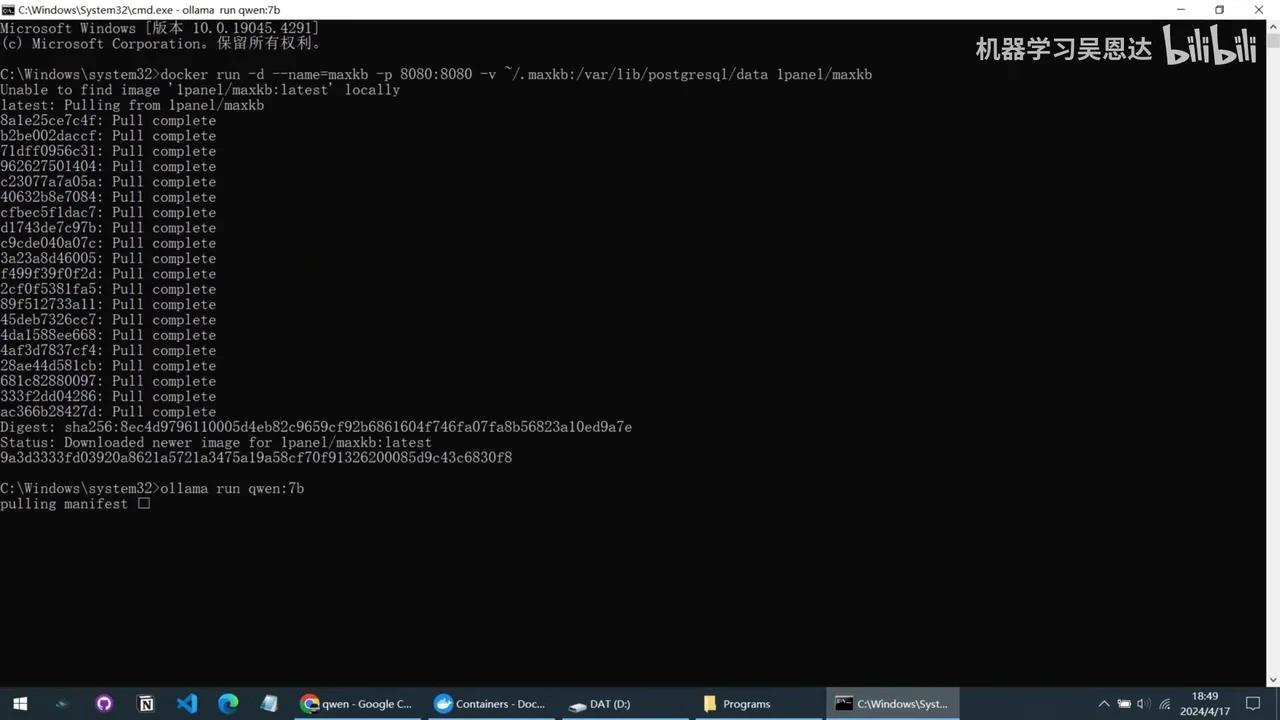

大约需要下载2GB左右的镜像文件。下载完成后,即可完成部署。

返回Docker界面,点击左侧菜单中的Images,即可看到MaxKB的镜像包。选择第一个Containers,可查看已部署的MaxKB容器。点击链接即可访问系统,默认用户名为Admin,密码需从项目主页获取。

这是操作主界面,标准流程为:

1. 先创建知识库

2. 再配置本地大语言模型

3. 最后创建应用,完成本地知识库搭建

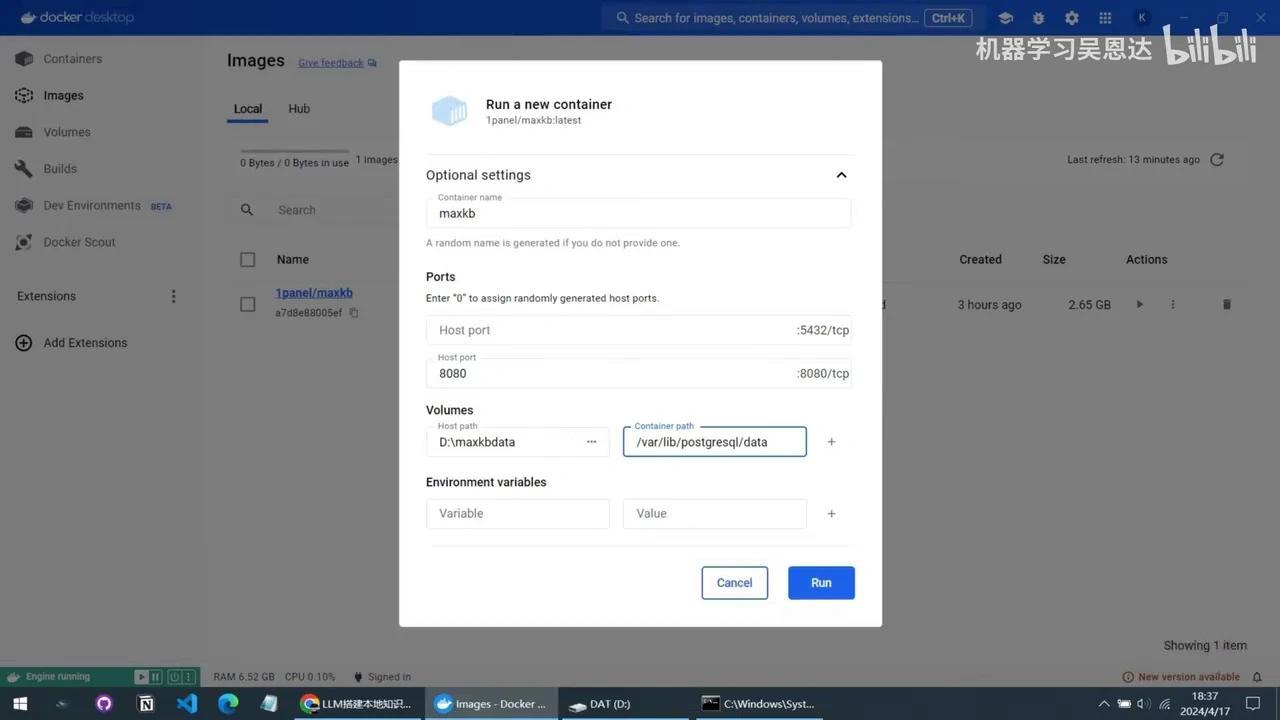

需要注意的是,若直接创建知识库,电脑重启后将丢失数据。解决方法为:删除自动部署的MaxKB容器并重新创建。

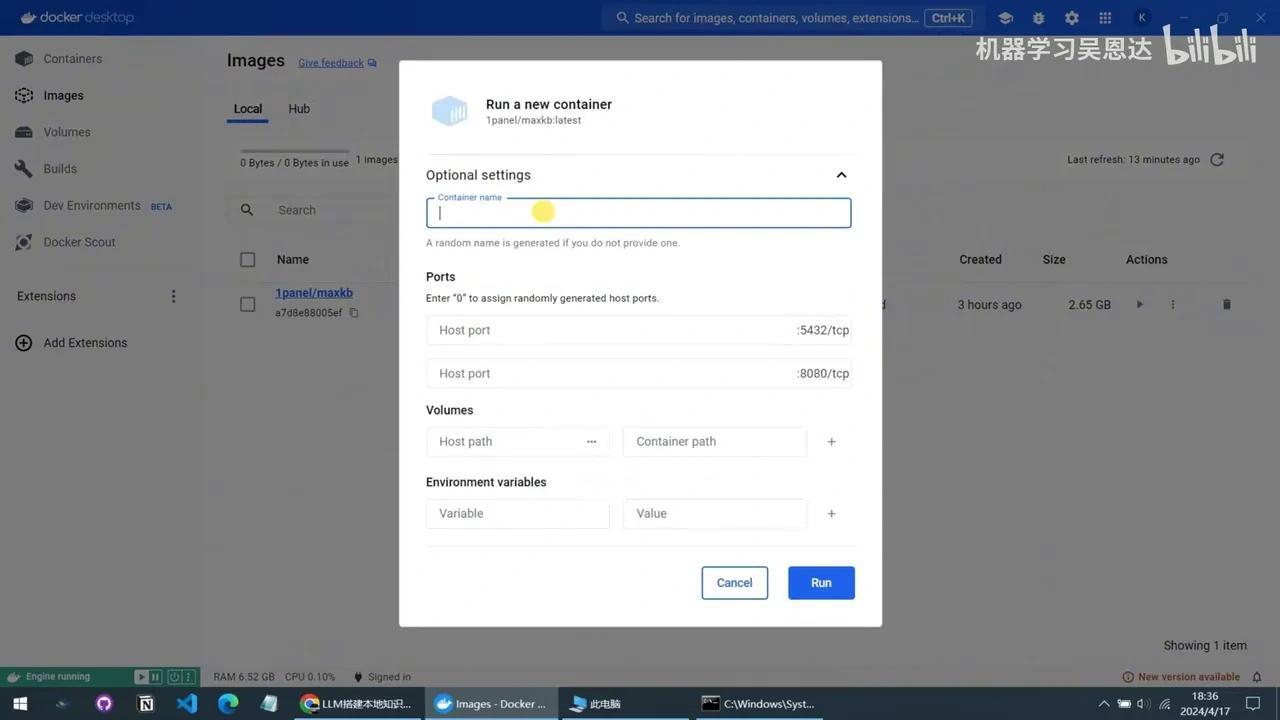

切换至Docker操作界面,选择Name下的MaxKB,进入第二个标签页。关闭右上角选项,找到PGData项,记录数据保存路径并复制。点击删除图标确认删除后,返回Images菜单。

点击三角图标重新创建容器,在弹出界面中展开选项:

– 容器名称填写MaxKB

– 第一个端口留空

– 第二个端口填写8080

接下来,在电脑上创建一个文件夹,用于保存本地知识库数据。建议选择非中文名称的文件夹。

创建完成后,返回Docker界面:

1. 点击 Host Path 选项,选择新建的文件夹。

2. 在 Content Path 处粘贴复制的路径。

3. 最后点击 Run 按钮。

出现该地址后,重新创建的容器即启动成功。此处可查看运行状态。点击端口链接可重新打开网页登录界面。

首先需创建知识库,包括命名、填写简要描述并选择类型。通用型适用于本地文档,Web站点型可指定网页地址由系统爬取内容。本次选择通用型进行测试,点击上传文档按钮,支持格式包括PDF、Word、Markdown及纯文本文件。选定文档后点击创建并导入按钮,进入文档预览界面可查看内容。左侧设置分段规则,建议采用推荐的智能分段方式。点击开始导入后,系统将在后台执行导入操作,耗时取决于文档内容量,此过程不影响其他操作。

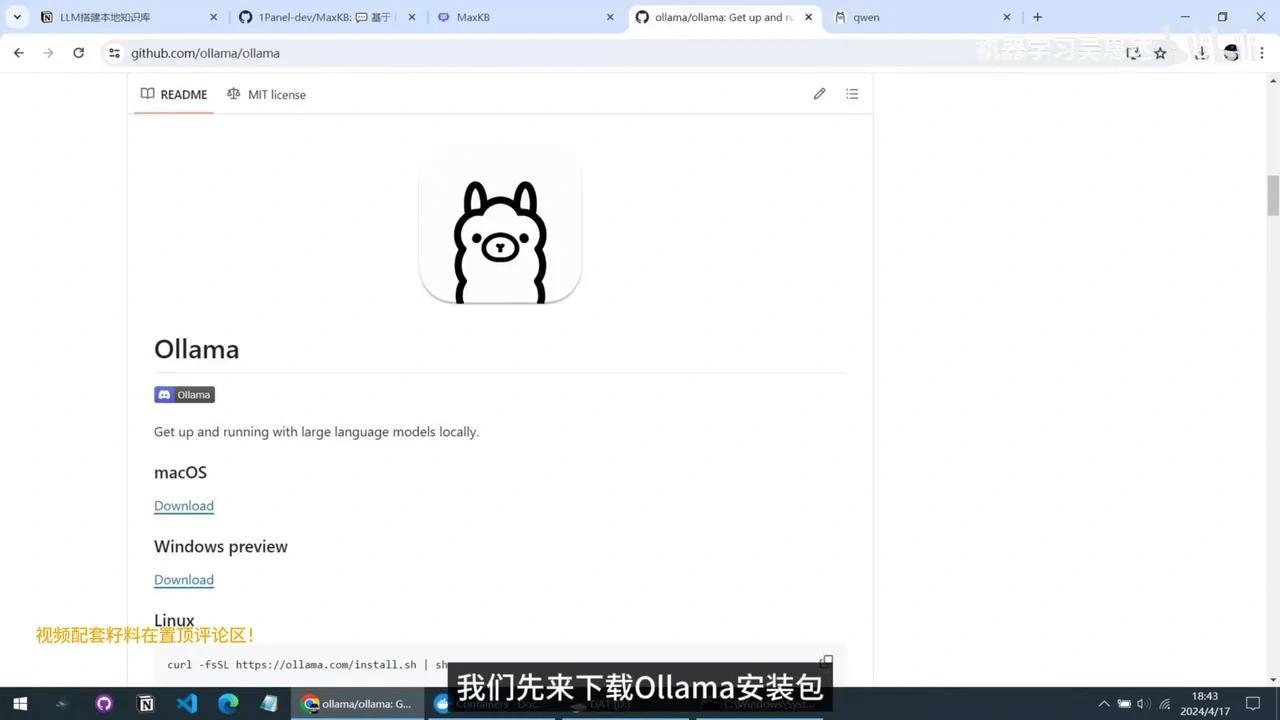

接下来进入大语言模型配置环节。通过系统设置进入模型设置界面,可见MaxKB当前支持微软云、百度千帆及GPT等在线接入方案,需配置对应账号及API密钥。若需对接本地运行的开源大模型如Llama 2、Gemma等,需选择Ollama方案。Ollama作为全平台本地大模型运行框架,采用开源免费模式,其开源地址页面列举了支持的全部大语言模型,包括Llama、谷歌Gemma、Mistral及通义千问等。通过Ollama可实现这些模型的本地化运行,功能强大。后续将制作专题视频详细介绍。

现需下载Ollama安装包,点击Windows版本下载链接完成安装。

点击Install按钮完成安装后,Docker Desktop将自动运行,并在桌面右下角显示Ollama图标。

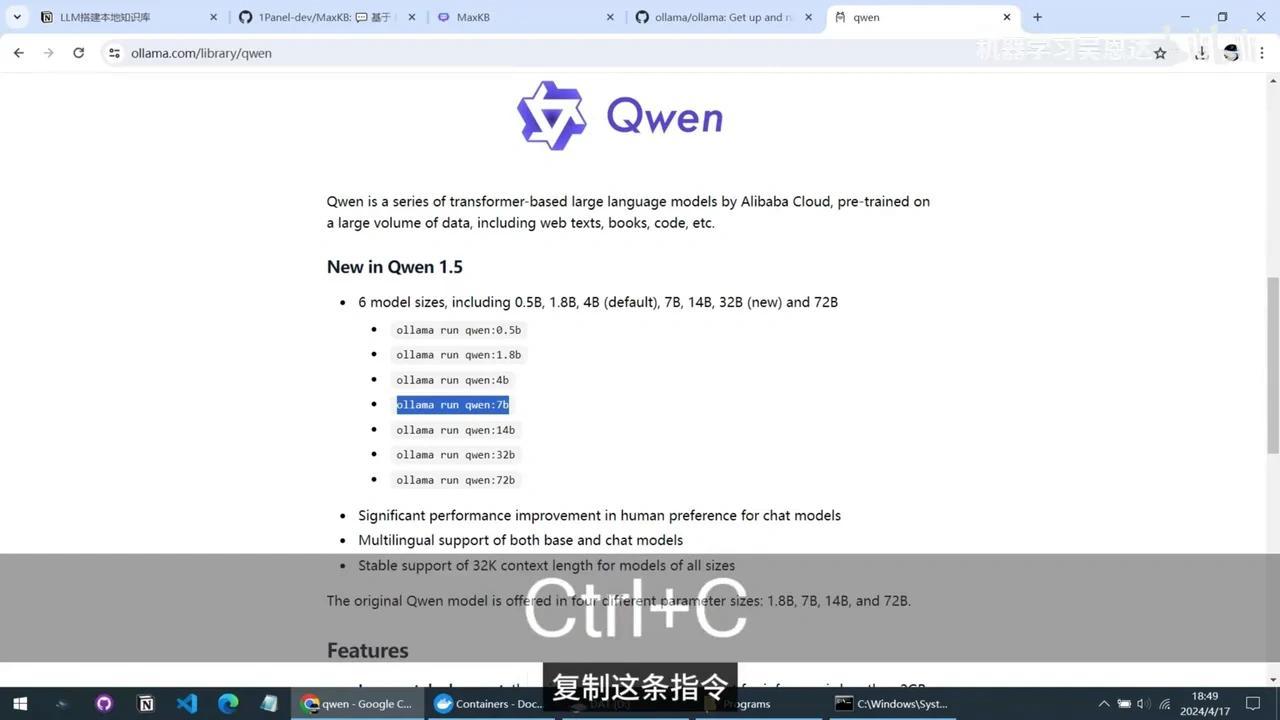

回到Ollama的模型库页面,我们需要选择一个适合本地运行的模型。这里我选择阿里巴巴的Qwen1.5,因为创建的本地知识库内容主要是中文。虽然Llama 2和Gemma性能也很出色,但对中文的支持不如国产大模型。

由于我的显卡仅有8GB显存,最大只能运行7B版本,因此选择Qwen1.5 7B。复制这条指令后,切换回命令窗口。

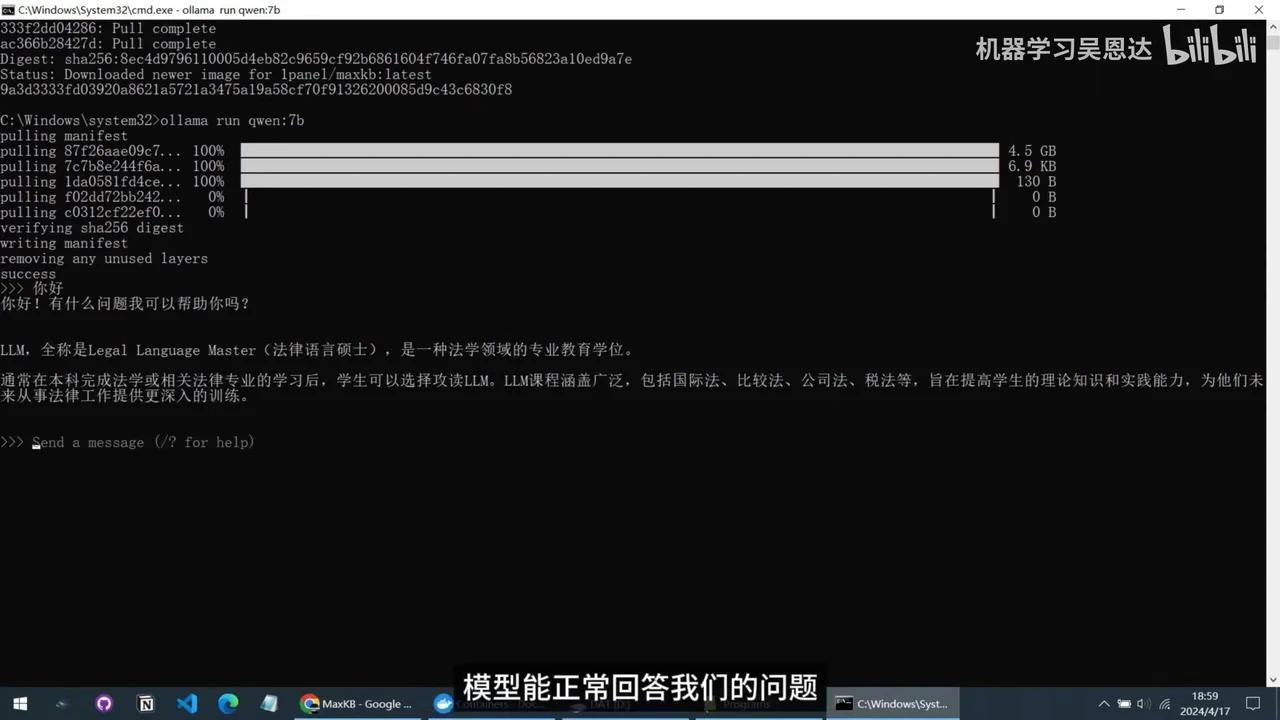

粘贴后按回车执行。Ollama将自动下载模型文件,总大小为4.5GB。下载过程需要一定时间。国内提供镜像下载,无需开启代理。

接下来,我们继续在 MaxKB 中添加模型。将模型名称设置为“千帆7B”,类型选择“大语言模型”。在模型列表中可以手动输入,需确保与 Ollama 指令中的模型名称一致。

API域名填写为http://127.0.0.1:11434,API密钥可随意输入。点击添加按钮后,若提示“API域名无效”,需将127.0.0.1修改为host.docker.internal。这是因为 MaxKB 运行在虚拟系统中,而 Ollama 安装在本地 Windows 系统内,需通过此约定实现两者通信。

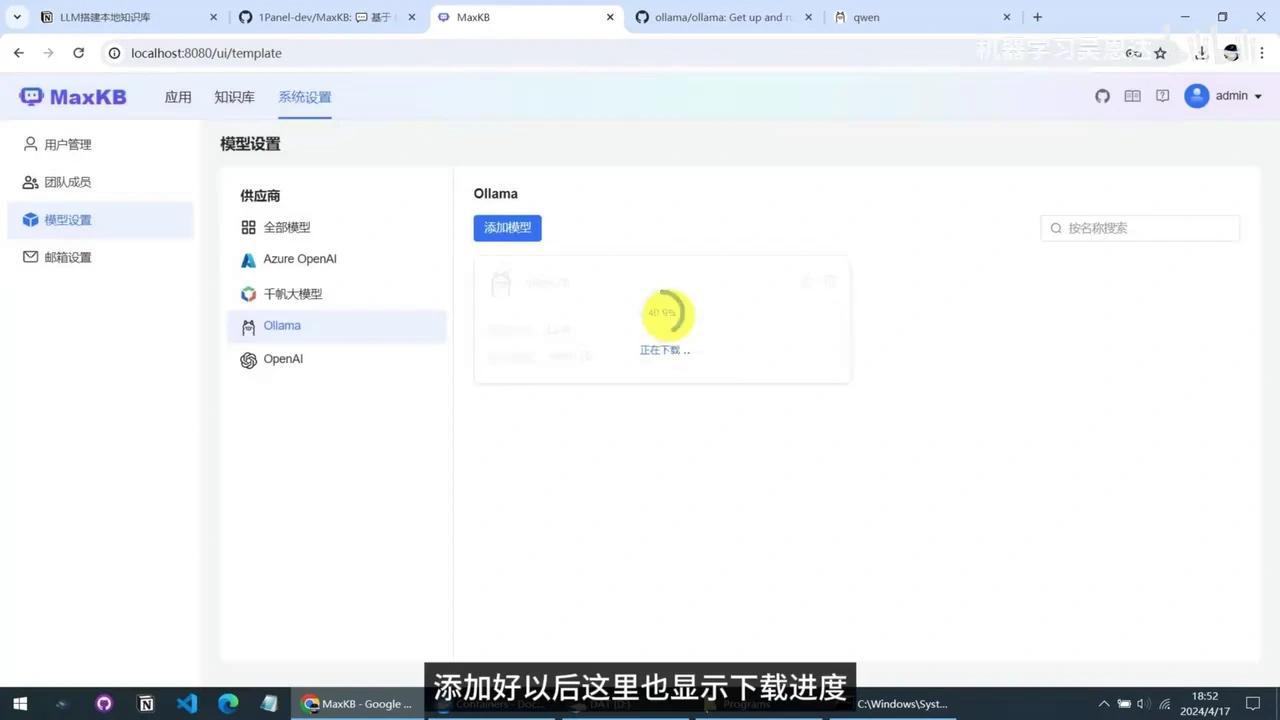

修改后即可成功添加模型,添加完成后将显示下载进度,该进度与命令行窗口中的进度同步。

下载完成。

现在,大语言模型已成功添加。可以切换回命令窗口,输入对话进行测试。模型能够正常回答问题。输入“-buy”可退出对话。此时,命令窗口也可关闭。返回MaxKB页面,查看知识库内容。

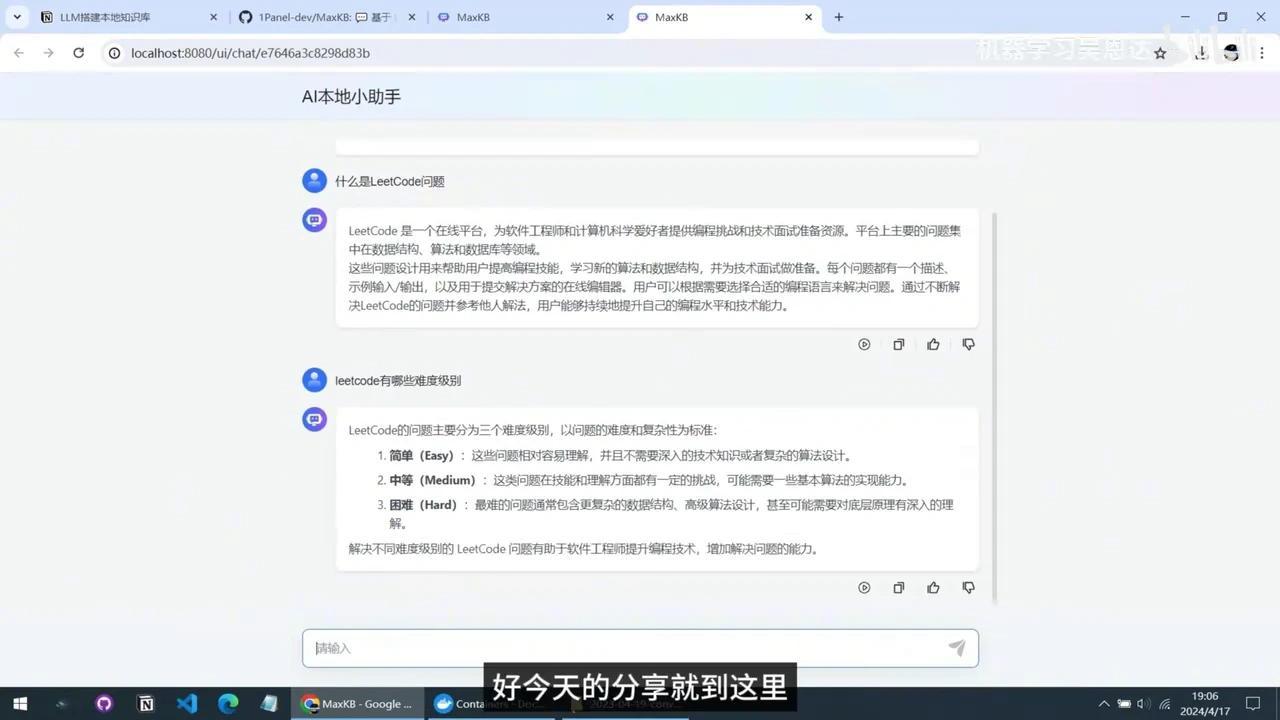

文档已成功导入。接下来进行最后一步——创建应用。

首先填写应用名称和简要描述,然后选择AI模型。在下拉菜单中可以看到我们之前创建的Llama 7B模型。提示词可用于对模型回答进行要求和约束,此处暂时使用默认设置。

启用多功能对话选项后,需关联知识库,此步骤至关重要。点击“添加”按钮,选择已创建的知识库。若不进行关联,模型回答将与上传的文档内容无关。

最后进行快捷提问设置,可预先配置提问方式。完成所有设置后点击“创建”按钮。至此,一个基于大语言模型的本地文档理解系统已搭建完成。

点击对话按钮可进入交互页面。测试快捷提问功能,响应速度较为理想。

将其与上传的文档内容进行对比。