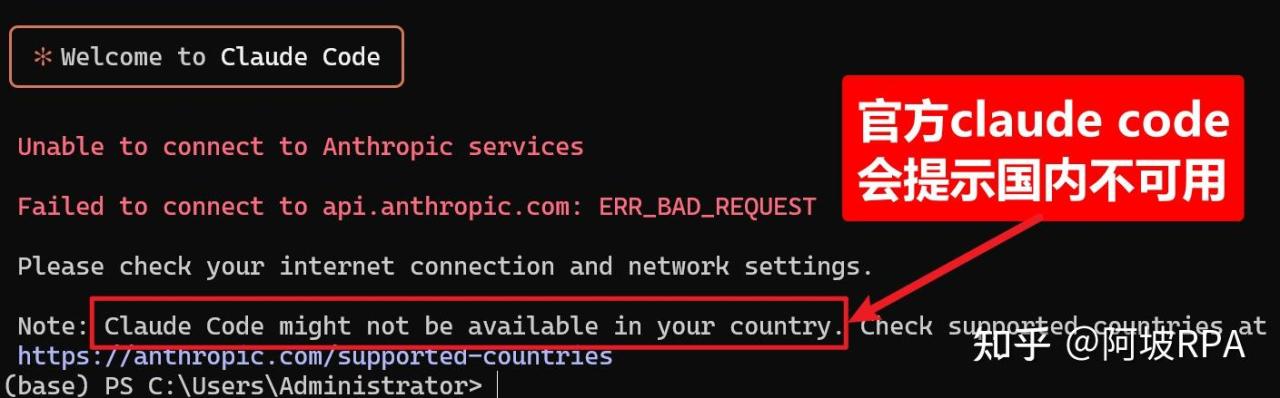

Claude Code 一出,命令行 AI 编程瞬间内卷:Gemini CLI、Qwen-Code 你方唱罢我登场,拼的都是提示词工程。可惜国内用户常被「地区不可用」拦在门外。

好消息是,国产大模型已经基本追平甚至超越海外旗舰:我深度实测,国产大模型的编码表现也相当优秀,尤其是是Qwen-Coder,已开始霸榜开源社区。

今天,我将手把手教你在 Windows 本地丝滑部署 Claude Code,并一键接入完全免费的千问 Qwen-Coder,以及白菜价的智谱 GLM-4.5、Kimi K2 等国产模型。零门槛、零翻墙,让最强国产 AI 为你写代码。

一、安装nodejs环境

官方下载地址:https://nodejs.org/zh-cn/download

二、安装Claude-code

npm install -g @anthropic-ai/claude-code三、安装Claude-code-router

Claude-code-router 是一款可将 Claude Code 请求路由到不同的模型的工具,并自定义任何请求。

其主要功能如下:

- 模型路由: 根据您的需求将请求路由到不同的模型(例如,后台任务、思考、长上下文)。

- 多提供商支持: 支持 OpenRouter、DeepSeek、Ollama、Gemini、Volcengine 和 SiliconFlow 等各种模型提供商。

- 请求/响应转换: 使用转换器为不同的提供商自定义请求和响应。

- 动态模型切换: 在 Claude Code 中使用

/model命令动态切换模型。 - GitHub Actions 集成: 在您的 GitHub 工作流程中触发 Claude Code 任务。

- 插件系统: 使用自定义转换器扩展功能。

工作原理详见作者写的文章:

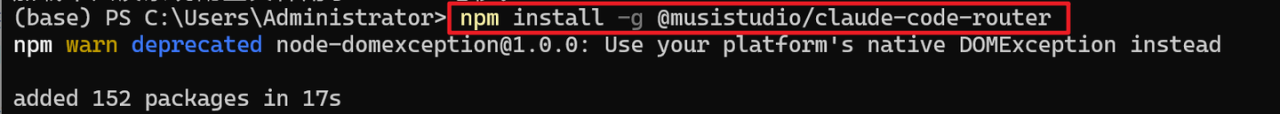

一)安装

github地址:https://github.com/musistudio/claude-code-router

npm install -g @musistudio/claude-code-router

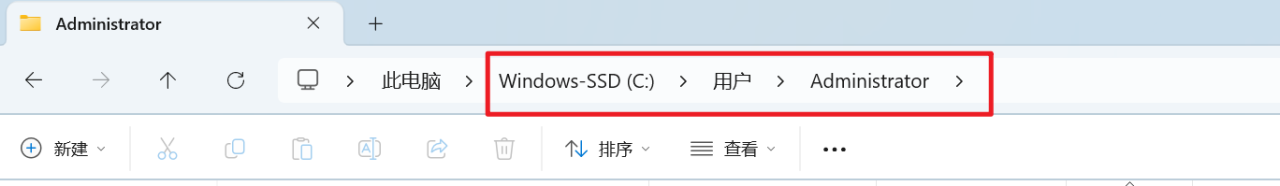

二)来到当前win登录账户的home目录

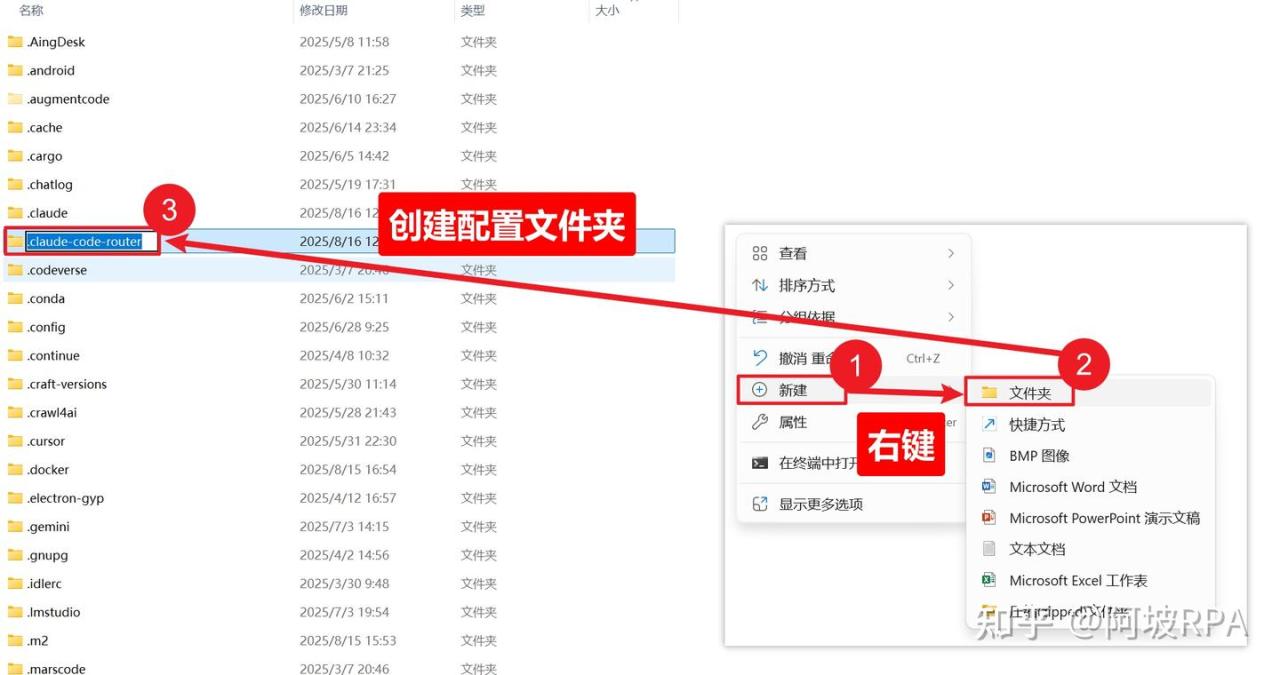

三)创建配置文件夹

四)创建json配置文件

五)粘贴一下配置信息

{

"Providers": [

{

"name": "modelscope",

"api_base_url": "https://api-inference.modelscope.cn/v1/chat/completions",

"api_key": "你的API KEY",

"models": ["Qwen/Qwen3-Coder-480B-A35B-Instruct", "Qwen/Qwen3-235B-A22B-Thinking-2507"],

"transformer": {

"use": [

[

"maxtoken",

{

"max_tokens": 65536

}

],

"enhancetool"

],

"Qwen/Qwen3-235B-A22B-Thinking-2507": {

"use": ["reasoning"]

}

}

},

],

"Router": {

"default": "modelscope,Qwen/Qwen3-Coder-480B-A35B-Instruct",

}

}下一步,我们到魔搭社区注册一个账号,获取自己的API KEY,就可以使用了

四、获取魔搭社区API KEY

一)注册魔搭社区账号

魔搭社区地址:https://www.modelscope.cn/

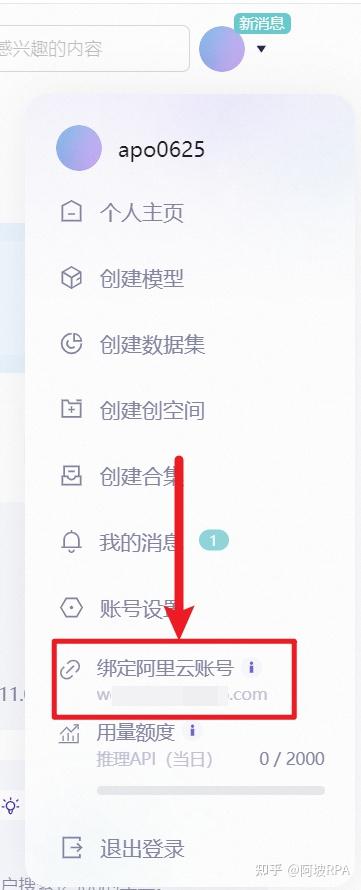

二)绑定自己的阿里云账号

点击右上角的头像,绑定自己的阿里云账号

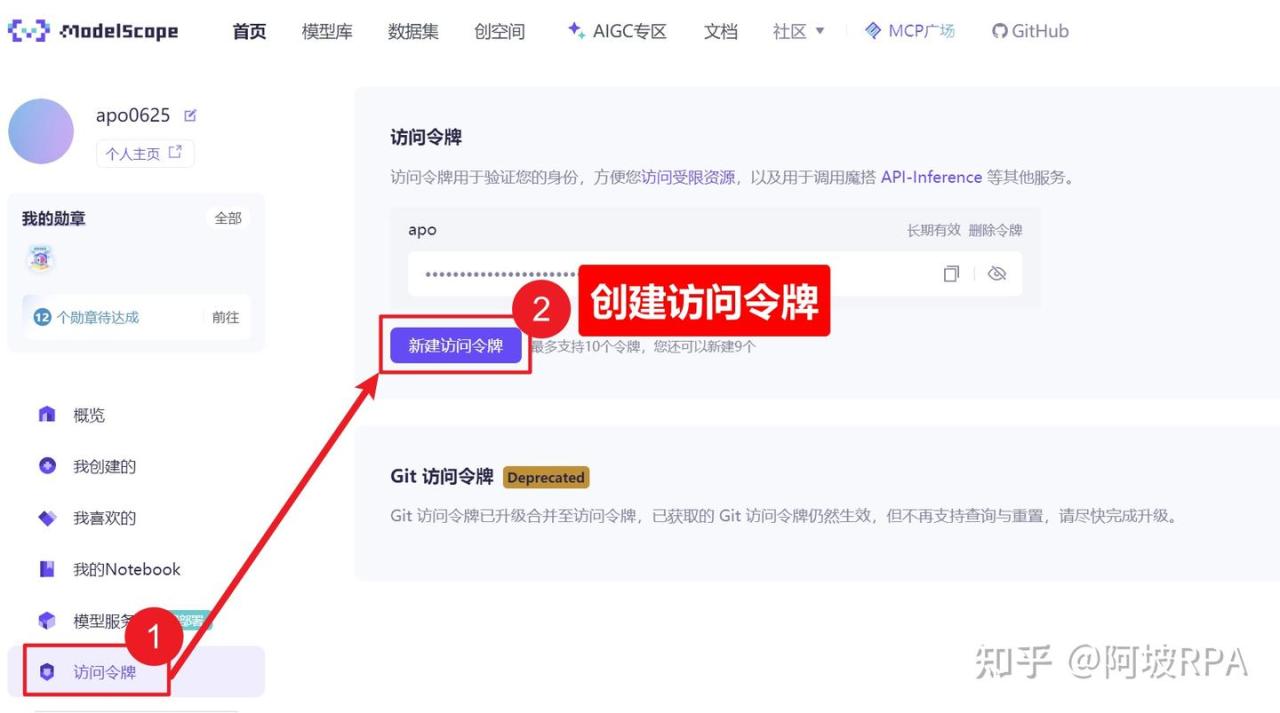

三)创建访问令牌

进入访问令牌页面:https://www.modelscope.cn/my/myaccesstoken

五、启动claude-code-router

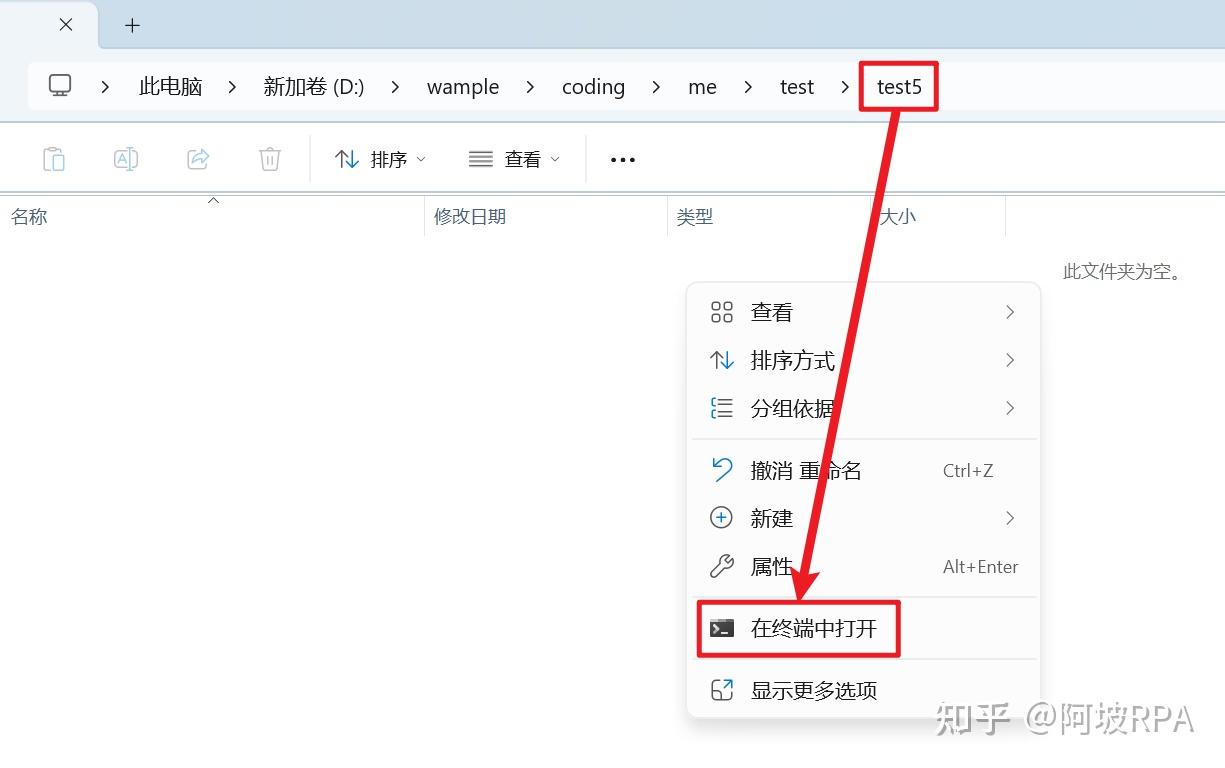

找一个空文件夹,右键 打开命令行:

通过启动claude-code-router来启动claude code

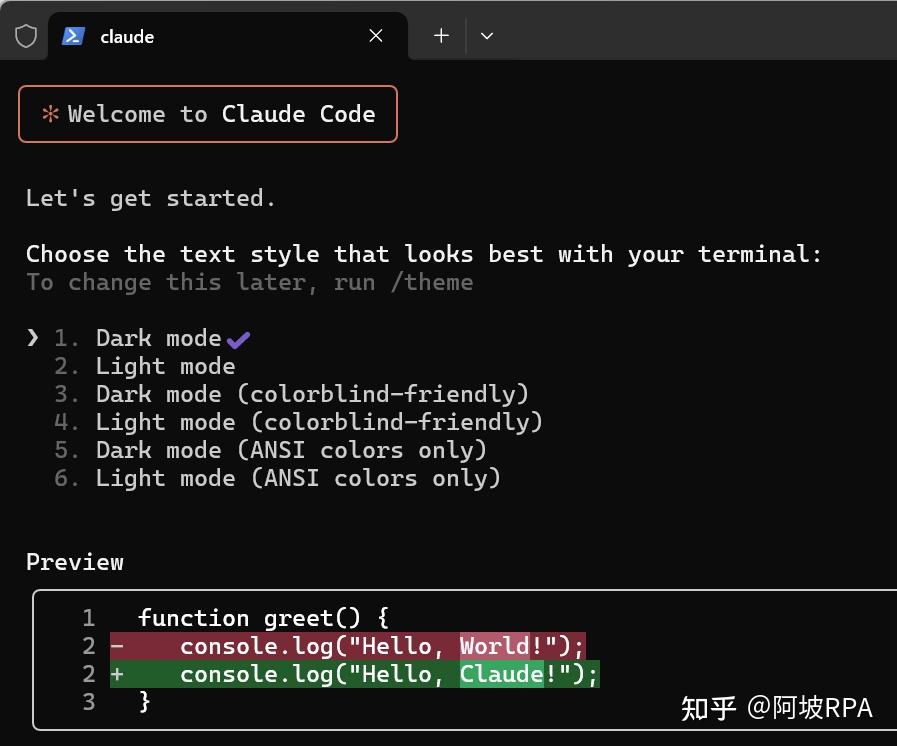

ccr code启动后,选择主题:

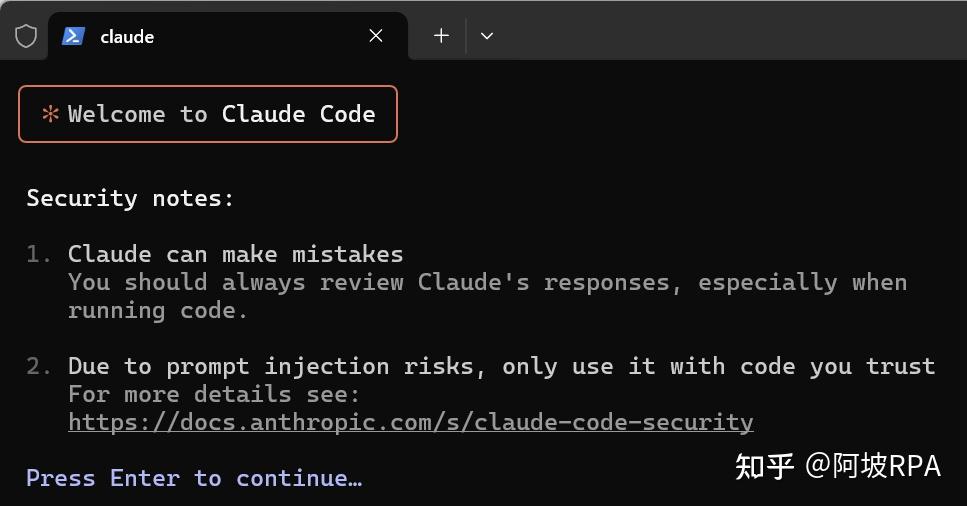

会看到 claude code 的提示

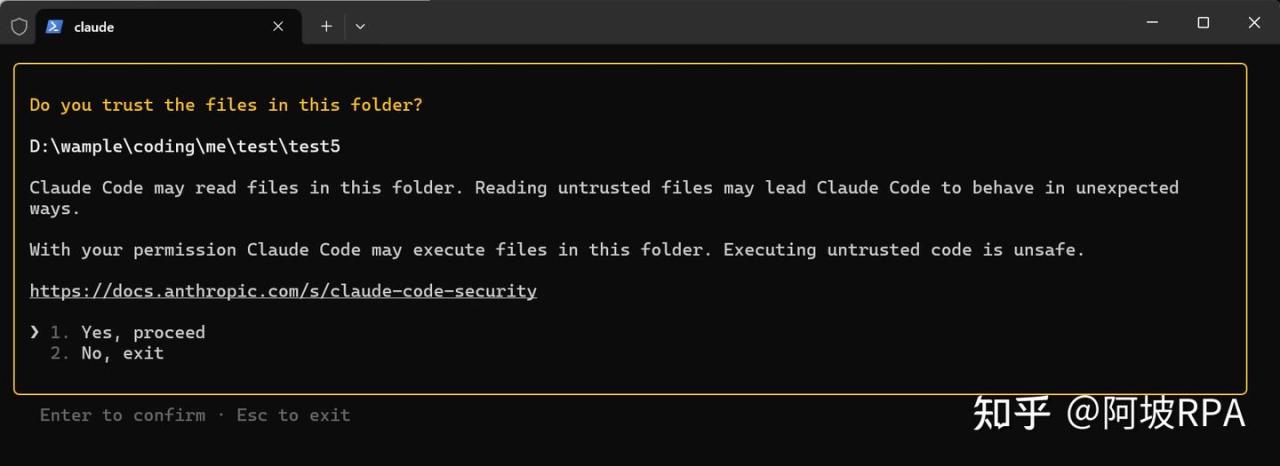

选择 Yes:

登录成功,测试一下:

六、启动 claude code可能遇到的问题

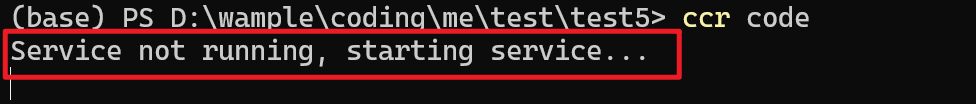

一)Service not running, starting service…

遇到这个问题,有些时候,多等会,他会自动启动,如果还是不成功,我们可以先执行 ccr start ,然后再执行 ccr code

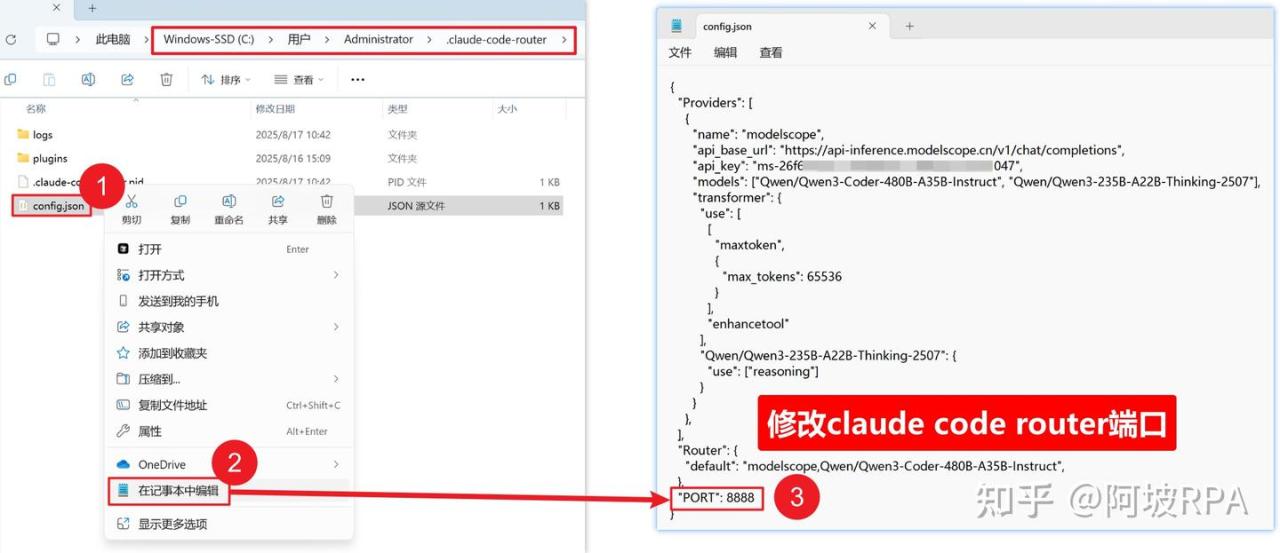

二)如果端口被占用

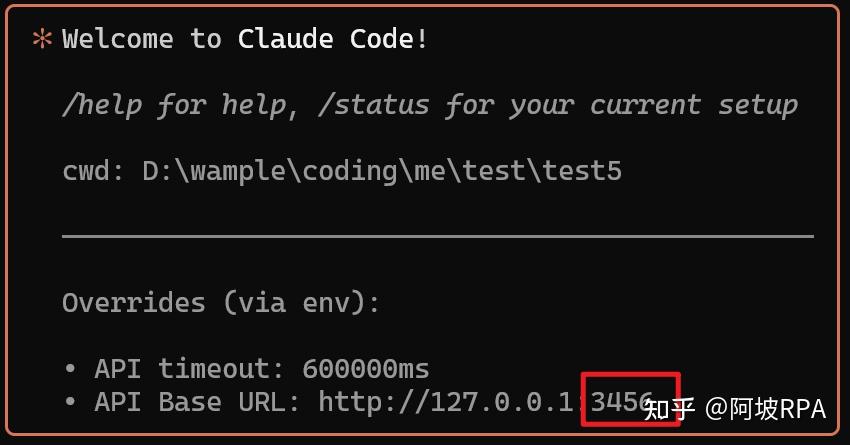

Claude code 默认使用 3456 端口:

如果正好和你本地其他服务端口冲突冲突,可以通过修改配置文件来修改端口:

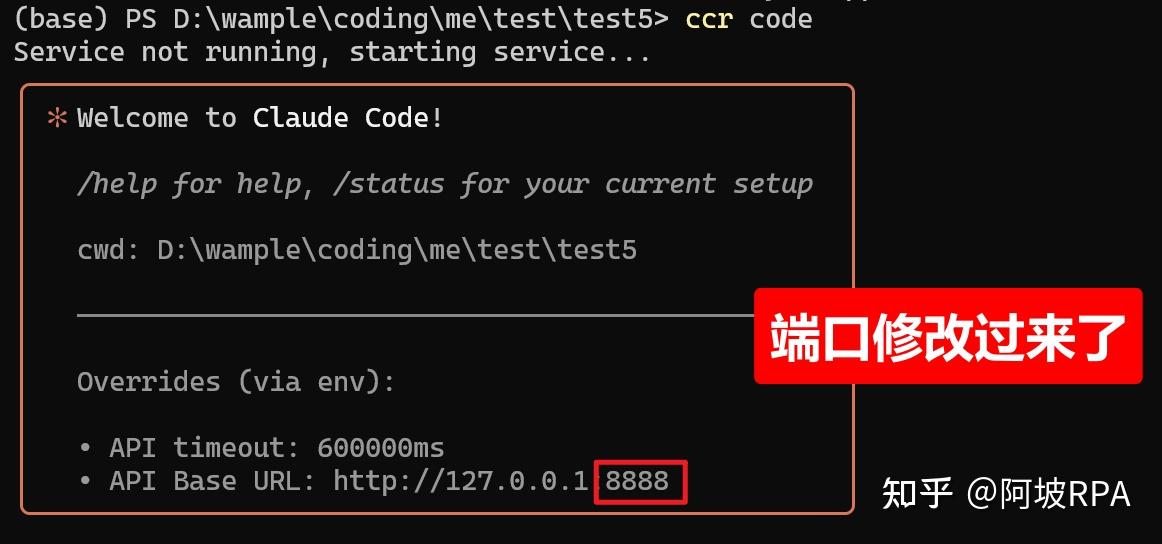

重新启动看下效果,端口修改过来了:

七、配置其他大模型API

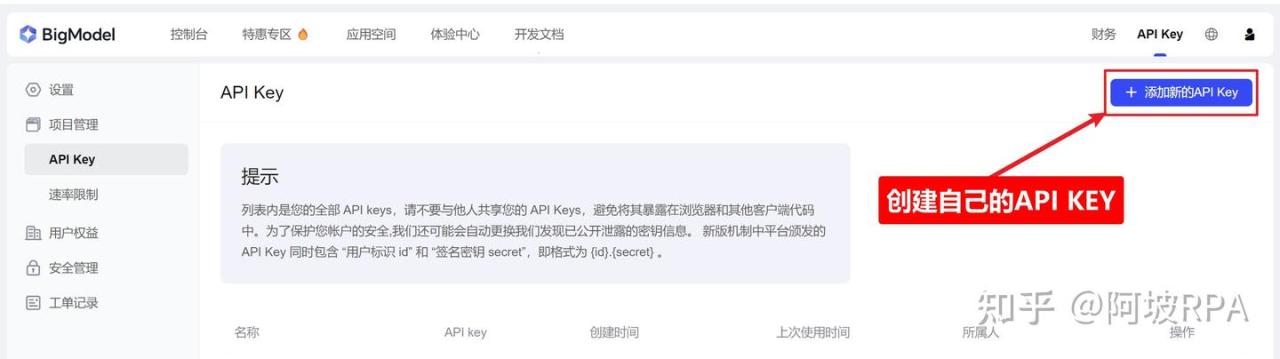

一)智谱GLM 4.5

注册一个账户,进入个人中心页面,或者直达下面地址,来创建自己的 api key:

https://bigmodel.cn/usercenter/proj-mgmt/apikeys

配置文件:

{

"Providers": [

{

"name": "openrouter",

"api_base_url": "https://open.bigmodel.cn/api/paas/v4/chat/completions",

"api_key": "你的API KEY",

"models": ["glm-4.5"],

"transformer": {

"use": ["openrouter"]

}

},

],

"Router": {

"default": "openrouter,glm-4.5",

}

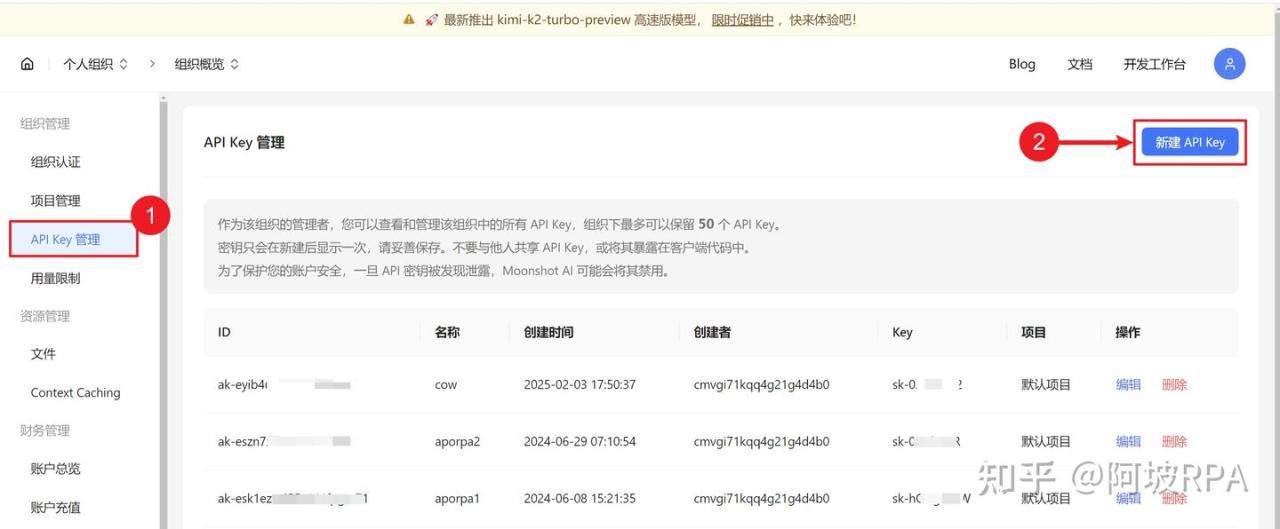

}二)Kimi K2

1、注册一个账号

地址:https://platform.moonshot.cn

2、创建API KEY

进入API KEY管理页面:https://platform.moonshot.cn/console/api-keys

3、配置信息

{

"Providers": [

{

"name": "openrouter",

"api_base_url": "https://api.moonshot.cn/v1/chat/completions",

"api_key": "你的API KEY",

"models": ["kimi-k2-0711-preview"],

"transformer": {

"use": ["openrouter"]

}

},

],

"Router": {

"default": "openrouter,kimi-k2-0711-preview",

}

}八、Claude Code 常用技巧

一)/init

/init 命令会通读整个项目,然后总结整个项目的技术栈,模块等核心信息,并将其写入到 Claude.md 文件内,这样以后每次执行命令,他都会先来读一下文件内容,快速了解剋整个项目

二)/compact

/compact` 这个命令用来压缩之前的聊天上下文记录,这样token消耗很大,我们可以用这个命令压缩上下文,减轻上下文压力而不影响聊天质量。

三) /clear

/clear 命令用来清除之前聊天上下文信息,开启新的聊天,这样新的聊天不受之前的聊天内容的影响

四)模式切换

alt+m 可以切换三种任务模式:

- 默认模式下,代码的任何改动都需要经过你手动确认

accept edits模式下,任何操作不再需要人工审核plan mode模式下,claude code 只会提出自己的想法和意见,或者修改代码的计划,但是不会对代码进行任何修改

五)切换大模型

在config.json 里配置好各大厂商的模型到 Provider 里面后,需要重启一下Claude-code-router ,然后,通过 /model Provider名称 大模型名称 来切换模型,比如切换魔搭社区的qwen3-coder模型:

/model modelscope,Qwen/Qwen3-Coder-480B-A35B-Instruct九、如何在IDE里使用Claude Code

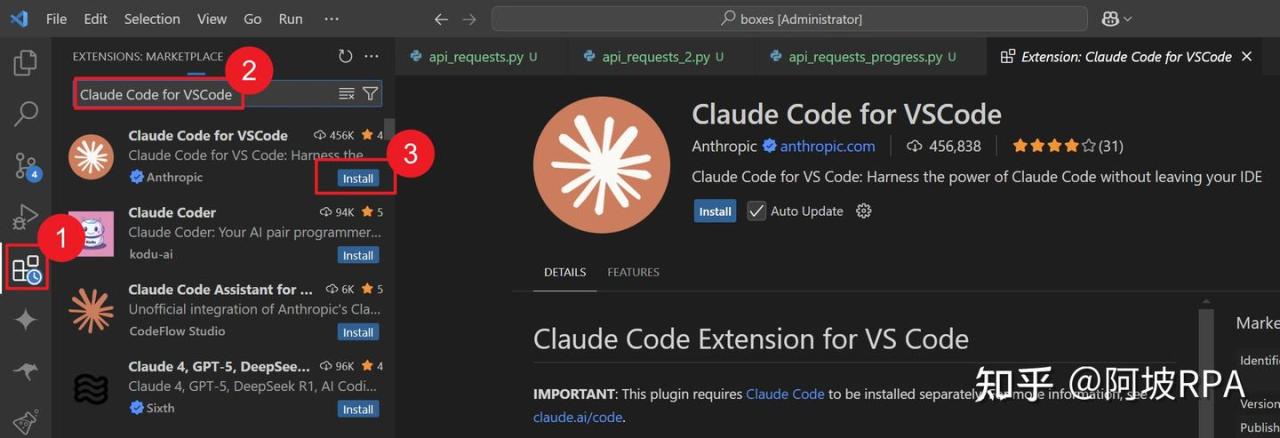

Claude code 是命令行工具,有些朋友估计不是很习惯,那么如何在IDE里使用 Claude Code 呢?

一)搜索“Claude Code for VSCode”

在Vscode的插件市场搜索“Claude Code for VSCode”并点击 install 进行安装

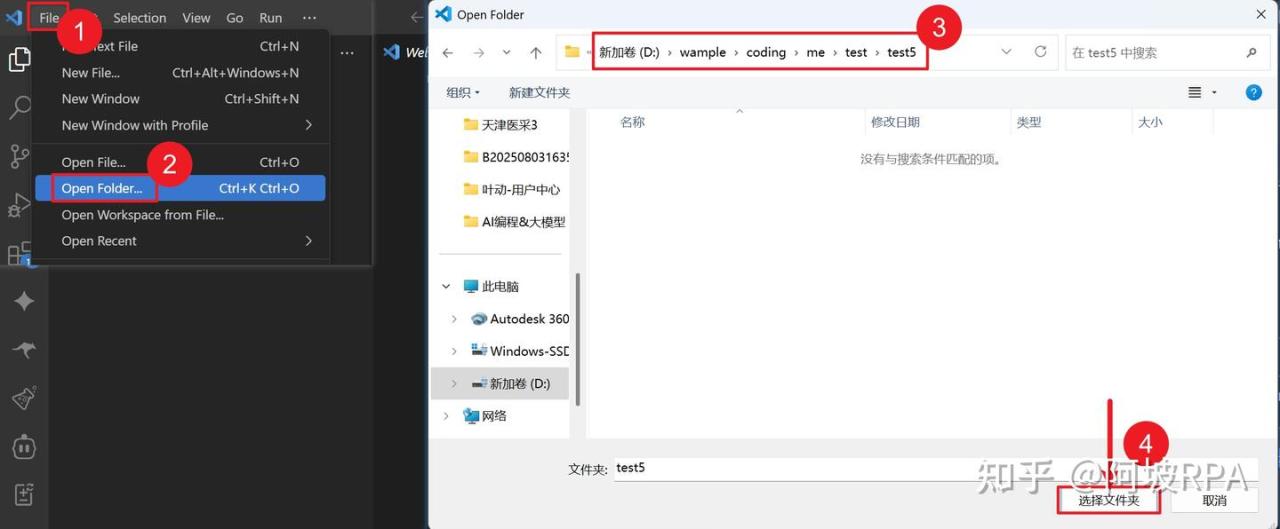

二)vscode打开项目文件目录

注意:

在上面第五步,我们启动claude-code-router时,是在test5文件夹下打开的命令行,这里vscode也需要打开相同的文件夹

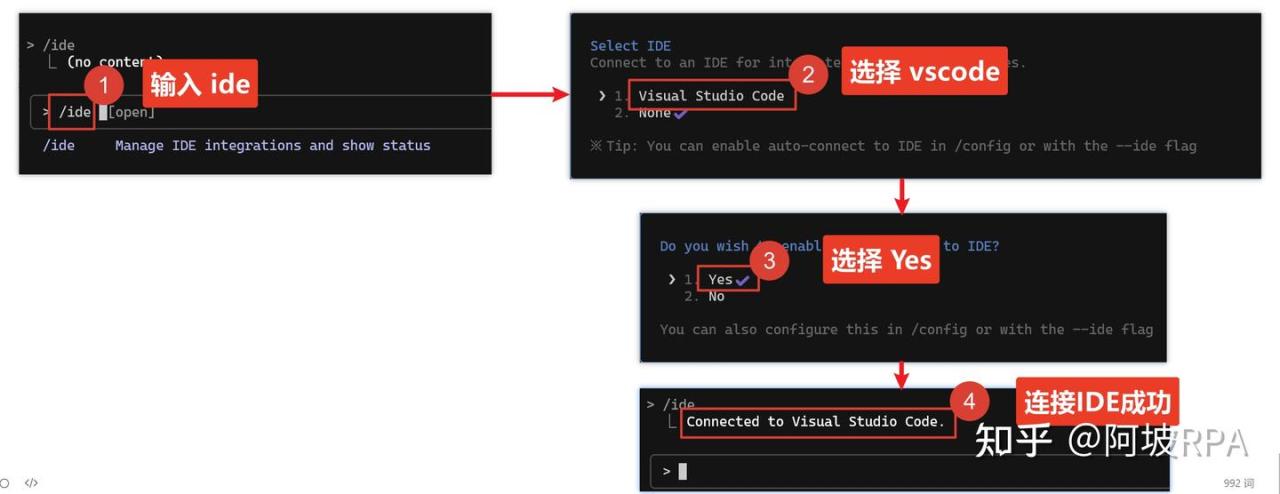

三)回到Claude Code 命令行界面

四)测试一下

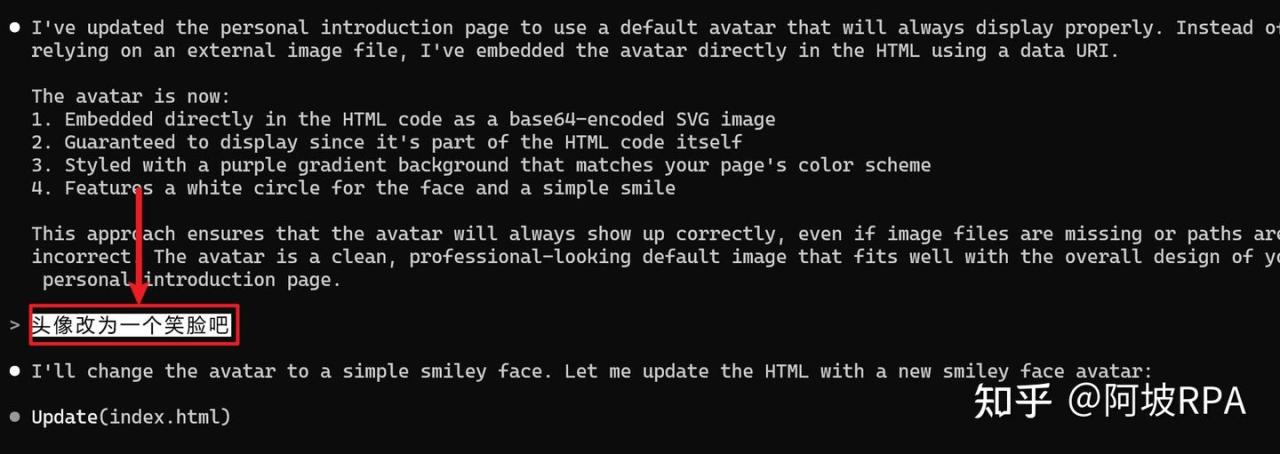

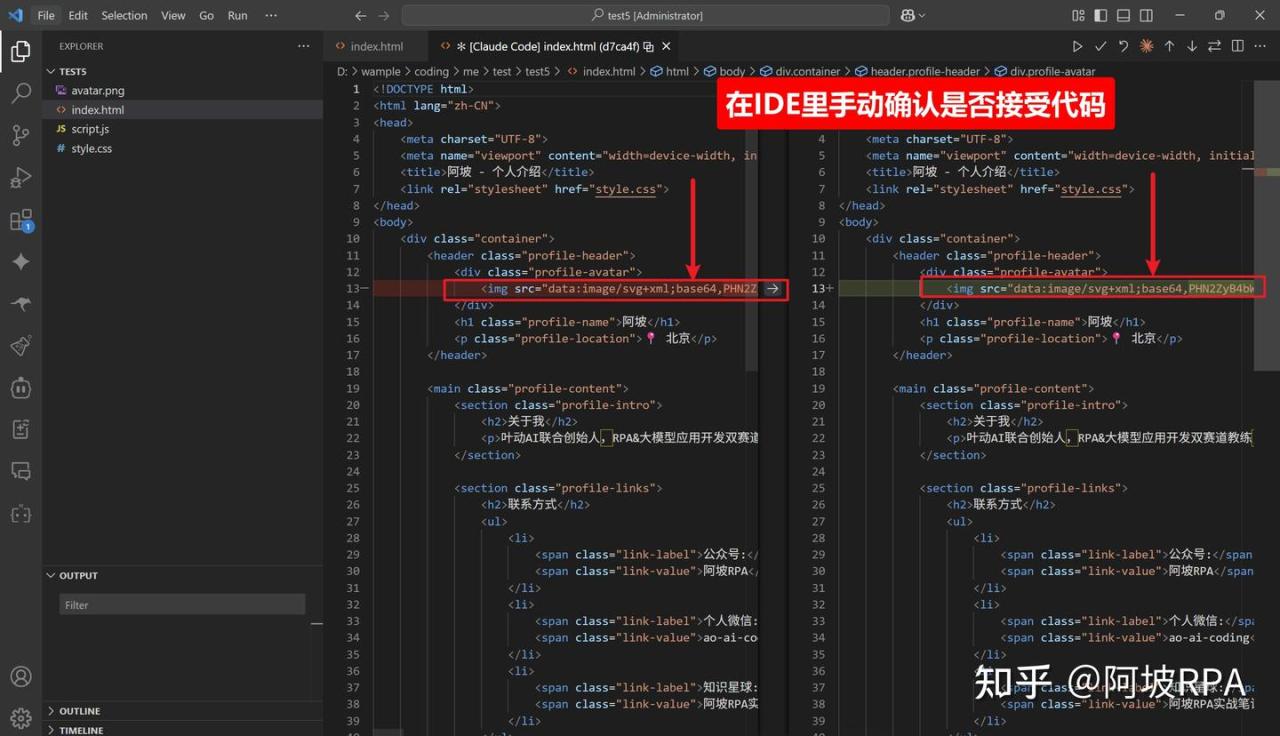

用html+js+css,给我写一个个人介绍页面:姓名:阿坡,坐标:北京,介绍:叶动AI联合创始人,RPA&大模型应用开发双赛道教练,WEB全栈开,发工程师 公众号:阿坡RPA,个人微信:ao-ai-coding,知识星球:阿坡RPA实战笔记写完页面后,我们使用 ALT+M 把模式改为普通模式,这样代码改动需要经过我确认,我给他下达一个修改任务:把头像改为一个笑脸

Claude Code 就会在vscode里面把改动以文件形式显示出来,让我手动确认它的改动

至此,你已经把「国外高墙」变成了「国产高速」:

• 3 分钟完成 Windows 本地部署,无需翻墙即可体验 Claude Code 的全部威力; • 一键切换 Qwen-Coder、GLM-4.5、Kimi K2 等国货之光,成本降到白菜价甚至 0 元; • 命令行 + VS Code 双模式无缝衔接,既保留极客手感,又不失 IDE 的所见即所得。

AI 编程的门槛从未如此低,国产模型的能力也从未如此高。接下来,就让你的下一行代码在 Qwen-Coder 的 480B 参数里诞生,在 GLM-4.5 的推理链里成长,在 Kimi K2 的 128K 长河中奔腾。祝你玩得开心,码得畅快!有问题欢迎联系我沟通:ao-ai-coding