沉浸式翻译并非是什么新东西,主要优势有两点:

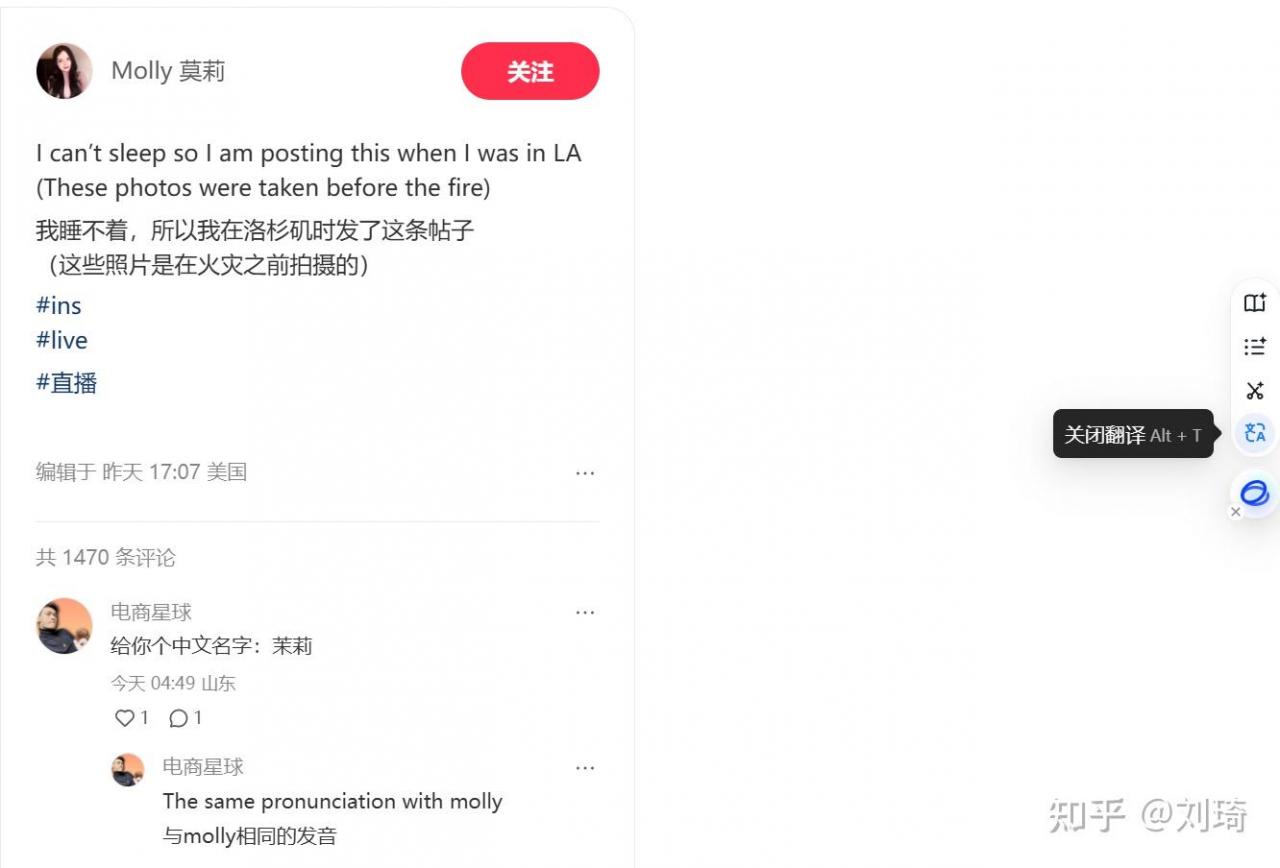

第一,可以选择保留原文,这样可以把原文和译文对照来看,便于理解或者学习;

第二,可以选择调用大模型,对于一些复杂的、不适合机翻的文本,可以得到更好理解的人话输出。

如果你的浏览器安装有AI助手插件,多半就自带这个东西,比如豆包和智谱清言。

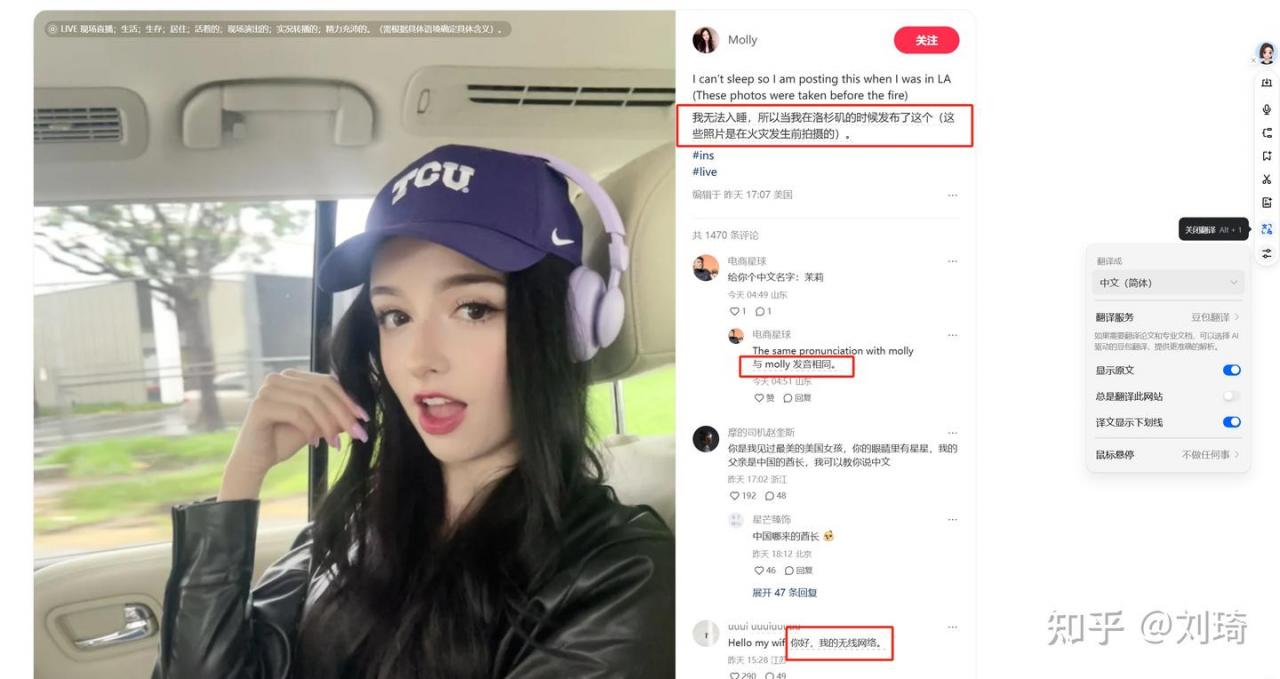

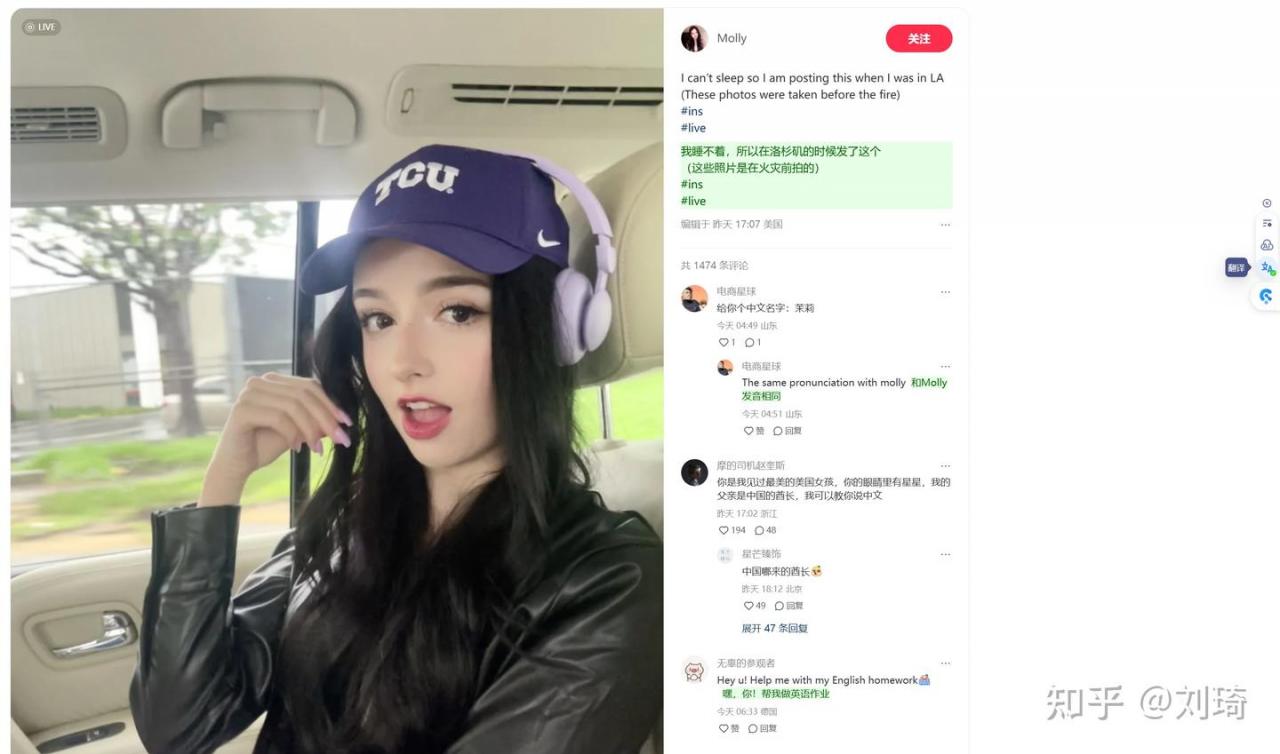

通常你可以在悬浮球或者侧边栏找到翻译功能,例如下面截图就是豆包悬浮球的翻译入口,我用红框圈出来的加了下划线的中文,就是翻译结果。如果你习惯使用侧边栏,打开侧边栏的时候,下方也会有翻译此页面的提示。

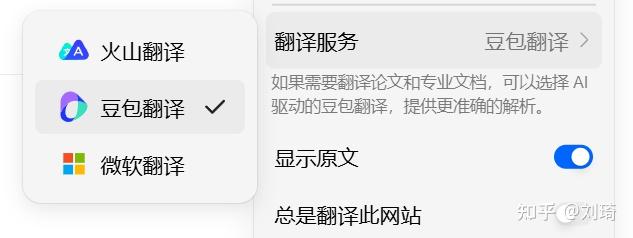

翻译服务除了调用豆包之外,也可以选择不调用大模型的普通翻译,比如微软翻译。

智谱清言跟豆包类似,悬浮球和侧边栏都有入口。

但智谱的设置要少一些,不可以用机翻翻译,当前的插件版本也不支持译文标注。

我自己更习惯用Glarity这个浏览器插件。

有几个让我更舒适的点:①机翻可选谷歌翻译②通过API调用大模型,用什么模型可以自选③译文的样式更多一些。

如果你不介意稍微繁琐点也可以参考我的方案:

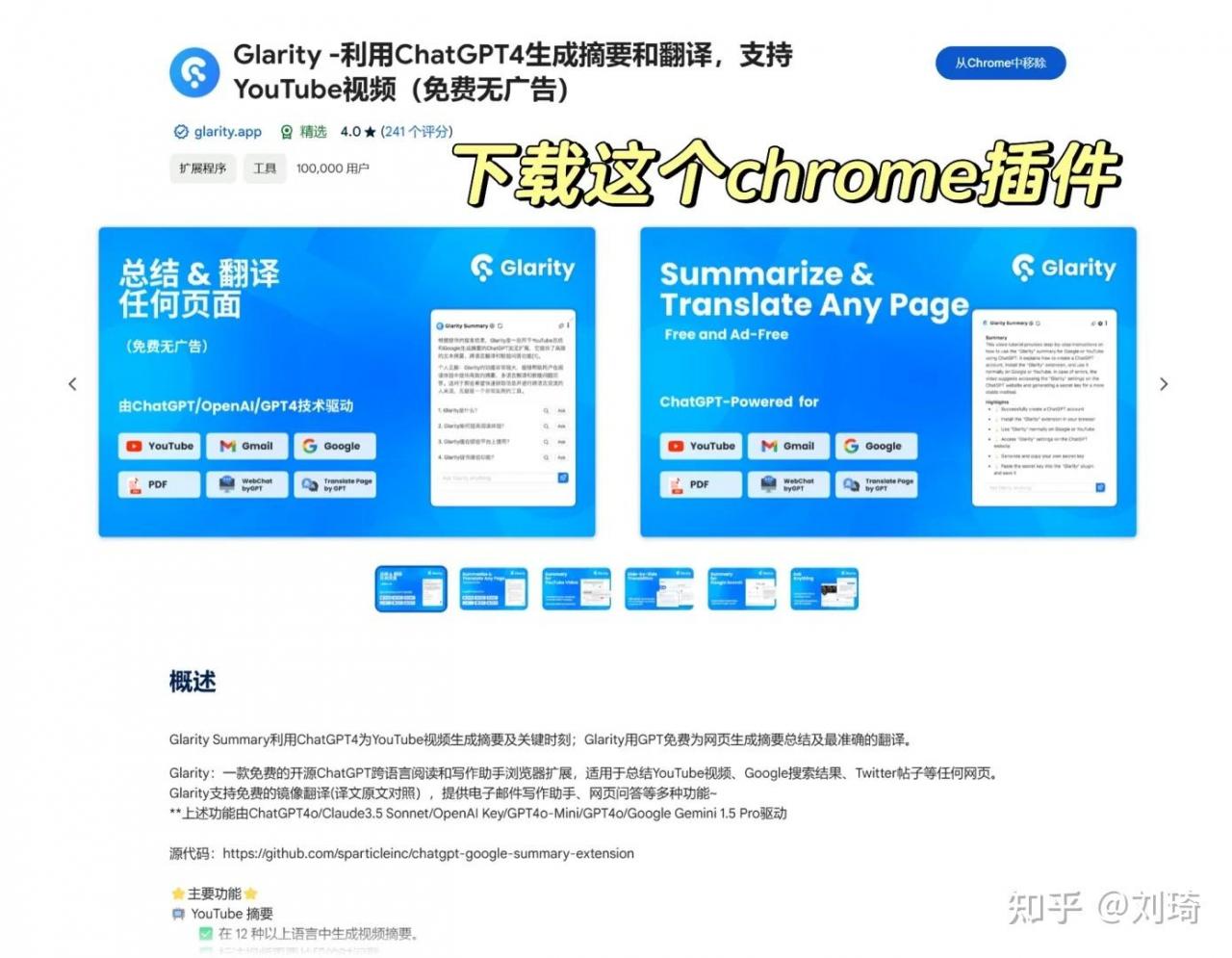

首先在Chrome应用商店安装插件。

然后如果你愿意付费的话,可以直接开通他们的会员,获得调用GPT-4o/Claude 3.5 Sonnet/Gemini Pro这些大模型的能力。

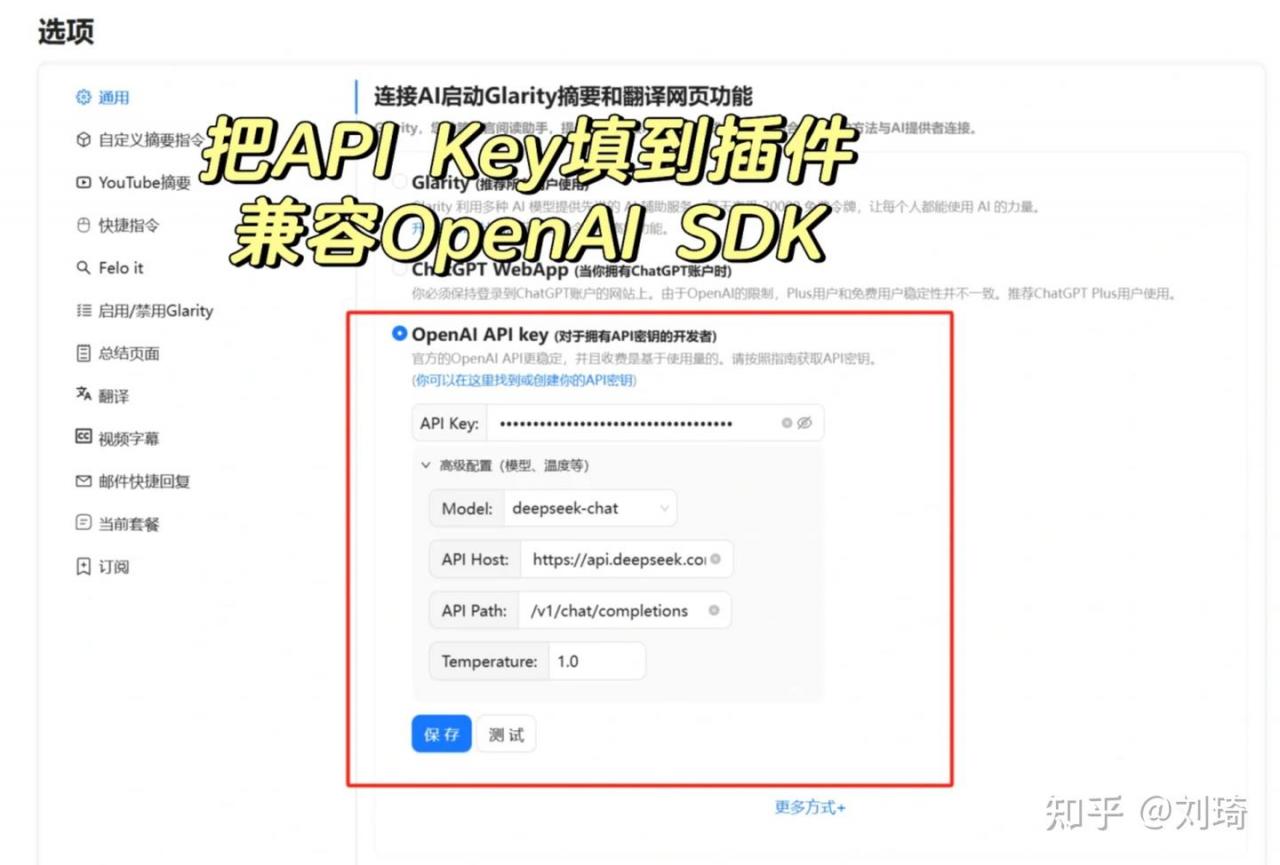

当然我是不想付费的,Glarity也允许你使用自己的API Key和接口,所以我选择填写自定义API Key。

其实准确说它只支持OpenAI、Azure、Google Gemini三家的API Key,但我们可以通过One API把几乎市面上所有的大模型转换成OpenAI的API格式。所以只要它支持OpenAI的API并且可以自定义API接口,就相当于市面上大多数AI大模型都可以调用。

One API稍微有点复杂了先不展开,这里我更推荐使用DeepSeek。

其一,DeepSeek能力足够强,其二,DeepSeek原生兼容OpenAI的SDK(千问也可以),不经过One API的转换就可以直接填。

先直接进入DeepSeek官网注册,选择右边这个“接入API”。

注册后会免费赠送10块钱余额,相当于大约500w tokens,如果单纯用来翻译可以用很久。

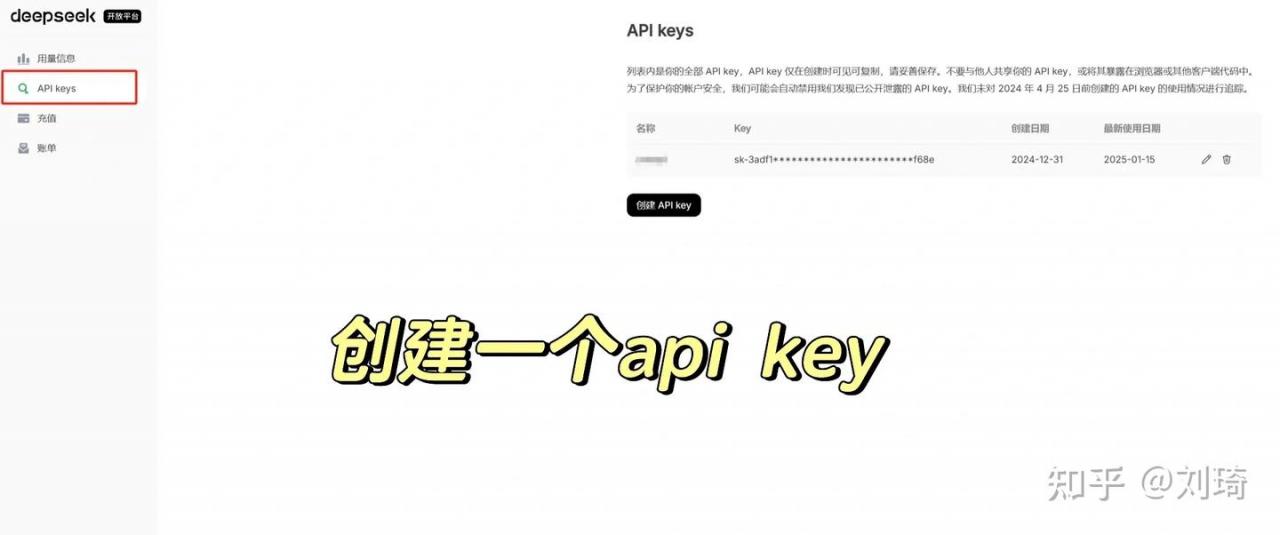

然后在页面左边选择API keys,创建一个api key。

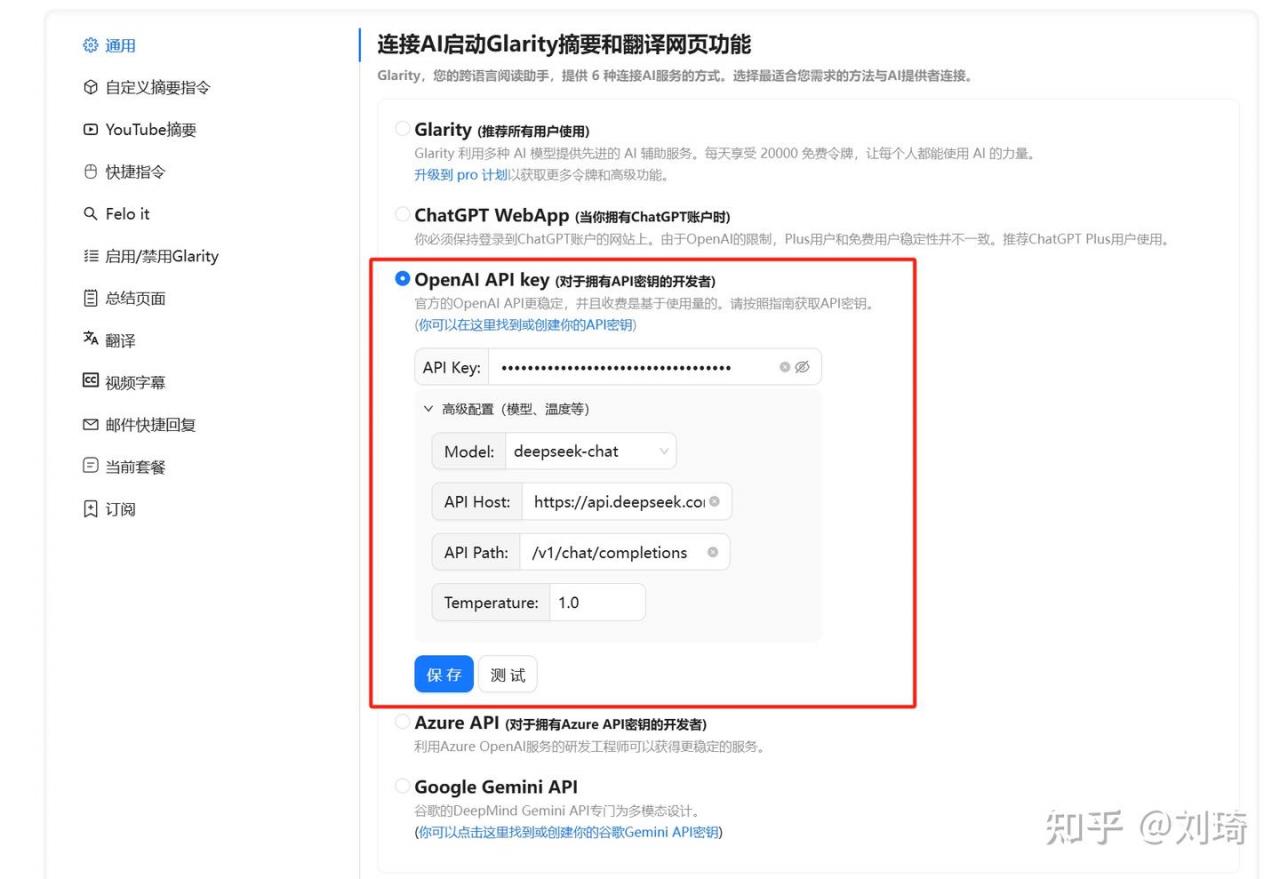

回到刚才的Glarity设置界面,参考下图填写。

Model:deepseek-chat

API Host:api.域名,前面加https

API Path:/v1/chat/completions

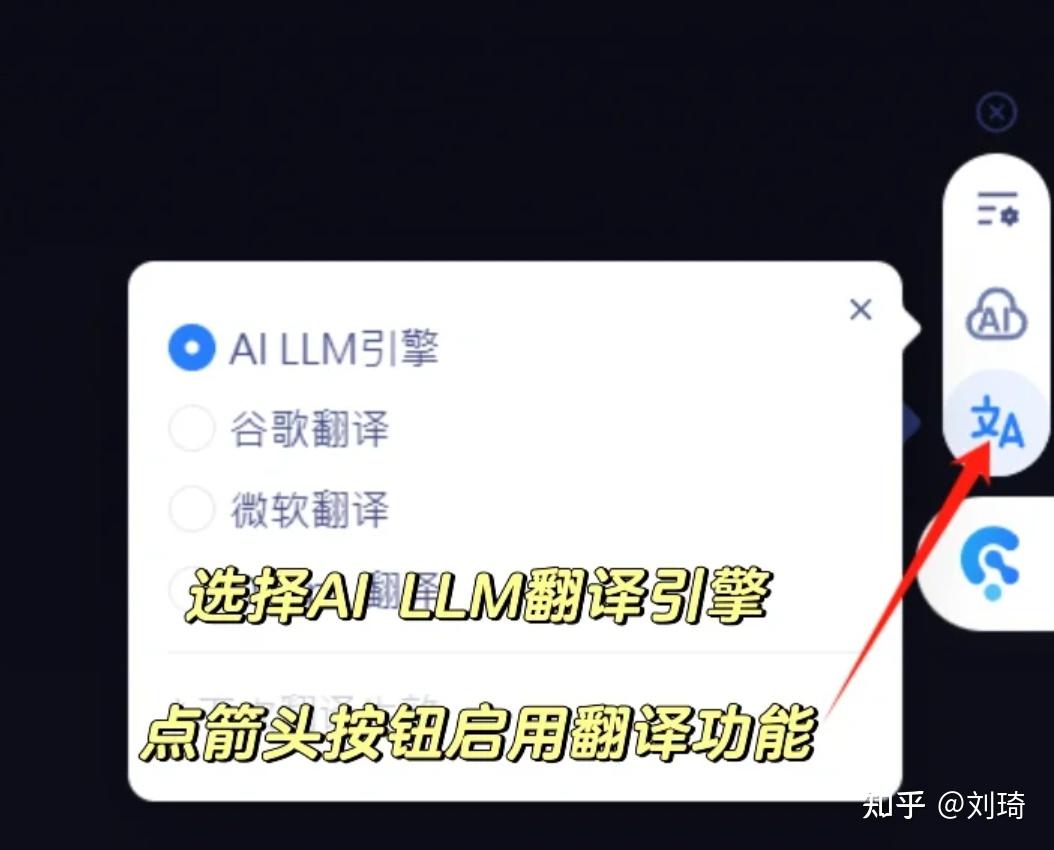

Temperature:0.7-1如果使用AI翻译,就选到第一个AI LLM引擎,如果机翻足够,选谷歌翻译也行。

通过API调用DeepSeek的时候,它对敏感文本的审核不会有那么敏感。尤其是在翻译场景,一些让豆包和智谱无法工作的内容,比如一些日文影片的标题,使用这个方案是可以进行正常翻译的。

译文的可选样式也更多,像是加粗、倾斜、下划线、高亮都是有的,比如我就比较喜欢用绿色高亮。

Glarity还有一个重点推荐的功能值得单独提一下:快捷指令。

通过快捷指令可以快速对选中的文本进行大模型处理,并且这里支持自定义prompt,如果你有很多在浏览器里面,需要经过大模型格式化分析或处理的内容,这个快捷指令会十分快捷。

(PS:豆包也有这个功能,但大模型是豆包的模型。)

当然了,对于小红书来说,沉浸式翻译也有不足的地方:它只能在网页浏览器生效。

如果你希望在APP里面就能看到外文翻译,那就还是得等待小红书官方的动作了。这也并非没有先例,X APP就带有内置的翻译功能。

当前面的章程都被敲定,落地起来会很快。