链接:https://zhuanlan.zhihu.com/p/21232669995

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

你好,我是阮小贰。

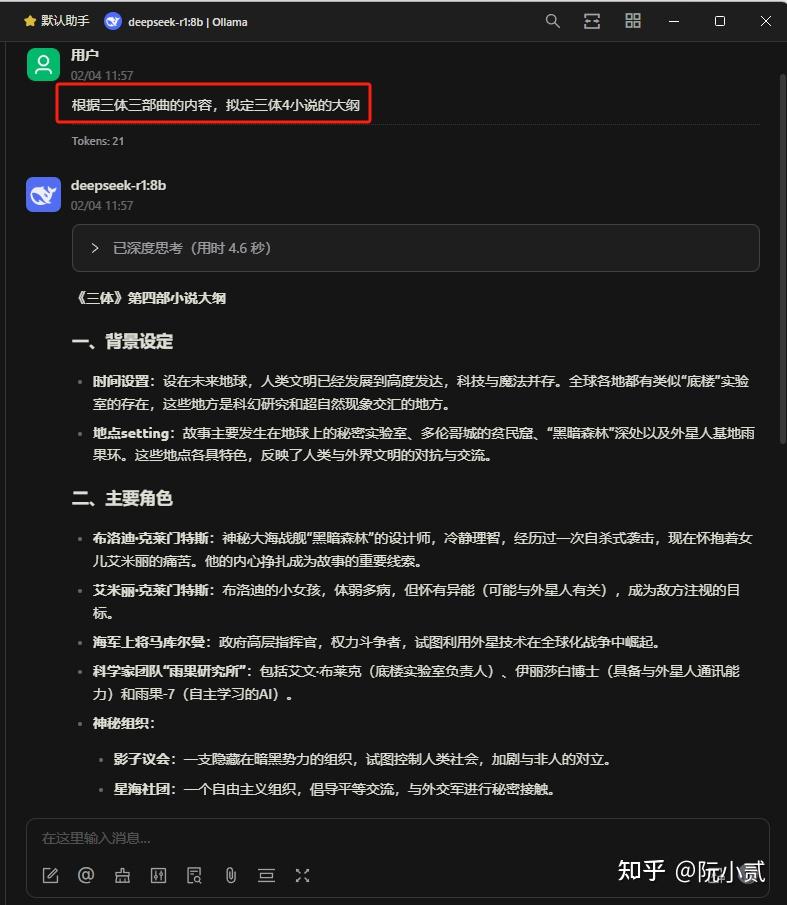

老规矩,先看效果:

之前的文章里面已经说过了,虽然我们本地部署了DeepSeek R1,

但是使用起来并不方便(需要在命令行里面进行对话互动),

所以就需要用到类似于Open-WebUI、ChatBox、Cherry Studio等可视化界面工具,

前面已经介绍过Open-WebUI、ChatBox。

今天给大家介绍一下Cherry Studio。

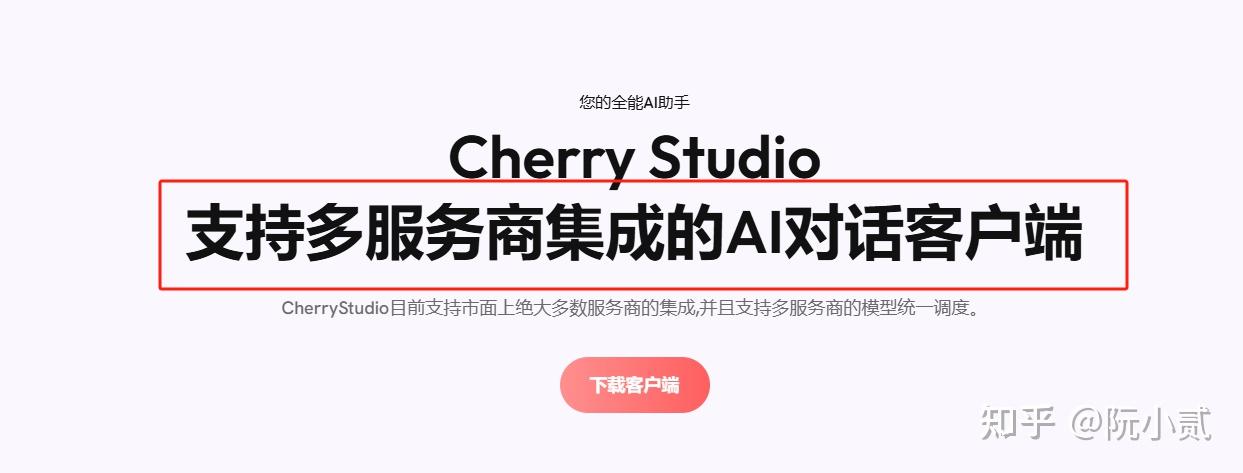

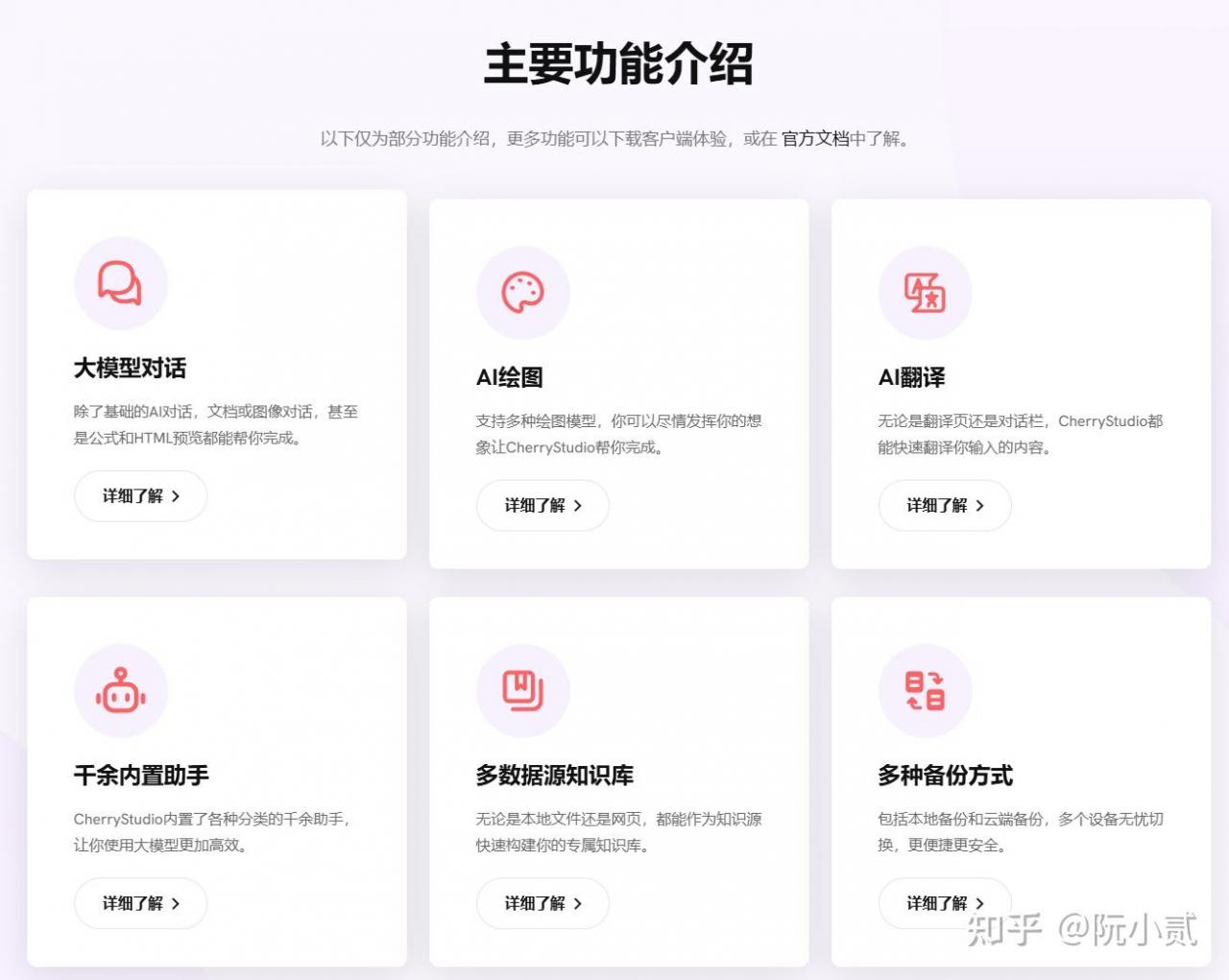

一、Cherry Studio介绍

Cherry Studio是什么?

能用来干嘛?

看看官方的介绍。

简单理解,就是Cherry Studio里面内置集成了很多大模型服务商,

这样我们只需要做些简单的配置就可以使用大模型了。

而且是可视化界面,交互操作起来就比较方便。

二、具体实操

那么整体步骤就三步:

1、安装Cherry Studio客户端

2、配置Ollama模型

3、验证Ollama模型

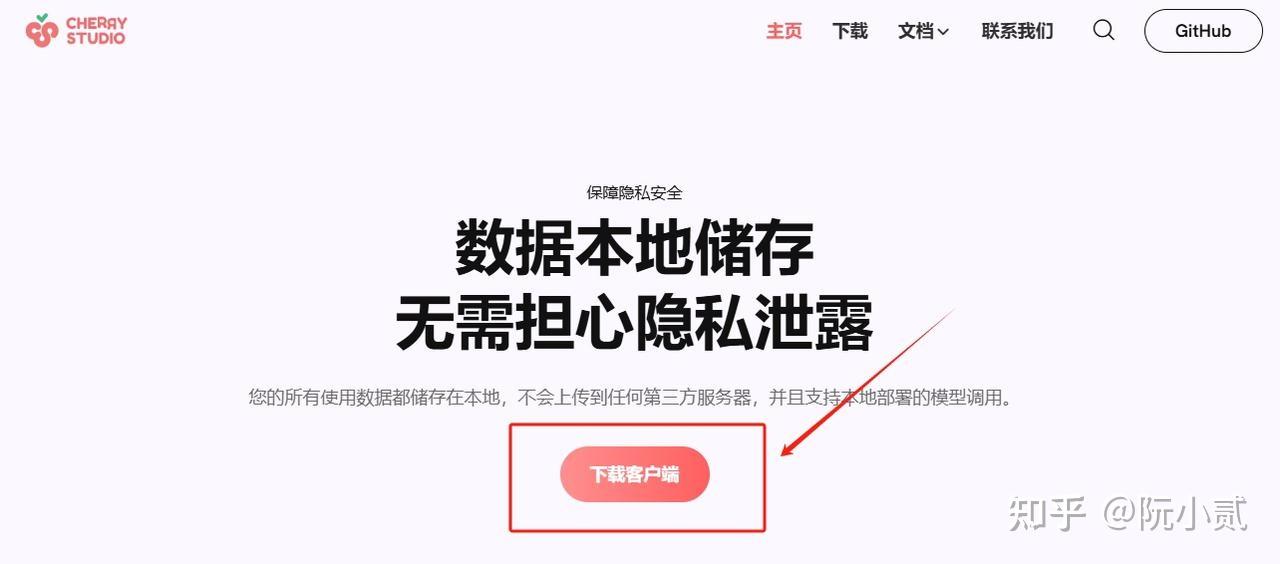

2.1、安装Cherry Studio客户端

下载Cherry Studio安装包

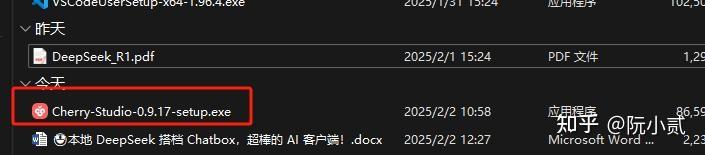

到官网找到对应版本的安装包进行下载

等待下载完成

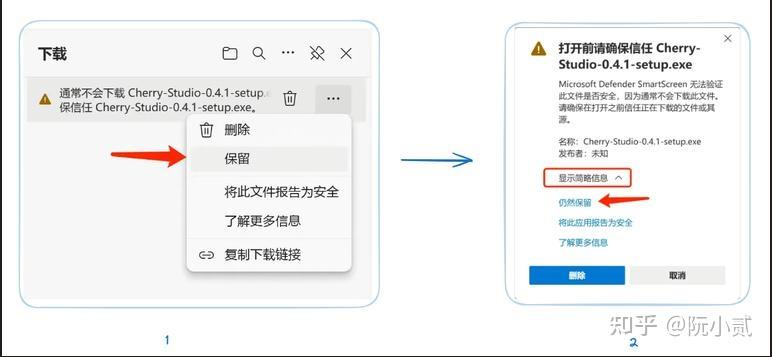

如果出现浏览器提示文件不被信任等情况选择保留即可

选择【保留】→ 【信任 Cherry-Studio】

打开文件。

安装成功。

2.2、配置Ollama模型

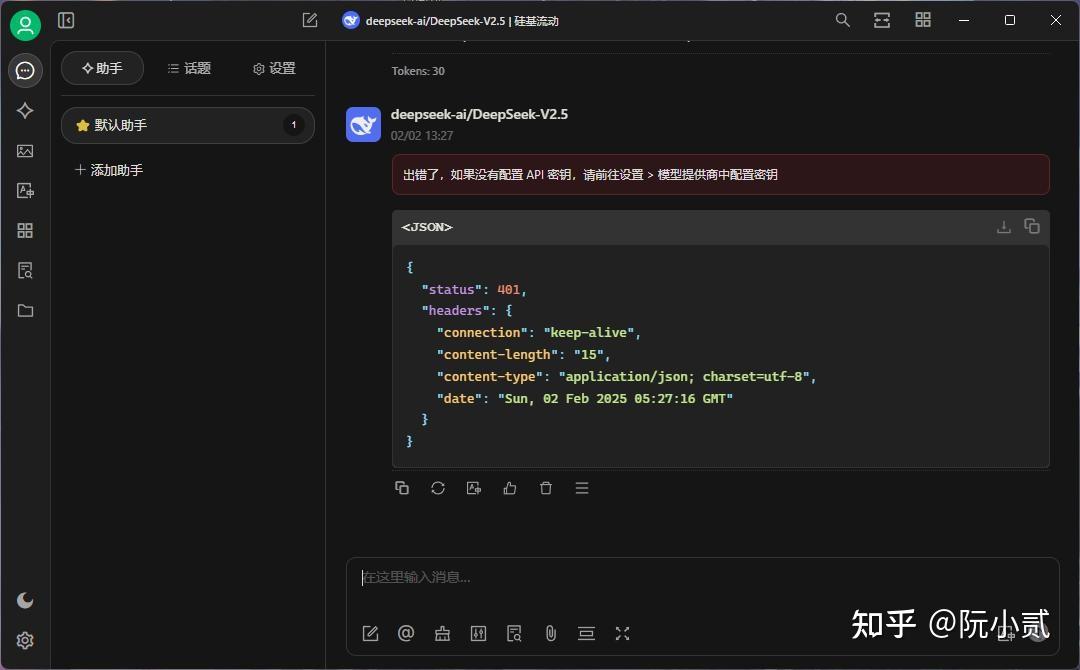

如果不配置API,是操作不了的。会提示错误

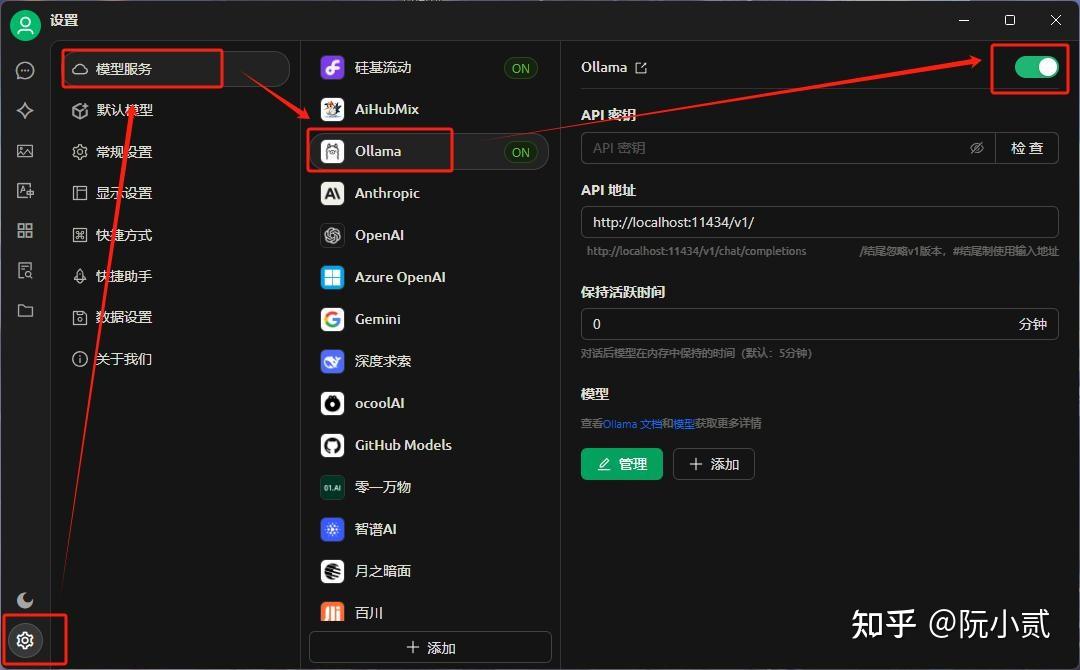

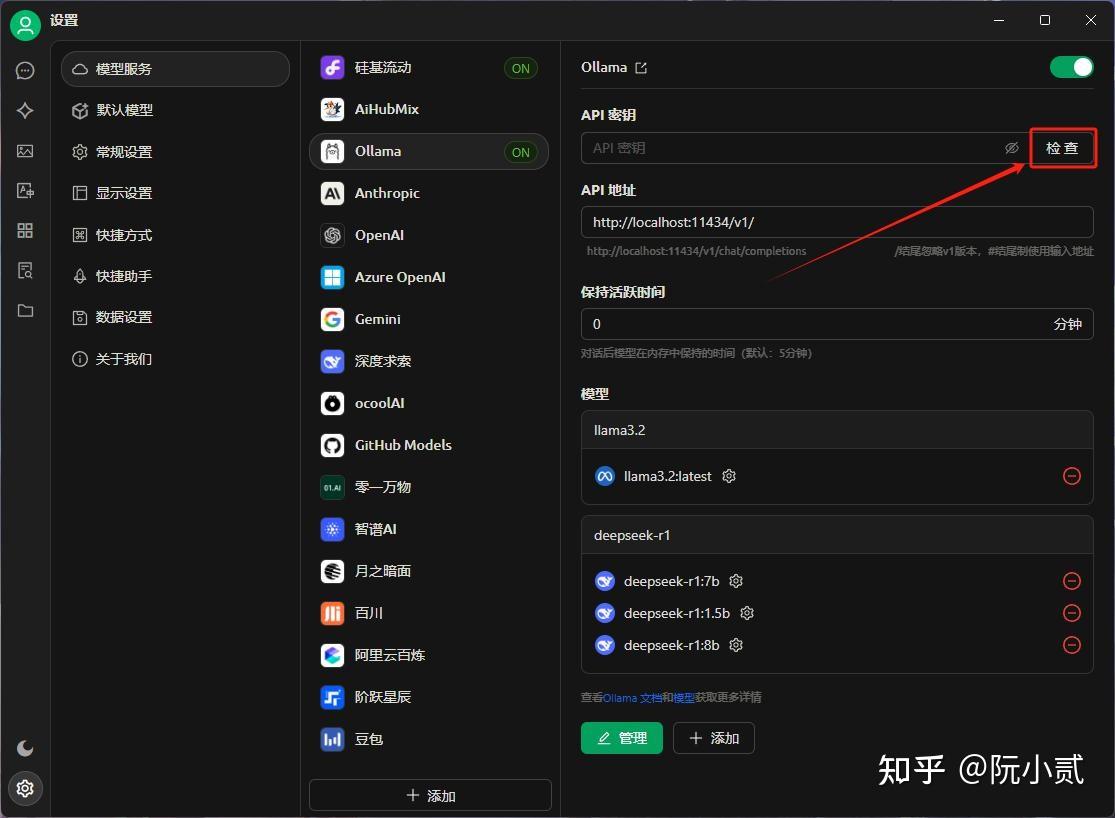

左下角【设置】——》【模型服务】——》Ollama——》开启

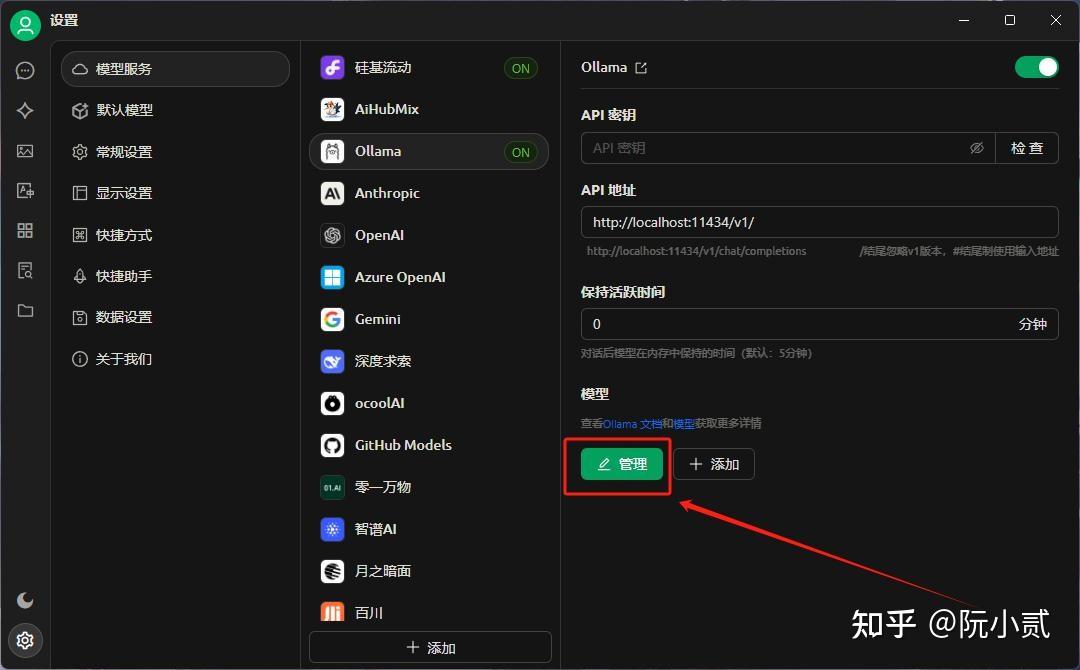

点击下方【管理】

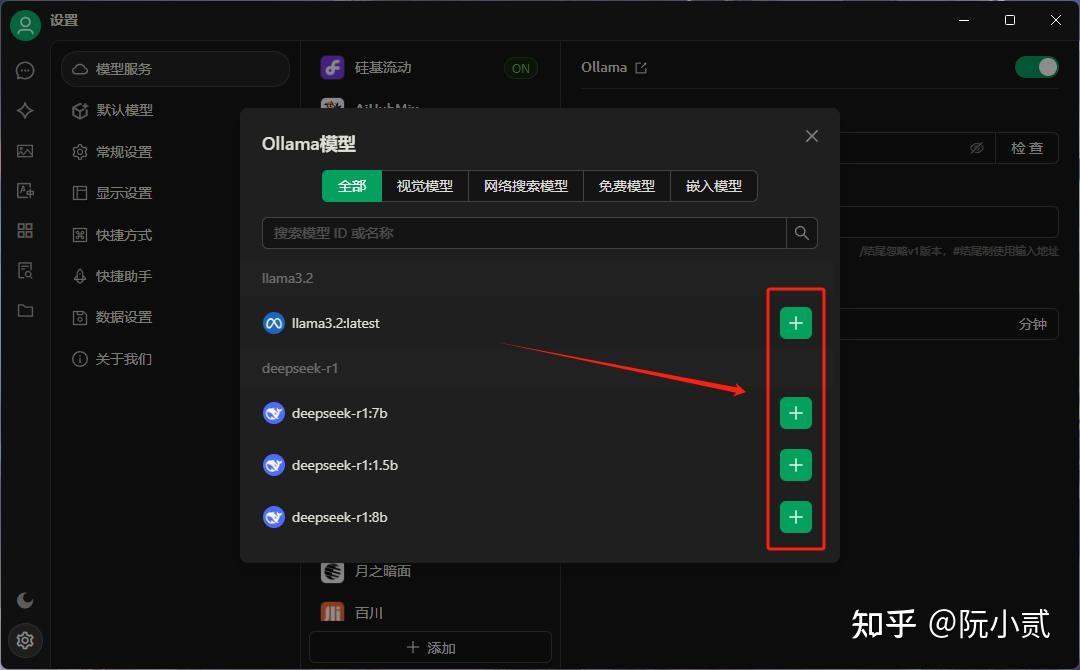

如果本地Ollama服务已经开启了,会自动加载出DeepSee推理模型,然后添加自己需要的

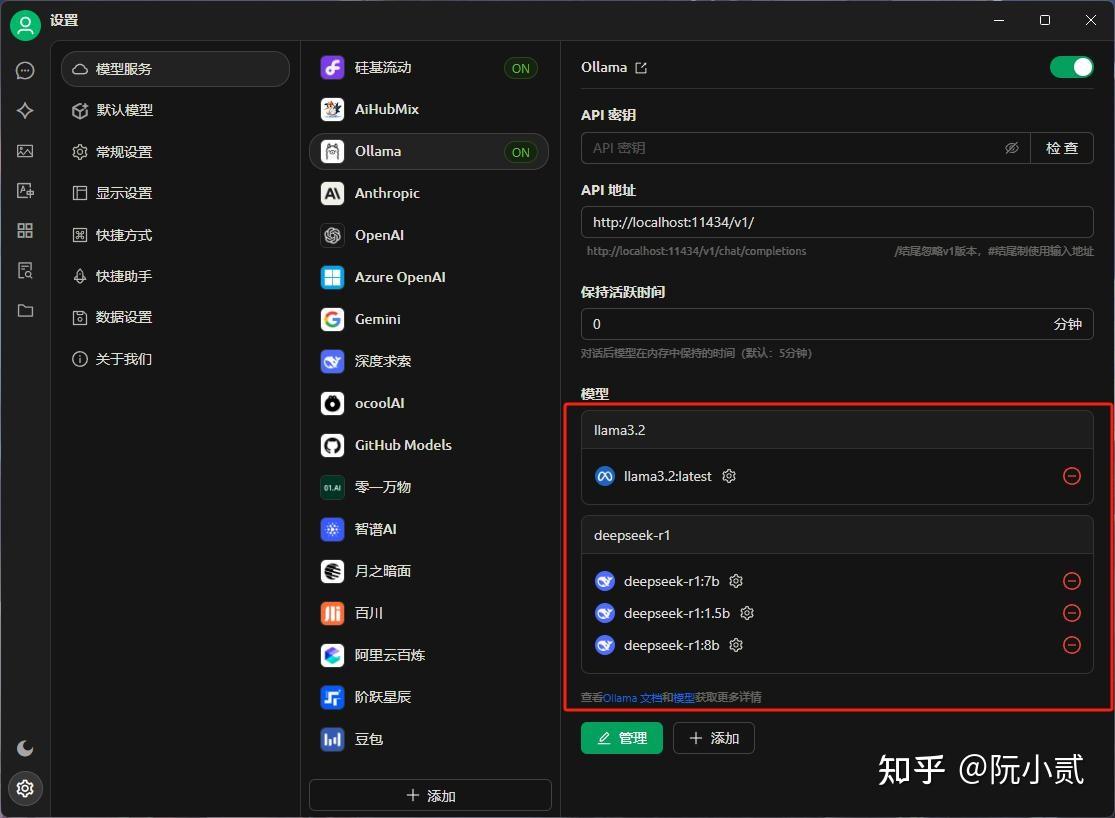

DeepSee推理模型添加成功

2.3、验证Ollama模型

然后我们验证一下API服务情况。

这里注意,如果本地已经部署了Ollama服务,不需要填写API密钥,否则需要去官网申请API密钥

这里因为我本地已经部署了Ollama服务,所以不需要填写API密钥,直接点击【检查】即可

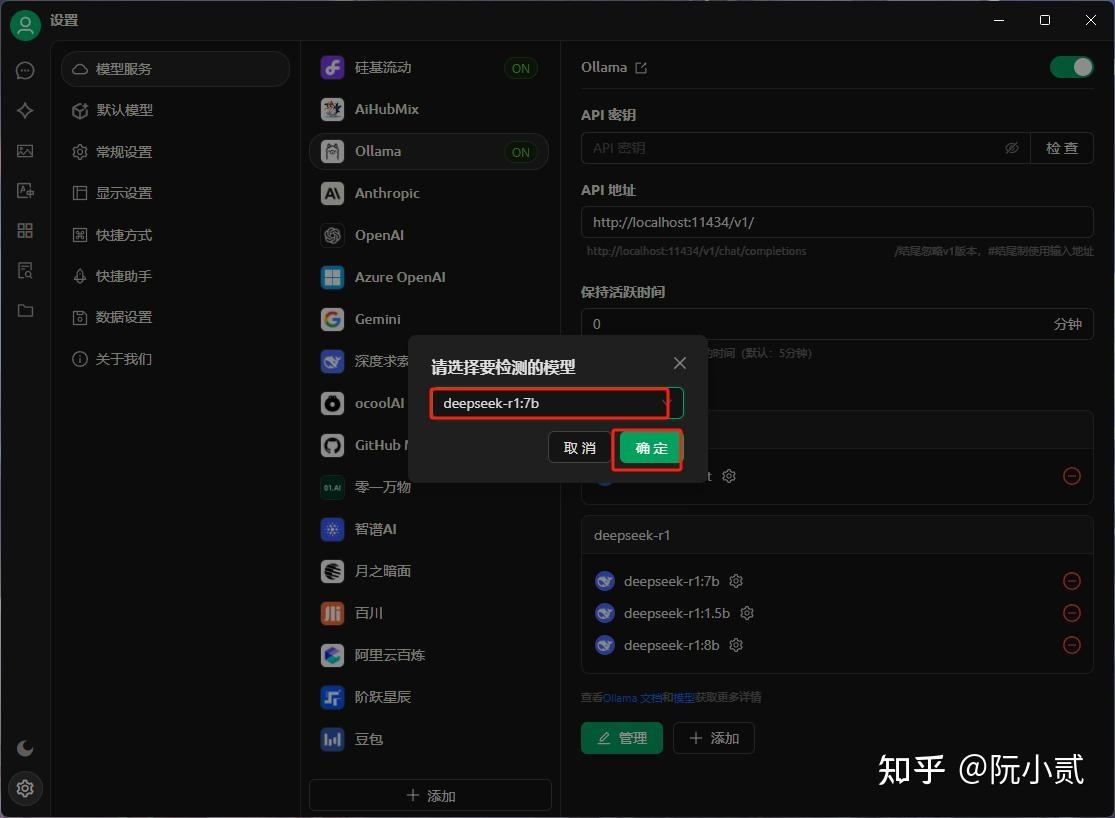

选择要检测的模型进行验证

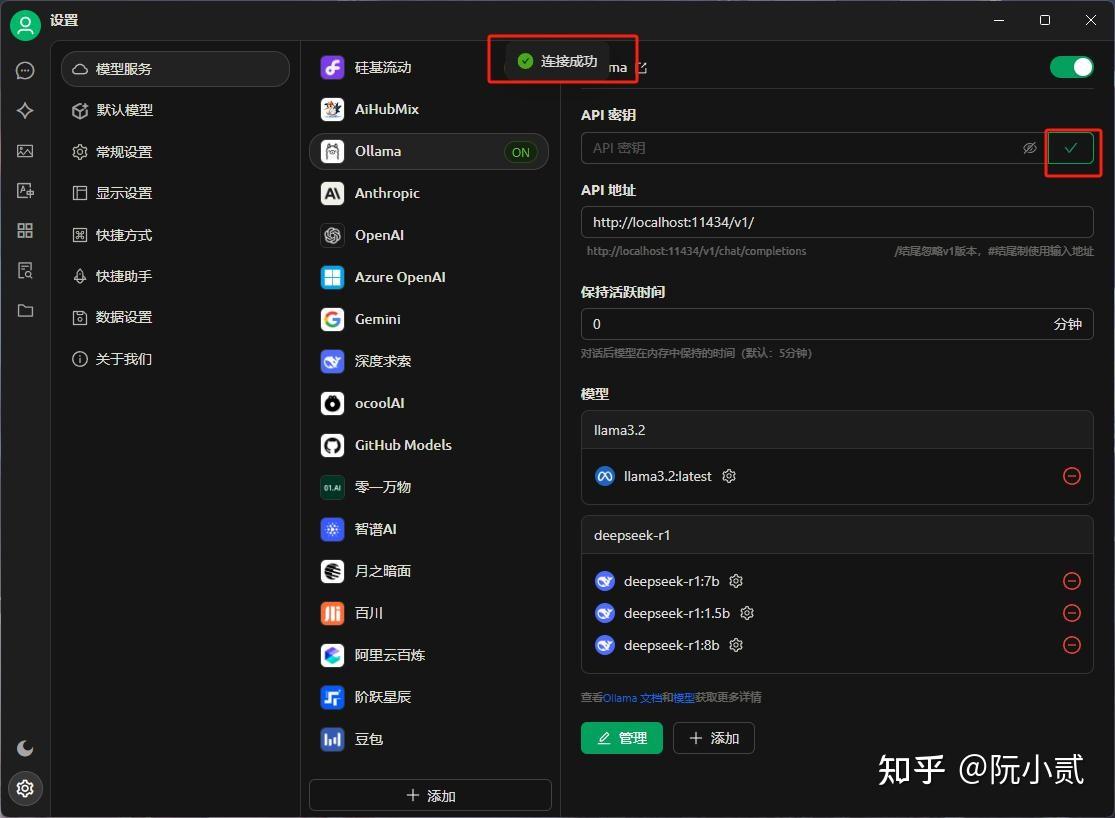

如果验证成功,会提示【连接成功】

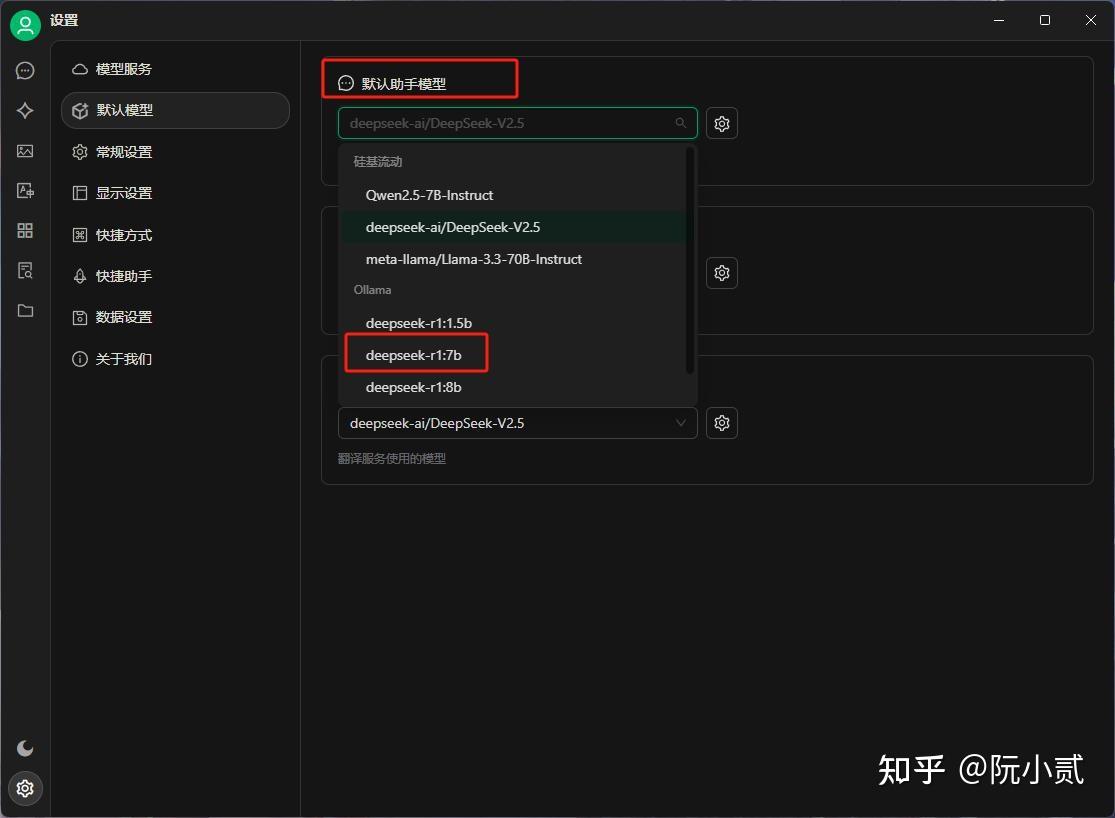

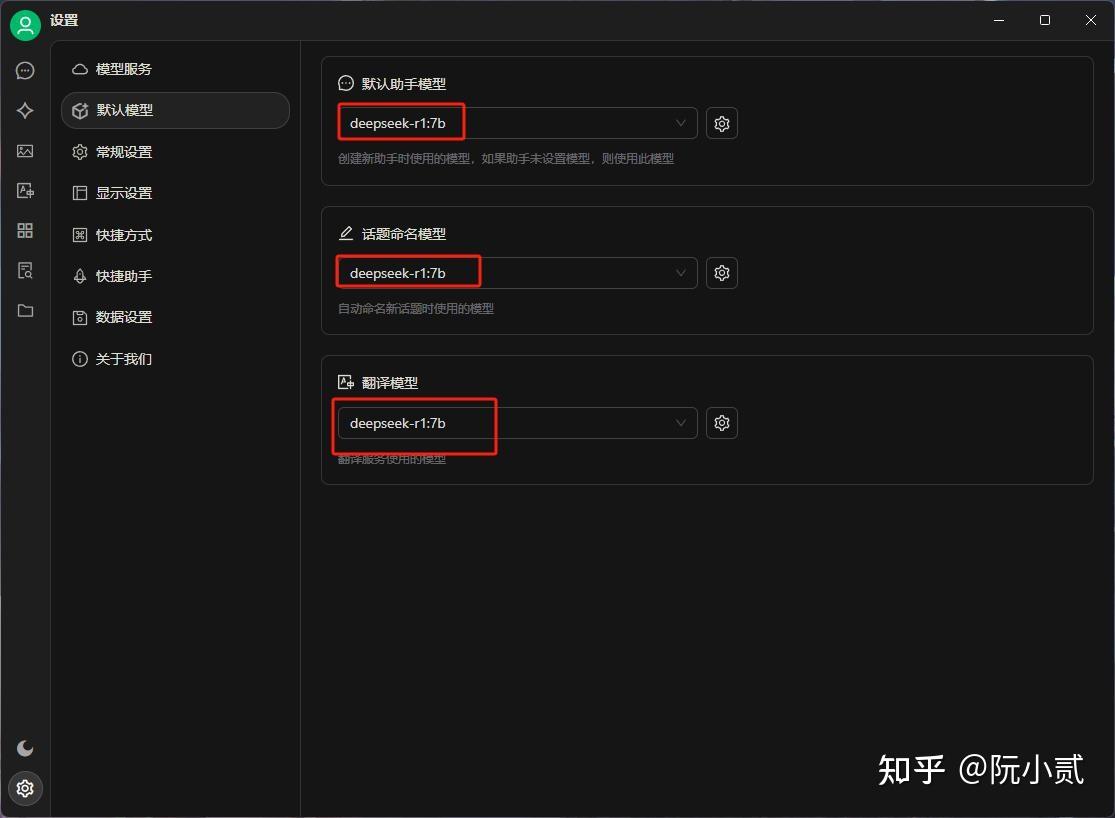

设置【默认模型】,这里我设置的是deepseek-r1:7b的推理模型

到这里,整个安装步骤就完成了,

接下来去正常对话就行了。

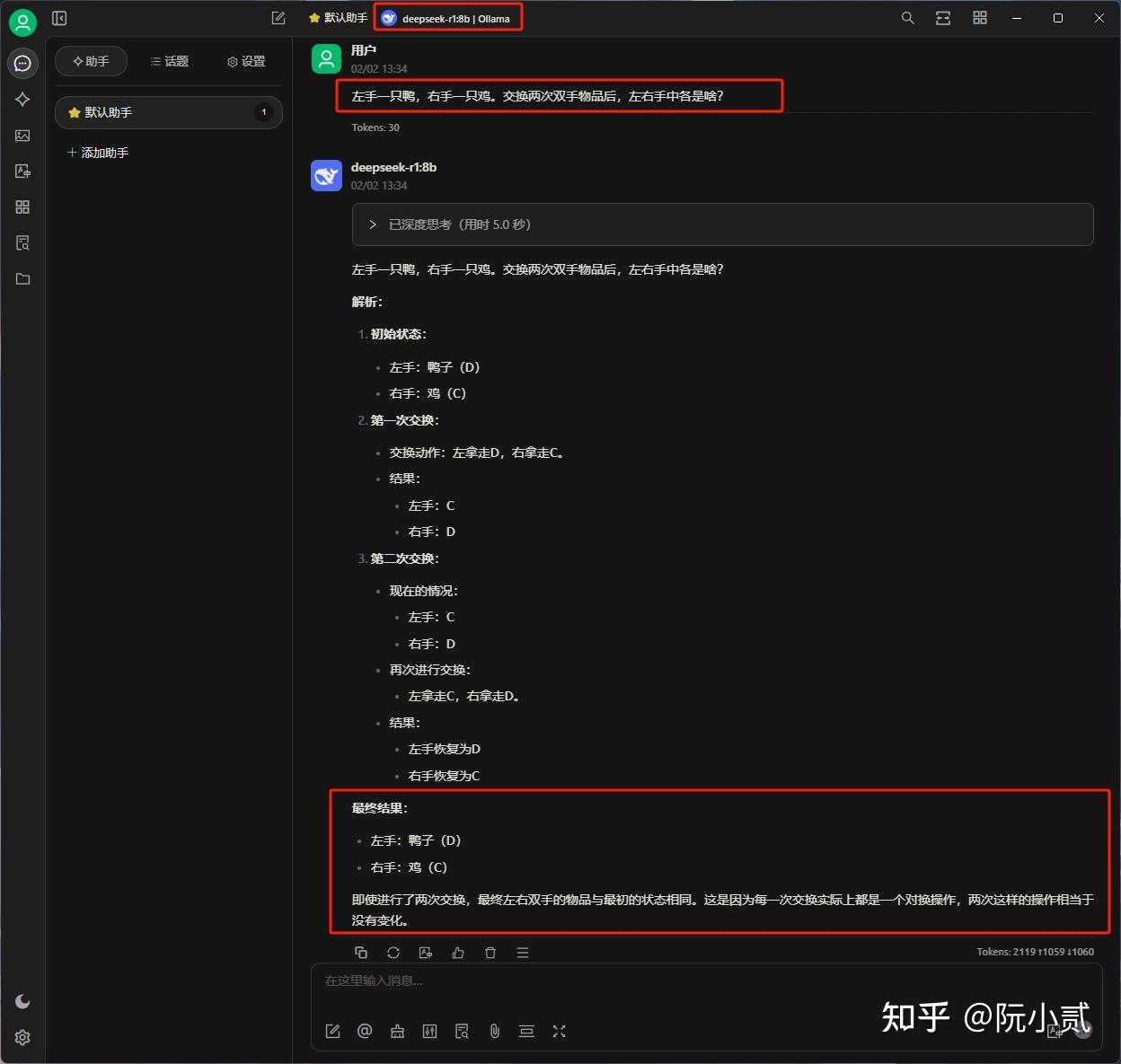

左手一只鸭,右手一只鸡。交换两次双手物品后,左右手中各是啥?

以上就是本期所有啦,

基本上能看到这里的都是人中龙凤!

如果觉得不错,随手点个赞、在看、转发三连吧!

谢谢你耐心看完我的文章~

下一篇文章我会教大家如何在本地基于DeepSeek搭建私有知识库。

大家敬请期待~

个人博客:小二项目网